讲AI,靠得住, 蓝色字体 求关注

哈喽,大家好!

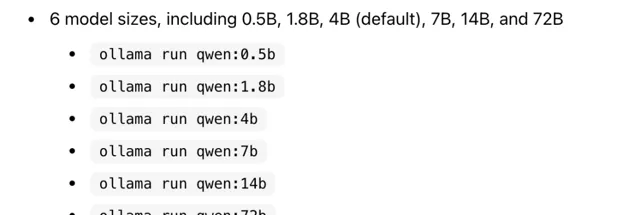

新年期间,通义千问发布了 Qwen1.5 大模型,包括0.5B、1.8B、4B、7B、14B和72B各个尺寸的大模型。

72B有个在线体验地址,我试了下,明显比上一个版本好很多。

这次发布的 Qwen1.5 最大的好处是可以在 ollama 平台使用,我之前分享过ollama,支持很多大模型,一条命令就可以运行,无需编程,告别 Python 环境的搭建

运行后,模型下载速度非常快,每秒100多M,分分钟就下载好一个大模型。

ollama 默认运行在 CPU 上,在普通的电脑上,跑 7B 及以下的大模型,推理速度都会非常快。

如果有 GPU,ollama 会把模型放到显存,加速推理。

我测试在本地跑 72B 大模型,模型大小 41GB,如果有 GPU ,至少 32G 显存可以跑起来。 如果没有GPU,可以用服务器跑,CPU要强一些,内存至少 64GB。

毕竟 72B 模型太大了,速度不会是特别流畅,基本是一个个字蹦的级别。 但,一个没有 GPU 的服务器跑 72B 的大模型, 已经很好了。

ollama 之所以快,是因为它运行的模型是经过 GGUF (GPT-Generated Unified Format)方式量化的。这种方式允许用户使用CPU来运行LLM,也可以将其某些层加载到GPU以提高速度。当然速度提升是以损失精度为代价的。

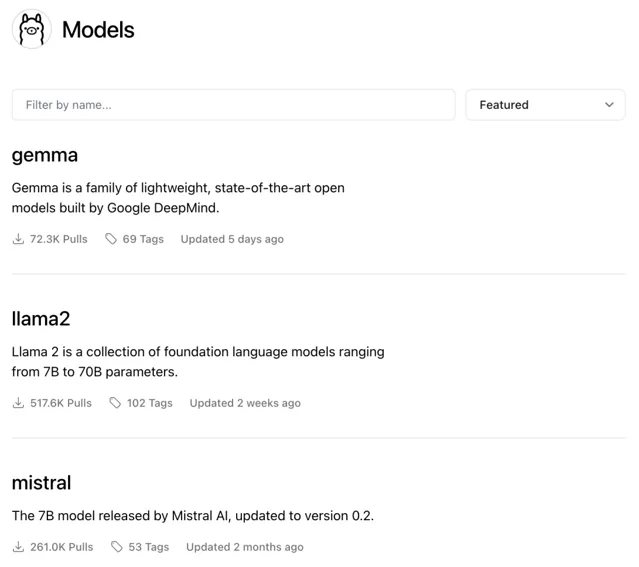

ollama 现在支持非常多的模型,包括最近爆火的 Gemma

渡码 公众号持续分享AI方面的应用、技术、资讯,欢迎关注。