今天給大家推薦的開源計畫,是由北京大學、騰訊、中國香港大學、清華大學聯合釋出的。

BrushEdit是"BrushEdit: All-In-One Image Inpainting and Editing"這篇論文的官方實作。

主要功能是透過提示詞來編輯圖片內容。

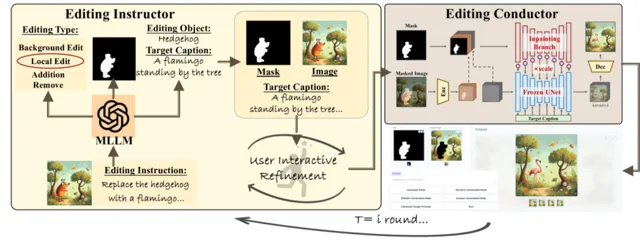

BrushEdit用了多模態大模型的能力來理解使用者的指令,透過雙分支修復模型實作了對影像的精細編輯。

雙分支修復模型還是有必要解釋下:

將影像修復任務分解為兩個並列處理的分支:一個分支負責提取和保留遮罩區域的特征,另一個分支則利用預訓練的擴散模型來生成或修復遮罩區域的內容,從而實作高品質的影像修復和編輯,同時保持背景的連貫性和自然性。

掃碼加入AI交流群

獲得更多技術支持和交流

(請註明自己的職業)

計畫簡介

BrushEdit是一個創新的互動式影像編輯框架,它結合了語言模型和修復技術,使使用者能夠透過自然語言指令進行無縫編輯。該框架利用預訓練的多模態大型語言模型和雙分支修復網路架構,實作添加物體、移除元素或進行結構性更改等多樣化編輯。它支持自由形式的指令編輯,允許使用者以互動式方式進行多輪編輯以達到滿意的結果。

DEMO

實作流程

1.使用者輸入指令:

使用者輸入一個自然語言編輯指令,例如「在頭上添加一個花環」。

系統使用預訓練的多模態大型語言模型(MLLMs)來解析指令,確定編輯的型別(如添加、移除、局部編輯、背景編輯)。

2.目標辨識:

根據編輯型別,系統辨識並確定需要編輯的主要物件,例如「花環」。

3.編輯掩碼和目標說明獲取:

系統利用預訓練的目標檢測模型生成編輯掩碼,確定編輯區域。

MLLMs結合編輯型別、目標物件和源影像來生成編輯後影像的目標描述。

4.影像修復:

使用雙分支修復模型BrushNet,根據目標描述和編輯掩碼執行實際的影像編輯。

模型的一個分支專註於背景資訊的提取和保留,另一個分支負責根據文本提示生成編輯區域的前景內容。

5.互動式細化:

使用者可以互動式地修改中間控制資訊,如編輯掩碼或編輯後影像的目標描述。

使用者可以叠代執行上述步驟,直到達到滿意的編輯結果。

6.輸出編輯後的影像:

經過一系列叠代和細化後,系統輸出最終編輯後的影像,滿足使用者的編輯指令和視覺需求。

計畫連結

https://github.com/TencentARC/BrushEdit

關註「 開源AI計畫落地 」公眾號

與AI時代更靠近一點

關註「 AGI光年 」公眾號

獲取每日最新資訊

關註「 向量光年 」公眾號

加速全行業向AI轉變