計畫簡介

果真言出必行,馬斯克承諾的開源大型模型 Grok 終於面世了!

在今日淩晨,由馬斯克領銜的大型模型企業 xAI 正式公布了一項重要動作:開源了一個擁有 3140 億參數的混合專家模型(MoE)「Grok-1」,連同其模型權重和網路架構一並公開。

此舉將 Grok-1 樹立為目前最大參數量的開源大語言模型。

在這個關鍵時刻,馬斯克自然不放過機會,對 OpenAI 進行了一番諷刺,他表示:「我們很想探索 OpenAI 中‘開放’的那一部份」。

掃碼加入交流群

獲得更多技術支持和交流

(請註明自己的職業)

模型

回到模型本身,Grok-1 是從零開始訓練的,而且沒有為任何特定套用(例如對話系統)進行過微調。相比之下,在 X(原名 Twitter)上使用的 Grok 大型模型已經進行了微調,因此其行為與原始權重版本不同。

Grok-1 模型的詳細資訊包括:

· 基礎模型基於大量文本數據訓練,未針對任何特定任務進行微調;

· 是一個包含 3140 億參數的混合專家(MoE)模型,給定 token 的啟用權重為 25%;

· 2023 年 10 月,xAI 使用 JAX 庫和 Rust 語言的自訂訓練棧從頭開始進行訓練。

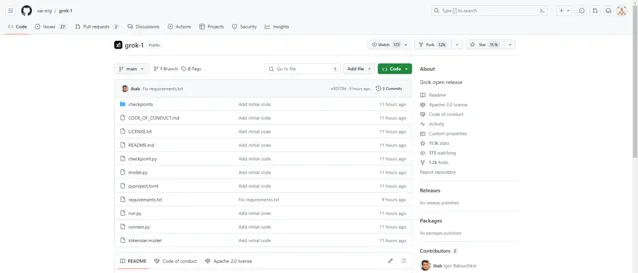

xAI 根據 Apache 2.0 授權證公開了 Grok-1 的權重和架構。Apache 2.0 授權證允許使用者自由使用、修改和分發軟體,不論是個人還是商業用途。計畫釋出僅10小時,就已獲得 11.1k 星標,人氣持續上升。

開源你也大機率用不了

Grok-1模型因其巨大的參數量—314億個參數—而引起了網友們的極大興趣。由於每個參數需要2字節的記憶體來儲存,整個模型大約需要628GB的GPU記憶體才能執行。為了達到這樣的記憶體需求,就需要使用多個高效能GPU。

以目前市場上的高端GPU,NVIDIA H100為例,每個提供大約80GB的視訊記憶體。根據這個配置,執行完整的Grok-1模型大概需要8個H100 GPUs來提供足夠的記憶體空間。這是一種非常高端的配置,通常只有在專業的數據中心或者具備先進計算資源的研究機構中才能找到。對於大多數個人使用者和小型開發團隊來說,這種配置是不切實際的。因此,想要執行如此龐大的模型,就需要獲得相應級別的硬體支持,這通常意味著相當大的投資。

使用

這個倉庫包含用於載入和執行 Grok-1 開放權重模型的 JAX 範例程式碼。

請確保下載了檢查點,並將 ckpt-0 目錄放在 checkpoint 中。然後,執行

pip install -r requirements.txtpython run.py

以測試程式碼。

該指令碼載入檢查點,並在一個測試輸入上從模型中采樣。

由於模型的體積很大(314B 參數),需要一台具有足夠 GPU 記憶體的機器來用範例程式碼測試模型。這個倉庫中的 MoE 層的實作並不高效。選擇這種實作是為了避免需要自訂核心來驗證模型的正確性。

計畫連結

https://github.com/xai-org/grok-1

關註「 開源AI計畫落地 」公眾號