整理 | 王軼群

責編 | 唐小引

出品丨AI 科技大本營(ID:rgznai100)

越接近真相的人,往往越知道其風險。

人工智慧目前的發展路徑是否健康,還是暗藏危險,還是精通 AI 技術且在全球頂尖的 AI 公司內部接近生產一線的人,更有發言權。

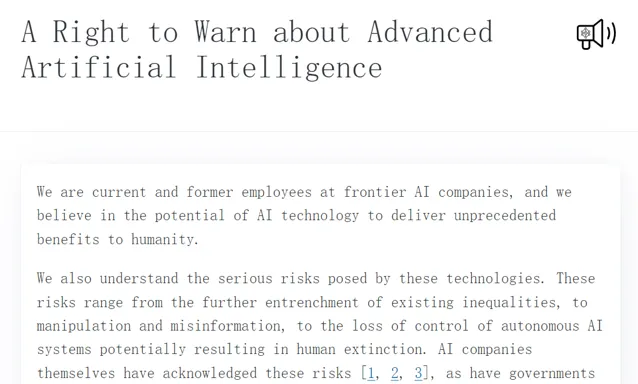

而就在剛剛,這些人不再保持沈默,釋出了聯名簽署的公開信。今日淩晨,13名來自 OpenAI 及谷歌 DeepMind 的前任及現任員工,釋出公開信劍指包括 OpenAI 在內的前沿 AI 科技公司的魯莽和保密文化,闡明目前人工智慧行業缺乏足夠監管、需要全面改革,並呼籲領先人工智慧公司建立更高的透明度並為吹哨人提供更多保護。

該份公開信刊載在 righttowarn.ai 網站上,網站網域名稱和公開信的標題皆在捍衛這些頂尖 AI 公司員工對先進人工智慧發出警告的權利。

信件的正文如下:

我們是前沿人工智慧公司的現任和前任員工,我們相信人工智慧技術有潛力為人類帶來前所未有的利益。

我們也了解這些技術帶來的嚴重風險。這些風險包括進一步加劇現有的不平等、操縱和誤導資訊,以及失去對自主人工智慧系統的控制,可能導致人類滅絕。人工智慧公司本身已經承認了這些風險 ,世界各國政府和其他人工智慧專家也承認了這些風險。

我們希望,在科學界、政策制定者和公眾的充分指導下,這些風險能夠得到充分緩解。然而,人工智慧公司有強烈的經濟動機來逃避有效的監督,我們認為客製的公司治理結構不足以改變這一現狀。

人工智慧公司掌握著大量非公開資訊,包括其系統的能力和局限性、保護措施的充分性以及不同型別傷害的風險水平。 然而,它們目前只有很弱的義務向政府分享部份資訊,而對民間社會則沒有任何義務。我們認為,不能指望它們都自願分享這些資訊。

只要政府對這些公司沒有有效的監督,現任和前任員工就是少數可以要求他們向公眾負責的人。然而,廣泛的保密協定阻止我們表達我們的擔憂,除非向那些可能未能解決這些問題的公司表達。普通的舉報人保護措施是不夠的,因為這些公司側重於非法活動,而我們擔心的許多風險尚未受到監管。 鑒於整個行業都發生過此類案件,我們中的一些人有理由擔心各種形式的報復。 我們並不是第一個遇到或談論這些問題的人。

因此,我們呼籲前沿人工智慧公司遵守以下原則:

公司不會簽訂或執行任何禁止因風險相關問題而對公司進行「貶低」或批評的協定,也 不會透過妨礙任何既得經濟利益來報復與風險相關的批評 ;

公司將為現任和前任員工提供 可驗證的匿名流程 ,以便他們向公司董事會、監管機構以及具有相關專業知識的適當獨立組織提出與風險相關的擔憂;

公司將 支持公開批評的文化 ,並允許其現任和前任員工向公眾、公司董事會、監管機構或具有相關專業知識的適當獨立組織 提出對其技術的風險相關擔憂,只要商業秘密和其他智慧財產權利益得到適當保護 ;

公司不會對在其他流程失敗後公開分享風險相關機密資訊的現任和前任員工進行報復 。我們承認,任何報告風險相關問題的努力都應避免不必要地泄露機密資訊。因此,只要存在向公司董事會、監管機構和具有相關專業知識的獨立組織匿名提出疑慮的恰當流程,我們就會接受首先應透過此類流程來提出疑慮。但是,只要不存在這樣的流程,現任和前任員工就應保留向公眾報告其疑慮的自由。

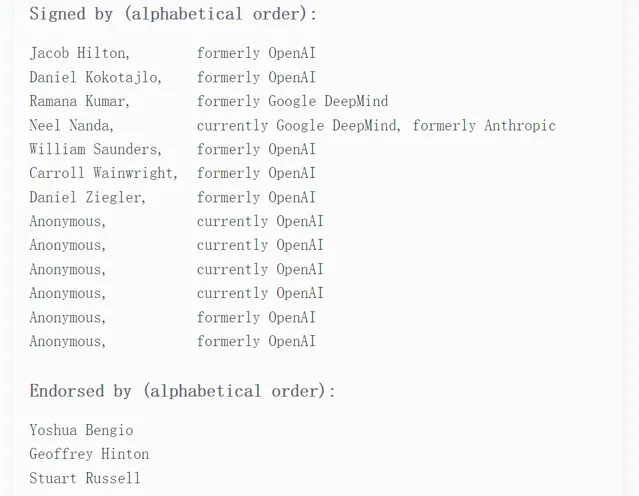

在公開信的姓名標示欄,可以看到簽署公開信的多位 OpenAI 前任雇員曾從事人工智慧安全工作。

一起簽署的,還有1名谷歌 DeepMind 現員工和1名谷歌 DeepMind 前員工,其中谷歌 DeepMind 的這名現員工,也是 Anthropic 的前員工。

此外, 為公開信背書的業內大佬還有兩位「人工智慧教父」Geoffrey Hinton 和 Yoshua Bengio,以及 AI 安全領域的頂尖專家 Stuart Russell 。

OpenAI 前員工和現員工揭竿而起

這次的團體組織者,正是 OpenAI 治理部門前研究員 Daniel Kokotajlo。

這是一個由前任和現任員工組成的團體,該團體表示,OpenAI 存在一種魯莽的文化。該組織由9名 OpenAI 現任和前任員工組成,多從事人工智慧安全工作,最近幾天他們舉行了集會,共同擔心該公司在防止其人工智慧系統變得危險方面,做得並不到位。

OpenAI 最初是一個非營利性研究實驗室,並於2022年釋出 ChatGPT 後進入公眾視野,該組織在嘗試構建通用人工智慧(AGI)時將利潤和增長放在首位。Daniel Kokotajlo 表示:「OpenAI 對於構建 AGI 感到非常興奮,他們正在不顧一切地競相成為第一個實作這一目標的人。」

此次聯名公開信,OpenAI 的相關參與者有7名 OpenAI 前員工、4名現任匿名員工。信中呼籲前沿 AI 公司的「不會對在其他流程失敗後公開分享風險相關機密資訊的現任和前任員工進行報復」的條目,明顯與最近頻頻爆出管理內幕的 OpenAI 有關。

超級對齊團隊的負責人 Ilya Sutskever 和 Jan Leike 於5月中旬相繼離開 OpenAI,他們正是公司安全風險的吹哨人,其團隊負責確保 AI 始終與其制造者的目標一致,不會做出不可預測的行為進而對人類造成傷害。

此外,另一位吹哨人、前 OpenAI 安全研究員 Leopold Aschenbrenner,在與聯名信同日釋出的 Dwarkesh Podcast 采訪中,也透露了更多關於遭遇解雇的細節:

Aschenbrenner 表示,他因向董事會分享了一份備忘錄,表達了對 OpenAI 安全實踐的擔憂,於今年4月被解雇。Leopold Aschenbrenner 還表示,他被問及團隊是否「對公司忠誠」OpenAI 聲稱他因泄露一份包含敏感資訊的檔而被解雇,但他否認了這一指控。

「我寫了一份關於 OpenAI 安全的內部備忘錄,我認為這份備忘錄嚴重不足,無法防止外國勢力竊取模型權重或關鍵演算法機密,」Aschenbrenner 說,並指出他「與幾位同事和幾位領導分享了這份備忘錄,他們大多表示這份備忘錄很有幫助。」

幾周後,OpenAI 遭遇了一次重大安全事故,這促使他「將這份備忘錄分享給了幾位董事會成員」。但他很快就受到了斥責。「我很清楚,領導層對我與董事會分享這份備忘錄非常不滿,」他說。「顯然,董事會就安全問題向領導層提出了質問。」

他因此收到了「人力資源部門的正式警告」。雖然他沒有立即被解雇,但幾個月後他被解雇時,公司告訴他,這一事件是導致他被解雇的一個因素。「當我被解雇時,公司明確表示安全備忘錄是我被解雇的主要原因。」

Aschenbrenner 被解雇前發生的事,據他所說,並沒有什麽大不了的。Aschenbrenner 寫了一份關於「準備、安全和安保措施」的檔,並與一些外部研究人員分享了這份檔。這「在當時的 OpenAI 完全正常」,其中的敏感資訊已被刪除。

而 OpenAI 則告訴 Aschenbrenner , 該檔包含敏感資訊,因為其包含「一行關於 2027-2028 年 AGI 規劃的內容」 。但 Aschenbrenner 表示, 這個規劃時間表是公開資訊:OpenAI 曾在自己的準備檔中提到希望在四年內解決對齊問題 ,該檔在 Aschenbrenner 分享自己的檔幾個月前就已釋出。

在 Aschenbrenner 看來,OpenAI 似乎在找理由解雇他。在被解雇之前,一名律師問過他「我對人工智慧發展的看法、對 AGI 的看法、AGI 的適當安全級別、政府是否應該參與 AGI、我和超級對齊團隊是否忠於公司,以及我在 OpenAI 董事會活動期間做了什麽」。值得註意的是,他是極少數在董事會解 Sam Altman 後沒有簽署呼籲他回歸的信函的 OpenAI 員工之一。其中許多員工後來離開了公司。

在聯名公開信中,OpenAI 現任和前任員工發稱,他們中的許多人擔心因提出擔憂而遭到「報復」。對於其有關保護吹哨人的呼籲,OpenAI 尚未回應置評請求。

在聯名信中的參照部份,摘錄了OpenAI此前的言論:「AGI 還可能帶來嚴重的誤用風險、重大事故和社會混亂……我們將像這些風險是存在一樣來營運。」

明顯,人心並不為此言論買單。

谷歌DeepMind與Anthropic也在風險之中?

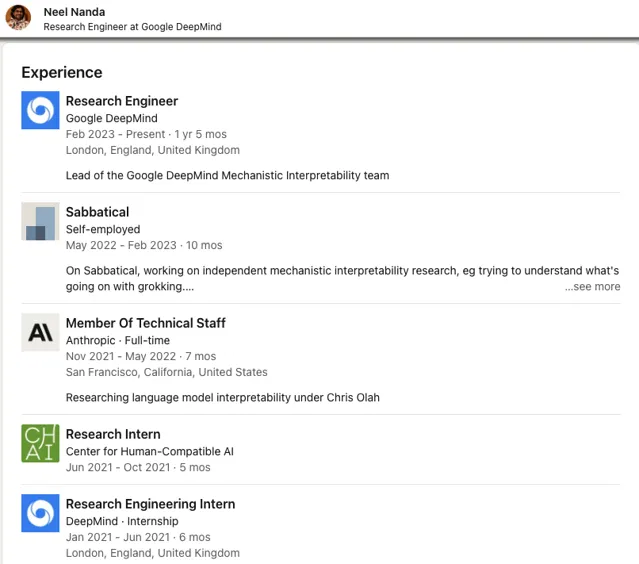

除 OpenAI 相關人員外,此次聯名簽署的還包括1名谷歌 DeepMind 現員工 Neel Nanda 和1名谷歌 DeepMind 前員工 Ramana Kumar。其中谷歌 DeepMind 的這名現員工 Neel Nanda,之前就職於 Anthropic。

Neel Nanda 畢業於劍橋大學,從其工作經歷來看,同樣具備AI安全背景。

「我認為我工作的主要目標是降低人工智慧帶來的生存風險,我認為自己是有效利他主義和理性社群的一分子。在此之前,我從事獨立的機械可解釋性研究,並在 Anthropic 擔任語言模型可解釋性研究員,在 Chris Olah 手下工作。」Neel Nanda 在其個人主頁寫道。

Neel Nanda 的工作與前上司一脈相承。Christopher Olah 是 Anthropic 的聯合創始人之一。正是當初因安全意見與前公司相左而離開 OpenAI,並加入 Anthropic 的元老成員之一。

Christopher Olah 在其 GitHub 的一篇部落格中寫道:「我致力於將人工神經網路逆向工程為人類可理解的演算法。Anthropic 是一家專註於大型模型安全性的人工智慧實驗室。此前,我曾在OpenAI領導可解釋性研究,在 Google Brain 工作。」

嚴謹起見,他還在後面附文:「我的部落格不應被視為反映我所屬的任何組織的觀點。」

而僅在 Anthropic 工作了7個月後,Neel Nanda 就從2022年5月到2023年2月,開始了為期10個月的學術休假。期間,他從事獨立的機械解釋性研究,並試圖了解 Grokking 是怎麽回事。隨後,他就進入谷歌擔任研究工程師,負責 Google DeepMind 機械可解釋性團隊,我們的工作是利用經過訓練的神經網路,嘗試對其學習到的演算法和結構進行逆向工程。此前,他曾在DeepMind實習了6個月。

2023年8月,在【機器學習模型是記憶還是概括?】一文中,Google的研究團隊揭示了一個名為 Grokking 的引人註目的現象,它為我們提供了關於模型如何突然從記憶轉變為泛化的深入見解。

「Grokking」描述了一個特定的學習過程:在經過長時間的訓練後,模型突然從簡單地記憶訓練數據轉變為能夠處理和理解未見過的數據。這不僅僅是模型重復其在訓練中所學的內容,而是它開始在更深層次上理解並套用其學到的知識。

Neel Nanda 從事的機械解釋性提供了一個方法,透過研究模型的訓練動態和反向工程其解決方案,來深入了解模型的工作原理。這種方法提供了一個新的視角,幫助更好地理解模型行為。

而精通於此的 Neel Nanda 在公開信中實名簽署,也代表了他從機械解釋性的嶄新視角看到了人工智慧的潛在風險,並強烈呼籲行業的重視及監管。

而因安全風險而離開谷歌的AI大佬,當屬「人工智慧教父」之一的 Geoffrey Hinton。2023年5月,

Geoffrey Hinton 在 AI 的研究前沿究竟看到了什麽?我們無法窺其全貌,但可從

Hinton 表示,他現在對自己一生從事的工作感到有些後悔。他的名字赫然出現在此次聯名公開信的贊同名單上。

AI大佬與多家業界機構呼聲愈發強烈

同樣具備「人工智慧教父」之稱的 Yoshua Bengio,也為本次聯名公開信實名背書。

Bengio 對AI的發展有著清醒而敏銳的洞察力。他不僅關註 AI 技術本身,也關註 AI 技術對社會、經濟、政治、文化等方面的影響和挑戰。他認為,AI技術有著巨大的潛能和價值,可以幫助人類解決許多重要和困難的問題,比如氣候變遷、醫療保健、教育等。但同時,他也警告說,AI 技術也有著巨大的風險和挑戰,可以威脅到人類的生存和發展。

Bengio曾指出了三種型別的AI威脅:

第一種是 存在性威脅(existential threat) ,即 AI 可能會超越人類,並且與人類產生沖突或者敵意;

第二種是 社會威脅(social threat) ,即 AI 可能會造成社會不公平、不平等、不透明等問題;

第三種是 道德威脅(ethical threat) ,即 AI 可能會違反人類的道德、價值和規範。Bengio認為,這些威脅都需要我們認真地思考和應對,以確保AI的發展能夠符合人類的利益和幸福。

Bengio 建議道:應建立一個多學科、多利益相關者、多層次的AI治理體系,以促進 AI 的可靠性、透明度、責任性和公平性。他還強調,應尊重和保護人類的自由、尊嚴和多樣性,以及地球的生態平衡。

位列贊同名單上的,還有 AI 安全專家、柏克萊頂級學者 Stuart Russell。他在此前接受采訪時曾指出,AI 或在各方面超人類,對人類生存構成威脅。

在這封公開信露出之前,Russell 已經簽署過兩封有關 AI 安全的公開信:

一封是由未來生命研究所(Future of Life Institute) 發起,並由圖靈獎得主Yoshua Bengio、特斯拉創始人Elon Musk等千余名人士的姓名標示支持,以「減少強大技術帶來的全球災難性和生存風險」為由,呼籲暫停開發比GPT-4 更強大的人工智慧系統至少6個月。

一封由總部位於舊金山的非營利組織 AI 資訊安全中心(Center for AI Safety,簡稱 CAIS)釋出,僅用22個英文詞聲明「減輕 AI 帶來的滅絕風險應該與流行病和核戰爭等其他社會規模的風險一起成為全球優先事項。」Stuart Russell正是這兩份公開信中名列前位的簽署人之一。

作為這兩封公開信名列前位的簽署人之一,Russell 表示:第一封公開信是要求給我們時間來制定安全標準,然後將這些標準納入法規,以便對系統提供保護;第二封是觀察到人工智慧在未來可能會在各個方面超越人類的智力和能力,對人類生存構成風險。

Stuart Russell 在著作【人工智慧:現代方法】中表示,「在自然界已知的事物和現象中,人和人腦是最復雜的系統,人類智慧是最復雜的現象。然而,沒有理由相信,人類是生物前進演化的最後階段,人類智慧是最高水平的智慧,有機體是智慧的唯一載體。以電腦為載體的人工智慧,揭開了機器智慧大幕的一角,為科學研究創造無窮無盡的新物件。」

不可否認的是,風險與創新一並存在。

多個相關機構及政府也都闡釋過風險及憂慮。本次公開信,也借此機會,再次強調了業界愈發強烈的安全呼聲。在公開信的末尾,列出了前沿公司及國際組織曾發表過的觀點。

Anthropic:「如果我們建立一個比人類專家更有能力的人工智慧系統,但它追求的目標與我們的最佳利益相沖突,後果可能是可怕的……人工智慧的快速發展將非常具有顛覆性,改變就業、宏觀經濟和權力結構……(我們已經遇到了)毒性、偏見、不可靠、不誠實」。

Google DeepMind:「未來的人工智慧系統可能會進行攻擊性網路行動,透過對話欺騙人類,操縱人類采取有害行動,開發武器(例如生物武器、化學武器)……由於協調失敗,這些人工智慧模型可能會在沒有人意圖的情況下采取有害行動。」

美國政府:「不負責任的使用可能會加劇社會危害,如欺詐、歧視、偏見和虛假資訊;取代和剝奪工人的權利;抑制競爭;並對國家安全構成風險。」

英國政府:「(人工智慧系統) 還可能進一步將不負責任的權力集中到少數人手中,或被惡意用於破壞社會信任、侵蝕公共安全或威脅國際安全……(人工智慧可能被濫用)來制造虛假資訊、進行復雜的網路攻擊或幫助開發化學武器。」

布萊切利宣言(代表 29 個國家):「我們尤其擔心網路安全和生物技術等領域的此類風險……可能會造成嚴重甚至災難性的危害」 。

關於人工智慧危害和政策的聲明 (FAccT)(超過 250 個簽署人):「從拒絕提供拯救生命的醫療保健的不準確或有偏見的演算法的危險,到加劇操縱和錯誤資訊的語言模型,……」

編碼正義與未來生命研究所:「我們發現自己正面臨著來自人工智慧的切實而廣泛的挑戰,如演算法偏見、虛假資訊、民主侵蝕和勞動力流失。與此同時,我們正面臨著日益強大的系統帶來的更大規模風險」 。

人工智慧風險聲明 (CAIS)(超過 1000 個簽署人):「減輕人工智慧導致的滅絕風險應該成為全球優先事項,同時還要應對流行病和核戰爭等其他社會規模的風險。」

如此關註之下,不僅前沿AI公司需要做出回應,人工智慧行業更需有所行動。

參考連結:

https://righttowarn.ai/#fn-3

https://www.nytimes.com/2024/06/04/technology/openai-culture-whistleblowers.html?u2g=i&unlocked_article_code=1.xE0.qXLu.0XwdynmvKcft&smid=url-share

https://www.transformernews.ai/p/openai-employee-says-he-was-fired

開發者正在迎接新一輪的技術浪潮變革。由 CSDN 和高端 IT 咨詢和教育平台 Boolan 聯合主辦的 2024 年度「全球軟體研發技術大會」秉承幹貨實料(案例)的內容原則,將於 7 月 4 日-5 日在北京正式舉辦。大會共設定了 12 個大會主題:大模型智慧套用開發、軟體開發智慧化、AI 與 ML 智慧運維、雲原生架構……詳情👉: http://sdcon.com.cn/