【导读】 在【自然】杂志发表的论文「Language is primarily a tool for communication rather than thought」中,科学家们提出了一个颠覆性的观点:语言并非思维的必需品,而是一种沟通工具。这一发现对大语言模型(LLM)的逻辑推理能力提出了挑战,引发了对通用人工智能(AGI)实现途径的重新思考。本文作者深入探讨了在 LLM 推理能力受限的情况下,如何利用其优势,同时避免其缺陷,提出了一系列策略,并展望了 AI 技术的未来发展方向。文章还讨论了多模态训练、任务目标训练等可能的解决方案,并预测了 AI 产业的发展前景,为读者提供了一个关于 AI 发展现状和未来可能性的全面视角。

作者 | 卢威

责编 | 唐小引

出品丨AI 科技大本营(ID:rgznai100)

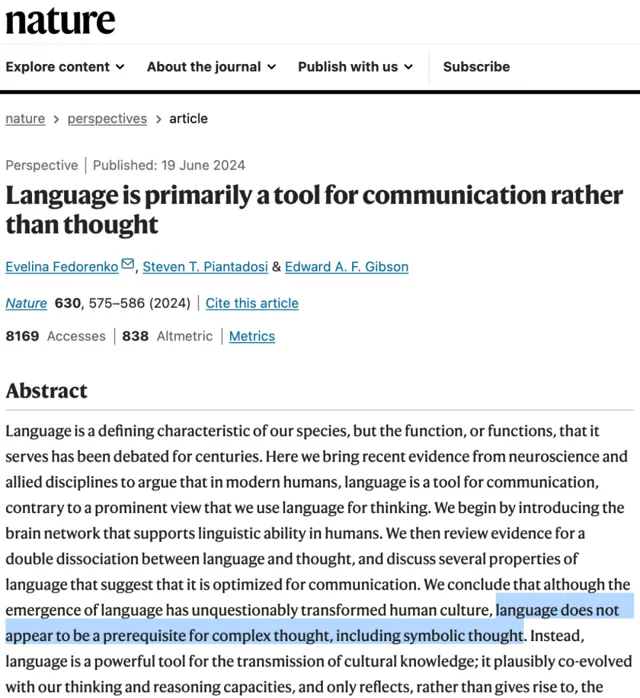

近日,【自然】杂志刊发了麻省理工学院(MIT)等机构撰写的论文「Language is primarily a tool for communication rather than thought」(【语言主要是沟通而非思维工具】)。揭示了人脑研究中的发现,包括:

语言对于任何可经测试的思维形式都不是必需的——不必要;

完整的语言系统似乎并不意味着完整的推理能力——不充分。

以预测下一个词元(Token)为主要模式的大语言模型(LLM)的逻辑推理等能力有缺陷,是否能据此实现通用人工智能(AGI)本就备受质疑,这下它头顶上又飘来一朵浓重的乌云。

预测下一个词元的自回归模型本来就是在理论证明暂缺的情况下经验尝试先行的产物。要证明或者证伪,目前办法也只有继续训练更大规模的模型看效果。OpenAI 已经公布一年半后才会有 GPT-5,本文旨在讨论这期间 LLM 技术的应用问题和对未来的预判。

在 LLM 暂时并且可能长期不能解决推理问题的情况下,我们提出以下策略。因为深度神经网络与传统软件一大不同是其功能和形成功能的构件难以进行独立和清晰地划分,所以以下各点策略有某种程度的重叠和关联,关键是把握要旨。

一、尽量利用 LLM 知识和常识提取的能力,达到启发性的目的。

这里不包括最新的经常变化的知识,比如新闻。如果对知识的正确性要求很高,用作判断的依据或其他前提条件,那么必须有交叉验证机制避免幻觉问题。

二、利用 LLM 的某种文本修改模式。

典型的例子是翻译。LLM 超越了传统软件中人类总结归纳的修改和转换规则,掌握了很多人类难以理清的模式。

三、避免不常出现的新情况(条件和上下文)下的逻辑推理。

LLM 目前展现出的一定的逻辑推理能力有可能是用一、二两种方式模拟出来的,就是说它并不真的需要理解问题和推理方式,而是以较高的成功率提取到了推理结果的一种语言表达。所以如果你的问题非常特殊,那么提取成功率就会大大降低。一些研究就是通过设计模型训练不可能遇到的问题形式来求证推理能力问题。

带着这几条策略,我们检视一下今年流行的 Agent 技术。以吴恩达归纳的 4 种主要的 Agent 设计模式为例。

1)Reflection:让 Agent 审视和修正自己生成的输出

与思维链 CoT 一样,可以视作修改问题的上下文以充分发挥策略一、二,改善策略三的问题,因为只靠随机波动( 温度参数 )无法改善了。

2)Tool Use:LLM 生成代码、调用 API 等进行实际操作

除了对外部施加结果,很多时候也是为了获取模型之外的有效信息来帮助新的预测,就是策略一中讨论的正确的知识问题。

3)Planning:让 Agent 分解复杂任务并按计划执行

目前有效的做法是输入各领域任务分解的标准作业流程( SOP ),即策略三的用相似上下文检索出正确的任务分解结果的文本表达。只靠模型的推理能力的话效果都很有限。

4)Multiagent Collaboration:多个 Agent 扮演不同角色合作完成任务

一种情况是不同的 Agent 使用不同的模型,从不同模型的训练数据分布和训练方法中获得多样化的预测结果。

另一种情况是使用同一个模型,只是 Prompt 中改变角色提示,可能与 1)的讨论本质上是一样的。

那么 AI 研发者们会怎么解决推理问题呢?

首先从去年底开始,大模型的训练热点转向多模态,可能已经暗示 AI 研发已经意识到语言模型的推理问题。光靠语言不行,那就把图像信息也加进来。计算机代码也可以说是人脑研究中没有探讨的问题,已经取得了很好的实证效果。

现在的 LLM 在下一个 Token 预测的预训练基础上,还进行了 SFT、RLHF、DPO 等针对更多任务目标的训练,也许也能找到解决推理问题的方法。

另外就是下一个阶段可能会发生通用人工智能( AGI )、超级人工智能( ASI )等概念的重新定义问题。OpenAI 首席技术官米拉·穆拉蒂( Mira Murati )说「下代 ChatGPT 将达博士级」, 实际上现在的模型在一些能力上已经超越博士水平,而下一代 ChatGPT 身上也很可能能找到一些能力还不如幼儿园水平。 没有界定条件和范围的问题讨论只是某种市场话术。

如果一年半后 LLM 的推理能力没有质的提高,AI 会又进入冬季吗?

我们认为,这一波的生成式 AI 即使没有逻辑推理能力,也在构建一个互联网( Internet )级别的事物。在 Internet 中互相连接的人创造了海量知识和功能,在大模型中,人对应的是神经元计算,现在大部分依靠的是英伟达的 GPU,所以英伟达的市值可以与 Internet 中的用户价值相比较。当然,随着其他芯片的市场占有率上升,价值会分散在更多厂家身上。而且数据和能源这两个同样重要的要素还没有被股市计算进来。对比 Internet 有巨大的成长过程, 大模型可能也会形成巨大的产业,避免 AI 研究再次进入冬季。

相关资料:

https://gwern.net/doc/psychology/linguistics/2024-fedorenko.pdf

https://news.ycombinator.com/item?id=40756176

https://www.nature.com/articles/s41586-024-07522-w

推荐阅读:

由 CSDN 和 Boolan 联合主办的「2024 全球软件研发技术大会(SDCon)」将于 7 月 4 - 5 日在北京威斯汀酒店举行。

由世界著名软件架构大师、云原生和微服务领域技术先驱 Chris Richardson 和 MIT 计算机与 AI 实验室(CSAIL)副主任,ACM Fellow Daniel Jackson 领衔,BAT、微软、字节跳动、小米等技术专家将齐聚一堂,共同探讨软件开发的最前沿趋势与技术实践。

大会官网: http://sdcon.com.cn/ (可点击 阅读原文 直达)