最近經常看到有小夥伴在問,哪個開源的TTS好。

阿裏的CosyVoice終於迎來重大升級,化身CosyVoice2。

它最大的亮點是流式合成輸出。

這個開源計畫一定會讓非常多的軟體、硬體互動體驗提升一個檔次。

講下原因,互動性的AI產品,比如AI陪伴等,產品體驗要好, 必須把AI回答的延遲降到最低。

想要延遲低,就必須想辦法在各個環節降時間,ASR、LLM部份方案已經很多了,但是TTS方案確實是比較少,大部份方案開發周期比較長,問題在於流式這部份做不好。

像是豆包等產品的API已經有流式了,但是價格上確實是不低,尤其是加上聲音複制,成本太高,使用者也難以接受。

CosyVoice 2在各方面做得都不錯,粉絲朋友們可以嘗試。

掃碼加入AI交流群

獲得更多技術支持和交流

(請註明自己的職業)

計畫簡介

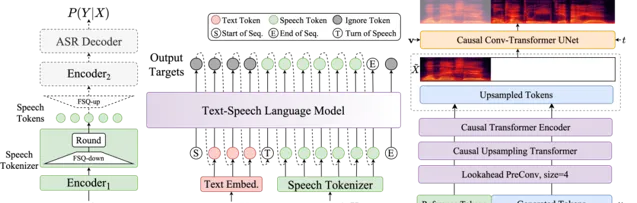

CosyVoice 2是阿裏巴巴開發的流式語音合成模型,它透過整合大型語言模型,實作了高品質的語音合成。該模型支持流式和非流式合成,采用有限純量量化技術提高語音資訊捕捉,簡化模型架構,並開發了塊感知因果流匹配模型以適應不同合成場景。CosyVoice 2在保持人類同等自然度的同時,幾乎無失真地實作了流式模式下的合成品質。

DEMO

各方面能力都很強,咱們一個一個來看。

1、普通的音訊複制。

輸入音訊

輸出音訊

2、跨語言聲音複制

輸入音訊

輸出音訊

3、有情感的音訊合成

快樂的

生氣的

4、順口溜

5、角色扮演

6、方言

粵語

上海話

2.0版本亮點

語言支持

支持語言:中文、英文、日語、韓語、中國方言(粵語、四川話、上海話、天津話、武漢話等)

跨語言和混合語言:支持跨語言和程式碼切換場景的零樣本語音複制。

超低延遲

雙向流支持:CosyVoice 2.0 整合了離線和流建模技術。

快速首包合成:實作低至 150 毫秒的延遲,同時保持高品質的音訊輸出。

高精度

改進發音:與 CosyVoice 1.0 相比,發音錯誤減少了 30% 到 50%。

基準測試成果:在Seed-TTS評估集的硬測試集上取得最低的字元錯誤率。

穩定性強

音色一致性:確保零樣本和跨語言語音合成的可靠語音一致性。

跨語言合成:與 1.0 版本相比有顯著的改進。

自然體驗

增強韻律和音質:改進了合成音訊的對齊,將 MOS 評估分數從 5.4 提高到 5.53。

情感和方言靈活性:現在支持更細致的情感控制和口音調整。

計畫連結

https://github.com/FunAudioLLM/CosyVoice

關註「 開源AI計畫落地 」公眾號

與AI時代更靠近一點

關註「 AGI光年 」公眾號

獲取每日最新資訊

關註「 向量光年 」公眾號

加速全行業向AI轉變