講AI,靠得住, 藍色字型 求關註

哈嘍,大家好!

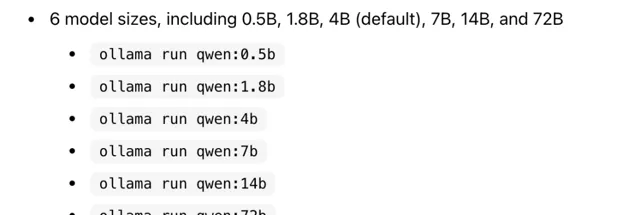

新年期間,通義千問釋出了 Qwen1.5 大模型,包括0.5B、1.8B、4B、7B、14B和72B各個尺寸的大模型。

72B有個線上體驗地址,我試了下,明顯比上一個版本好很多。

這次釋出的 Qwen1.5 最大的好處是可以在 ollama 平台使用,我之前分享過ollama,支持很多大模型,一條命令就可以執行,無需編程,告別 Python 環境的搭建

執行後,模型下載速度非常快,每秒100多M,分分鐘就下載好一個大模型。

ollama 預設執行在 CPU 上,在普通的電腦上,跑 7B 及以下的大模型,推理速度都會非常快。

如果有 GPU,ollama 會把模型放到視訊記憶體,加速推理。

我測試在本地跑 72B 大模型,模型大小 41GB,如果有 GPU ,至少 32G 視訊記憶體可以跑起來。 如果沒有GPU,可以用伺服器跑,CPU要強一些,記憶體至少 64GB。

畢竟 72B 模型太大了,速度不會是特別流暢,基本是一個個字蹦的級別。 但,一個沒有 GPU 的伺服器跑 72B 的大模型, 已經很好了。

ollama 之所以快,是因為它執行的模型是經過 GGUF (GPT-Generated Unified Format)方式量化的。這種方式允許使用者使用CPU來執行LLM,也可以將其某些層載入到GPU以提高速度。當然速度提升是以損失精度為代價的。

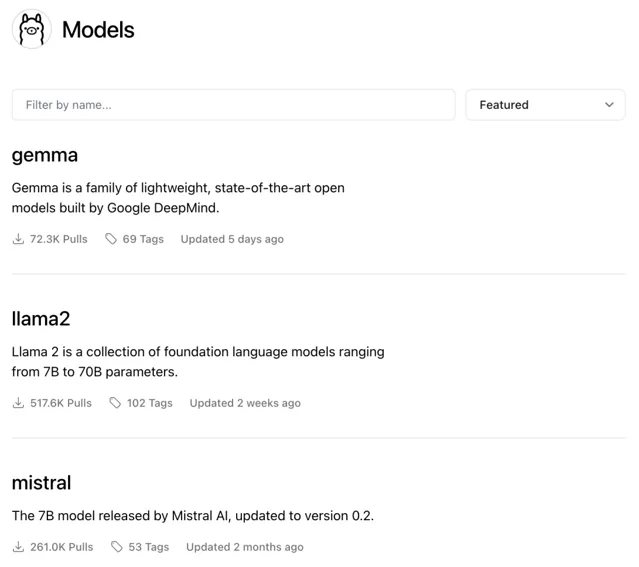

ollama 現在支持非常多的模型,包括最近爆火的 Gemma

渡碼 公眾號持續分享AI方面的套用、技術、資訊,歡迎關註。