物聯網中的即時數據處理與流計算

物聯網(IoT,Internet of Things)時代的到來帶來了大量裝置的互聯,這些裝置的集體功能不僅在於數據采集,更重要的是數據的實分時析和處理。在這篇文章中,我將深入講解物聯網環境下如何處理即時數據流和實作流計算,並探索流計算的原理,並給出具體的架構設計和程式碼範例。

即時數據流是指持續不斷、高速生成的數據,這在物聯網裝置比如傳感器、智慧裝置中十分常見。為了高效處理這些數據,就需要流計算(Stream Processing)技術,它允許我們在數據生產出來的同時,就進行即時處理分析。這種技術與傳統的批次處理相對,批次處理是等待一定量的數據積累後再一次性處理。

物聯網數據流的挑戰

在具體進入流計算的講解之前,我們需要先理解物聯網環境下的即時數據流面臨的主要挑戰:

1. 數據量巨大 :隨著物聯網裝置數量的不斷增長,數據流的大小也在增長。

2. 數據速率快 :物聯網裝置通常需要即時或近即時地生成數據。

3. 數據格式多樣 :來自不同裝置的數據格式可能不同,需要進行統一或轉換。

4. 時序性 :物聯網數據通常帶有時間戳,需要保持其時序性,以正確反映事件的發生順序。

5. 數據品質 :物聯網裝置可能會生成不完整或錯誤的數據,需要進行清洗和糾錯。

流計算的基本原理

流計算是指在數據生成的同時對其進行連續的查詢和計算,而不需要儲存大量的臨時數據。流計算的基本元件包括:

• 源(Sources) :產生數據流的起點,例如物聯網裝置。

• 處理器(Processors) :對數據流進行處理的計算單元。

• 匯(Sinks) :處理完成的數據流的終點,通常是資料庫、監控儀表盤或其他儲存系統。

在流計算模型中,數據以流的形式在這三個元件之間流動,沒有任何等待或者暫存的過程。這就意味著系統需要快速處理到來的每一條數據,並做出即時響應。

流計算架構和技術

為了處理物聯網中的即時數據流,我們通常采用分布式的流處理架構,這種架構可以橫向擴充套件以處理數據流量的增長。下面以Apache Kafka和Apache Flink為例,講解一種典型的流計算架構。

Apache Kafka是一個分布式流平台,能夠高效地處理數據流。而Apache Flink是一個用於大規模數據處理的流處理框架,特別適合用於即時數據的分析、處理。

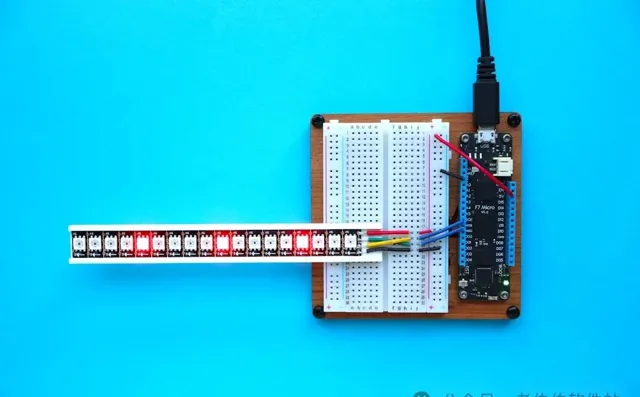

以下是一個簡單的物聯網流計算架構圖:

[物聯網裝置] --> |數據流| --> [Kafka] --> |訊息佇列| --> [Flink] --> |即時處理| --> [資料庫/儀表盤]

在該架構中,物聯網裝置向訊息佇列Kafka發送數據流,Flink則從Kafka訂閱數據流並進行即時處理,處理後的結果可以儲存到資料庫或直接展示在監控儀表盤上。

編程範例:流計算與數據視窗

在流計算中,數據視窗是一種組織和處理時間序列數據的重要方式。它根據時間或數據的數量來界定數據的一段區間,並對區間內的數據進行計算。我們來看一個使用Java程式碼的例子:

DataStream<Tuple2<String, Integer>> dataStream = ... //從Kafka接收數據流

DataStream<Tuple2<String, Integer>> windowCounts = dataStream

.keyBy(0) // 對流數據按照key(此處為Tuple的第一個元素)分組

.window(TumblingEventTimeWindows.of(Time.minutes(1))) // 定義每分鐘捲動一次的視窗

.sum(1); // 對視窗內的數據進行求和

在這個簡單的例子中,我們定義了一個每分鐘捲動一次的時間視窗,並且對每個視窗內的整數值求和。這種模式非常適合即時統計物聯網裝置輸出的各種指標。

效能考慮和最佳化

在實施物聯網即時數據流處理和流計算時,效能最佳化非常關鍵。最佳化的方法包括:

• 使用更有效的數據序列化/反序列化機制減少延遲。

• 最佳化數據流拓撲結構,減少不必要的數據傳輸和轉換。

• 實施背壓機制(Backpressure)來平衡生產者和消費者之間的速度差異,防止系統過載。

結論與展望

物聯網的即時數據流處理和流計算是一個復雜但十分重要的領域,它使我們能夠更快地從大規模裝置中提取有價值的資訊。隨著技術的發展,流計算框架將會更加高效、易用,使得即時數據處理成為常態。

如果喜歡我的內容,不妨點贊關註,我們下次再見!

大家註意:因為微信最近又改了推播機制,經常有小夥伴說錯過了之前被刪的文章,或者一些限時福利,錯過了就是錯過了。所以建議大家加個 星標 ,就能第一時間收到推播。

點個喜歡支持我吧,點個 在看 就更好了