整理 | 屠敏

出品 | CSDN(ID:CSDNnews)

近段時間的 OpenAI 似乎遭遇了「水逆」。

一方面,隨著 OpenAI 聯合創始人兼首席科學家 和超級對齊負責人 Jan Leike 相繼從 OpenAI 離職之後,有訊息稱,OpenAI 核心安全團隊「超級對齊」已經解散。

另一方面,一波未平一波又起,這兩天,一份在離職後不許詆毀 OpenAI 的「離職封口協定」又將 OpenAI 推上了風口浪尖,更有外媒 Vox 直接指出,「OpenAI 最新釋出的 GPT-4o 可以讓 ChatGPT 像人類一樣說話,但是 OpenAI 的員工卻不能」。

OpenAI 超對齊團隊分崩離析

事實上,上周 OpenAI 聯合創始人兼首席科學家 的離職,雖讓人感到遺憾,但也是意料之中的事情。

要知道去年,Ilya Sutskever 參與了導致「 」的董事會叛亂。

歷經 12 天的「宮鬥」,在 之際,Ilya Sutskever 公開對自己的行為表示遺憾,並支持 Altman 的回歸。此後,他便鮮少出現在公眾視野。

從其社交媒體帳號更新的頻次來看,上一次的轉發還是在 2023 年 12 月 15 日,而最新的一次便是直接跳到了今年的 5 月 15 日官宣離職。

Ilya Sutskever 的離開,雖引發了外界對「你究竟看到了什麽的」猜疑,但是他給了自己和 OpenAI 一份體面,只是官方地說,「我相信 OpenAI 將在 Sam Altman、Greg Brockman、Mira Murati 現在再加上 Jakub Pachocki 出色的研究領導下,打造既安全又有益的 AGI……」

對此,Sam Altman 也非常罕見地釋出了一篇正式且深情的長文透露了自己的不舍,「沒有他,OpenAl 就不會有今天。雖然他有一些對個人有意義的事情要去做,但我永遠感激他在這裏所做的一切,並致力於完成我們共同開創的使命。我很高興能在這麽長的時間裏接近這樣一個真正非凡的天才,一個如此專註於為人類創造最好未來的人。」

然而,與 Ilya Sutskever 的離職形成鮮明對比的是,OpenAI 超級對齊負責人 Jan Leike 的離開。起初,正如 ,Jan Leike 的辭職資訊很簡單,只有短短的兩個單詞,「I resigned」(我辭職了)。

沒有原因、沒有未來去向、更沒有 OpenAI 高層如 Sam Altman 的祝福。

一切不知是主動還是被動的情況下,外界報道也充滿了猜測,也或是被問的多了, Jan Leike 在剛剛過去的周末裏,忍不住地連發了 13 條推文,分享了自己離開的想法,更是怒斥 OpenAI 在追求華而不實的產品,質疑 OpenAI 不再關心安全。

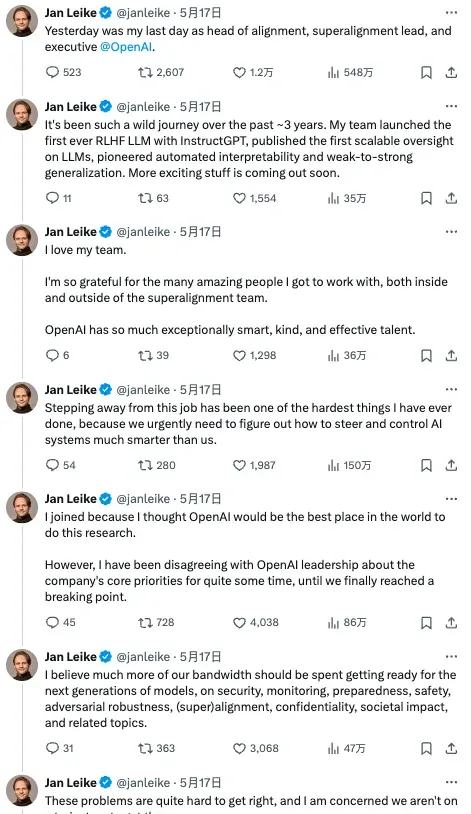

以下是他在 X 平台上分享的完整內容:

昨天是我在 OpenAI 擔任對齊團隊主管、超級對齊負責人和高管的最後一天。

過去 3 年,這真是一段瘋狂的旅程。我的團隊推出了有史以來第一個使用 RLHF 訓練的大模型 InstructGPT,釋出了第一個可延伸的 LLM 監督,開創了自動可解釋性和從弱到強的泛化。更多激動人心的成果即將推出。

我愛我的團隊。我非常感謝能與超級對齊團隊內部和外部的許多優秀人共事。OpenAI 擁有眾多非常聰明、善良、高效的人才。

從這份工作離開,是我做過的最困難的事情之一,因為我們迫切需要弄清楚如何引導和控制比我們聰明得多的人工智慧系統。

我最初加入 OpenAI 是因為我認為 OpenAI 是世界上進行此類研究的最佳場所。 然而,我與 OpenAI 領導層在公司的核心優先事項上存在分歧已有一段時間,直到我們最終達到了臨界點。

我相信我們應該把更多的精力花在為下一代模型做準備上,包括安全、監控、準備、安全、對抗穩健性、(超)一致性、機密性、社會影響和相關主題。

這些問題很難解決,我擔心我們還沒有走上解決的軌域。

過去幾個月,我的團隊一直在逆風前行。有時,我們為計算而苦苦掙紮,完成這項至關重要的研究變得越來越困難。

制造比人類更聰明的機器本質上是一項危險的事業。OpenAI 代表全人類肩負著巨大的責任。

但在過去幾年中,安全文化和流程已不再受到重視,而光鮮的產品備受青睞。

我們早就應該認真考慮 AGI 的影響了。我們必須優先考慮並盡可能做好準備。只有這樣,我們才能確保 AGI 造福全人類。

OpenAI 必須成為一家安全第一的 AGI 公司。

我想對所有 OpenAI 員工說:

學會感受 AGI。

采取與你正在構建的事物相適應的莊重態度。

我相信你可以「實作」所需的文化變革。

我指望你了。

全世界都指望著你。

OpenAI-heart

對此,看熱鬧不嫌事大的馬斯克評論稱,這意味著安全並不是 OpenAI 的首要任務。

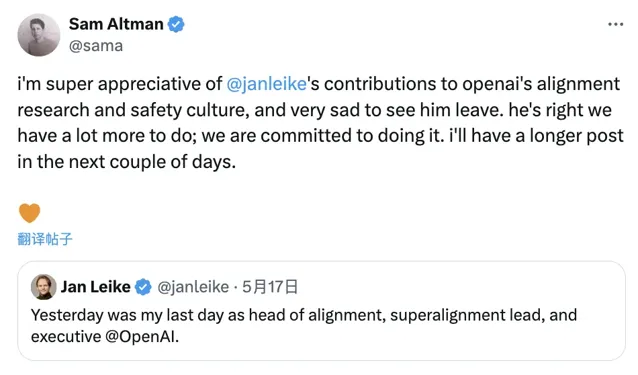

隨著這些內容的公開,次日 OpenAI CEO Sam Altman 才姍姍來遲地現身轉發並回應稱,「我非常感激 Jan Leike 對 OpenAI 的對齊研究和安全文化做出了貢獻,看到他離開,我感到非常難過。他說得對,我們還有很多事情要做;我們致 力於這樣做。在接下來的幾天裏,我會有一個更長的貼文。」

據外媒【連線】最新報道,OpenAI 超級對齊團隊兩大負責人離開之後,這個團隊已經解散,余下成員要麽辭職,要麽將被納入 OpenAI 的其他研究工作中。

如此迅速的動作,毫無疑問,OpenAI 內部的一線技術人員和管理人員已經分為兩個陣營,而對安全等問題著重看重的一方正在相繼出走。

針對這一點,也有人好奇,觀點的不一致,最終導致他們究竟是被迫還是主動離開。看 Jan Leike 的話語,也存在諸多的無奈才寄希望於留在 OpenAI 的其他人。同時, 迄今為止,似乎並沒有一個曾經在 OpenAI 工作的人公開談論過自己究竟為何而離職?

「不貶低」協定曝光

據 Vox 報道,事實證明,之所以沒有太多公開訊息,是因為有一個非常明確的原因,即 OpenAI 內部有一個極其嚴格的離職協定, 要求從 OpenAI 離職的員工必須遵守一項「不貶低」協定以及保密條款,即禁止這些離職的員工在余生中批評他們的前雇主,同時禁止承認保密協定的存在。

如果離職員工拒絕簽署這份檔,或者違反了這份檔,他們就會失去在公司工作期間獲得的所有既定股權,這可能價值數百萬美元。

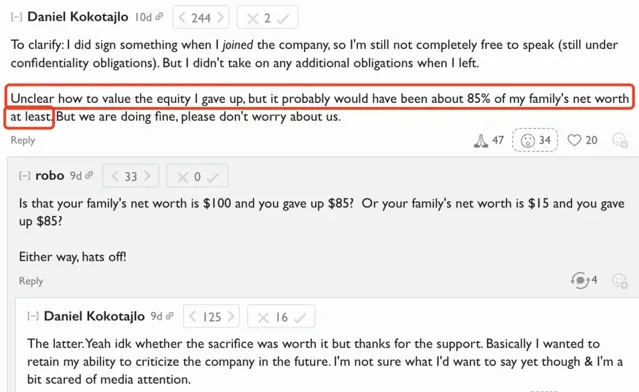

此前,一位名叫 Daniel Kokotajlo 的前 OpenAI 員工發帖稱,他「因為對 OpenAI 在 AGI 計畫會負責任的行事而失去信心」而從 OpenAI 辭職,他已公開證實,為了不簽署該檔而辭職,他可能丟了一筆巨款。

事實上,在競爭激烈的矽谷,保密協定並不罕見,但將員工已歸屬的股權置於拒絕或違反保密協定的風險中卻是罕見的。對於像 OpenAI 這樣的初創公司的員工來說,股權是一種重要的報酬形式,這種薪酬形式可能會讓他們的薪資相形見絀。

研究熱門科技公司薪酬的咨詢公司 Levels.fyi 的創始人 Zuhayeer Musa 曾分享過 OpenAI 員工薪酬構建,多數員工的基本薪資約為 30 萬美元,每年還會獲得約 50 萬美元的 PPU(利潤參與單位)補助,這是一種股權補償形式。

所謂 PPU,它的核心價值,就是能夠分享 OpenAI 所產生的利潤。

Zuhayeer Musa 表示,「 簽約獎金非常罕見、沒有目標績效獎金、薪酬幾乎沒有談判余地」。同時,他 指出,在 OpenAI,員工的薪酬會根據經驗的不同而有所區別,薪資或 PPU 補助會上下浮動幾千美元,通常以 2.5 萬美元為單位遞增。不過,大多數職位的薪酬都接近 30 萬美元的薪資和 50 萬美元的補助金。在 PPU 補助金的四年歸屬期內,OpenAI 的大多數員工預計將獲得至少 200 萬美元的股權薪酬。

如果違反所謂的「不詆毀」協定,股權遭到回收,正如前 OpenAI 員工 Daniel Kokotajlo 說的,「 不清楚如何評估我放棄的股權,但它可能至少占我家庭凈資產的 85% 左右」 ,成本巨大。

OpenAI CEO 緊急回應

毋庸置疑,這則 「不詆毀」協定從根本上封住了離職員工的嘴,也讓不少人對 OpenAI 的做法感到詫異與失望。

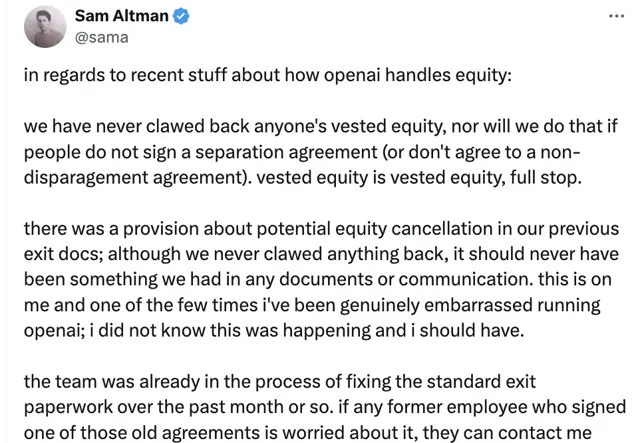

此訊息一經曝出, OpenAI CEO Sam Altman 也坐不住了,立即回應道,這份協定是存在,但是並沒有實行過。如今已經責令內部整改。

關於最近有關 Openai 如何處理股權的最新內容:

我們從未收回過任何人的既得股權,如果有人不簽署離職協定(或不同意非貶損協定),我們也不會這樣做。既得股權就是既得股權。

在我們之前的離職檔中,有一條關於潛在股權登出的規定;雖然我們從未收回過任何東西,但我們不應該在任何檔或溝通中提及這一點。這是我的責任,也是我在營運 OpenAI 的過程中為數不多的真正感到尷尬的一次;我不知道會發生這種情況,但我應該知道。

在過去的一個多月裏,我們的團隊已經在修正標準離職檔。如果任何簽署過這些舊協定的前雇員對此感到擔心,他們可以聯系我,我們也會解決這個問題。對此我深感抱歉。

顯然,對於 Sam Altman 的回應,使用者們並不買賬,更有人直接質疑道,「如果他們說了一些你不喜歡的話,你怎麽能「意外地」加入一條可以取消股權的條款呢?一個「錯誤」給你帶來如此巨大的利益,真是奇怪」,還有網友表示,「如果外媒沒有披露出來,這則協定是否還會存在那裏?」

OpenAI 不 Open 後,安全存疑?

如果說 OpenAI 決定不開源大模型是不 Open 的行為存在爭議,那麽如今「離職封口協定」才是真正的「封閉」,外加安全研究人員的相繼離職,加劇了外界對於 OpenAI 在安全、可靠性的擔憂。

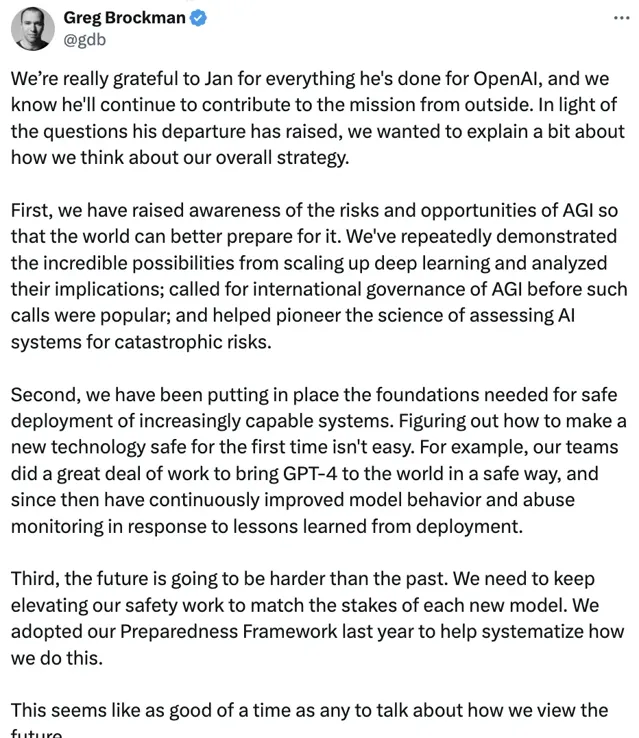

面對外界擔心「不可控、或對人類造成重大傷害」的 AI,OpenAI 總裁 Greg Brockman 聯合 Sam Altman 也在最新的一天發長文稱,他們意識到 AGI 的風險和潛力,稱公司已呼籲制定國際 AGI 標準並幫助「拓荒者」檢查人工智慧系統是否存在災難性威脅的做法。

我們非常感謝 Jan 為 OpenAI 所做的一切,我們知道他將繼續從外部為這項使命做出貢獻。 鑒於他的離職引發了諸多問題,我們想解釋一下我們對整體戰略的看法。

首先,我們提高了人們對 AGI 風險和機遇的認識,以便世界能夠更好地為此做好準備。 我們多次展示了擴充套件深度學習規模的可能性並分析了其影響;在此類呼籲之前,我們就呼籲了對 AGI 進行國際治理;並幫助開創了評估人工智慧系統災難風險的科學。

其次,我們一直在為安全部署能力越來越強的系統奠定必要的基礎。 弄清楚如何讓一項新技術從一開始就變得安全並不容易。例如,我們的團隊做了大量工作,以安全的方式將 GPT-4 帶給世界,此後,我們根據部署過程中吸取的教訓,不斷改進模型行為和濫用監控。

第三,未來將比過去更加艱難。 我們需要不斷提升安全工作,以適應每種新模式的風險。去年,我們采用了「Preparedness Framework」,以幫助將我們的工作系統化。

現在似乎是談論我們如何看待未來的好時機。

隨著模型功能越來越強大,我們預計它們將開始與世界更加緊密地融合。使用者將越來越多地與由許多多模式模型和工具組成的系統進行互動,這些系統可以代表他們采取行動,而不是僅透過文本輸入和輸出與單個模型對話。

我們認為,這樣的系統將為人們帶來極大的益處和幫助,而且可以安全地交付這些系統,但這需要大量的基礎工作。這包括仔細考慮他們在訓練時所連線的內容、解決可延伸監督等難題以及其他新型安全工作。在我們朝著這個方向發展的過程中,我們還不確定何時會達到釋出的安全標準,如果這會推遲釋出時間表也沒關系。

我們知道我們無法想象所有可能的未來情景。因此,我們需要非常緊密的反饋迴圈、嚴格的測試、每一步的仔細考慮、世界一流的安全性以及安全性和能力的和諧。我們將繼續針對不同的時間範圍進行安全研究。我們還將繼續與政府和許多利益相關者就安全問題展開合作。

目前還沒有行之有效的策略指導如何走向 AGI。 我們認為經驗理解可以幫助指引前進的方向。我們相信,我們既能實作巨大的優勢,又能努力降低嚴重的風險;我們非常認真地對待我們在這裏的角色,並仔細權衡對我們行動的反饋。

— Sam 和 Greg

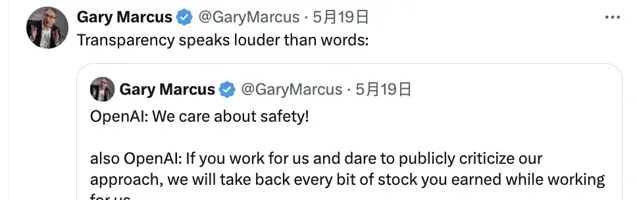

隨即,美國 AI 著名學者 Gary Marcus 一句話似乎瓦解了所有的回應,其表示——「透明度勝於雄辯」。

其實,在沒有足夠清晰的透明度、統一的技術安全措施、積極的反饋處理機制,以及明確的法律和倫理規範之前,大家對 AI 的安全必然會持非常謹慎的態度。這不僅對 OpenAI,而且對所有致力於 AI 發展的企業來說,都必將是一個巨大的挑戰。

來源:

https://www.vox.com/future-perfect/2024/5/17/24158478/openai-departures-sam-altman-employees-chatgpt-release

https://www.businessinsider.com/openai-unique-compensation-package-among-tech-companies-ppu-2023-6

https://x.com/gdb/status/1791869138132218351

推薦閱讀: