作者:西風

轉自:量子位 | 公眾號 QbitAI

國產大模型 首次在公開榜單上超過GPT-4o!

就在剛剛,「大模型六小強」之一的零一萬物正式對外釋出新旗艦模型—— Yi-Lightning (閃電) 。

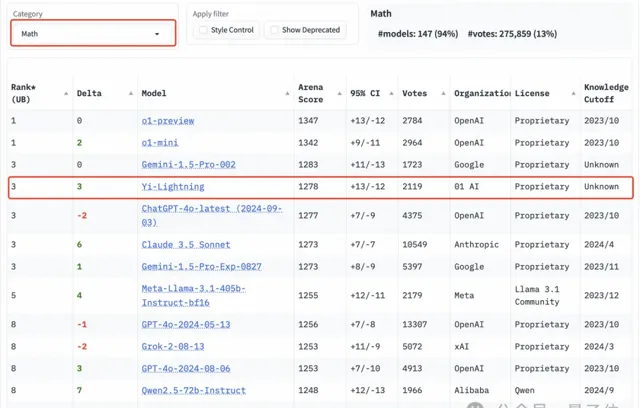

在大模型競技場 (Chatbot Arena) 上,Yi-Lightning效能直沖總榜單並列 第 6 ,數學分榜並列第3,程式碼等其它分榜也名列前茅。

總成績幾乎與馬斯克最新xAI大模型Grok-2-08-13持平,超越GPT-4o-2024-05-13、GPT-4o-mini-2024-07-18、Claude 3.5 Sonnet等頂流。

同時,國內清華系大模型公司智譜AI的 GLM-4-Plus 也殺進了總榜,位居 第9 位。

該榜單結果來自全球累積超千萬次的人類使用者盲測投票。

前段時間大模型競技場還剛剛更新了規則,新榜單對AI回答的長度和風格等特征做了降權處理,分數更能反映模型真正解決問題的能力。

這次Yi-Lightning殺出重圍,Lmsys團隊特意發貼文,稱這是競技場上的大新聞:

大模型競技場總榜第六、國產第一

細看大模型競技場分類榜上的「賽況」,Yi-Lightning各項能力都排在前頭。

在 中文 能力上,Yi-Lightning和GLM-4-Plus兩個國產大模型都名列前位。

Yi-Lightning躍居並列第二,和o1-mini相差無幾。

數學 能力,Yi-Lightning和Gemini-1.5-Pro-002並列第3,僅次於o1-preview、o1-mini。

程式碼 能力Yi-Lightning排名並列第4。

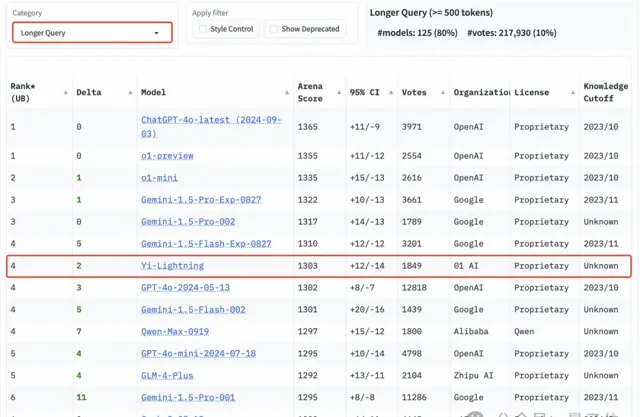

另外在 Hard Prompts 和 Longer Quer y 分榜,Yi-Lightning也都排在第4位元。

最後同樣值得關註的是,競技場新功能 風格控制過濾 ,確保分數反映模型真正解決問題的能力,而不是用漂亮的格式、增加回答長度。

在對長度和風格等特征做了降權處理後,所有模型分數均有下降,Yi-Lightning排名變化不大,整體還與GPT-4o、Grok-2同一梯隊。

釋出會上,零一萬物創始人兼CEO李開復博士展示了Yi-Lightning在不同場景上的能力。

Yi-Lightning主打一個「推理速度更快,生成品質更好」。

相比上半年Yi-Large,Yi-Lightning首包速度提升1倍,推理速度也提升了4成。

像是轉譯下面這種文學作品,Yi-Lightning不僅速度更快:

而且用詞更精準,更具文學色彩:

那麽Yi-Lightning是如何做到的?

好用還得極速

Yi-Lightning采用 MoE 混合專家模型架構。

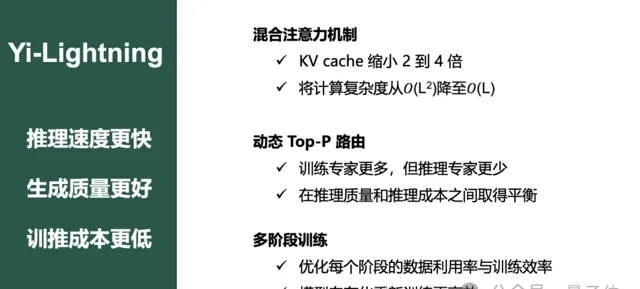

底層技術上,Yi-Lightning在以下方面進行了提升。

首先是最佳化 混合註意力機制 (Hybrid Attention) ,只在模型的部份層次中將傳統的全註意力 (Full Attention) 替換為滑動視窗註意力 (Sliding Window Attention) 。

由此以來,模型在保證處理長序列數據高效能表現的同時,還能大大降低推理成本。

Yi-Lightning還引入了跨層註意力 (Cross-Layer Attention, CLA) ,允許模型在不同的層次之間共享鍵 (Key) 和值 (Value) 頭,減少對儲存需求。

這使得Yi-Lightning能在不同層次之間更有效地共享資訊。

總的來說,KV cache縮小了2-4倍,同時將計算的復雜度從O(L²)降至O(L)。

其次,Yi-Lightning還采用了 動態Top-P路由機制 。

也就是說,Yi-Lightning可以根據任務的難度動態自動選擇最合適的專家網路組合——

訓練過程中會啟用所有專家網路,使模型能學習到所有專家知識;而推理階段,根據任務的難度,模型會選擇性啟用更匹配的專家網路。

另外,之前有一些傳言稱國內大模型「六小強」,有一些已經不做預訓練了,李開復博士這次在釋出會上直接「辟謠」:

零一萬物絕不放棄預訓練。

而且在模型預訓練階段,團隊還積累了豐富的 多階段訓練 方法 ,將整個訓練分為兩塊,一塊做好以後就把它固定起來,然後在這個固定的模型上再做後段訓練。

訓練前期,更註重數據多樣性,使得Yi-Lightning盡可能學習不同的知識;訓練後期更重內容更豐富、知識性更強的數據。

同時團隊還在不同階段采用不同的batch size和LR schedule保證訓練速度和穩定性。

李開復博士還表示,零一萬物開發模型講究「模基共建」,也就是 共建模型和基礎架構 。

模型的訓練、服務、推理設計,與底層的AIInfra架構和模型結構必須高度適配。

這樣做的目的,不僅是讓模型更好,而且讓它在推理的時候能夠更便宜。

再加上以上種種擡升「價效比」的技術加持,所以Yi-Lightning這次也是打到了白菜價——

0.99元每1M token

在中文等方面,Yi-Lightning比肩OpenAI的o1-mini,o1-mini的定價是每百萬輸入3美元,每百萬輸出12美元。

Yi-Lightning每百萬token只需0.99RMB也是打到了骨折。

但李開復博士表示,即便這樣也:不虧錢。

除了釋出新模型,零一萬物這次還先發了 AI2.0數位人 方案。

目前該數位人已接入Yi-Lightning,即時互動效果相比以往更強更自然了,belike:

最後談起和國外頭部大模型的差距,李開復博士表示這次Yi-Lightning的排名證明了國產大模型跟矽谷最頂尖模型的差距縮小到了五個月。

去跟追上美國最頂尖的模型,縮短這個時間差非常困難,要付出很大的努力和有獨特的打法。在國內不少公司都在努力,「模基共建」則是零一萬物自己摸索的獨特路徑。

參考連結:

[1]https://x.com/lmarena_ai/status/1846245604890116457

[2]https://x.com/01AI_Yi/status/1845776529185476613

— 完 —