出品丨AI 科技大本營(ID: rgznai100)

最近,IDEA研究院CVR(電腦視覺與機器人研究中心)團隊釋出T-Rex2模型,已向公眾開放了T-Rex2 API。該模型透過視覺與文本提示的互相融合,彌補視覺提示的一些關鍵缺陷,實作流暢可用的跨圖目標檢測。與多目標跟蹤模型結合後,T-Rex2可套用於各種視訊檢測任務。

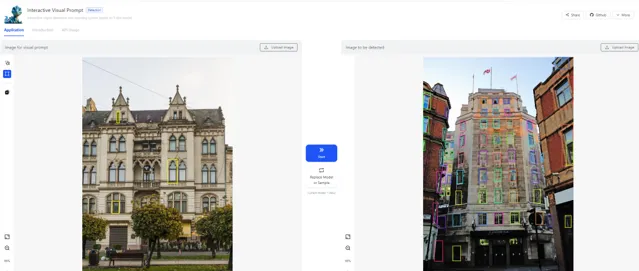

(T-Rex2影像檢測套用展示)

(T-Rex2視訊檢測套用展示)

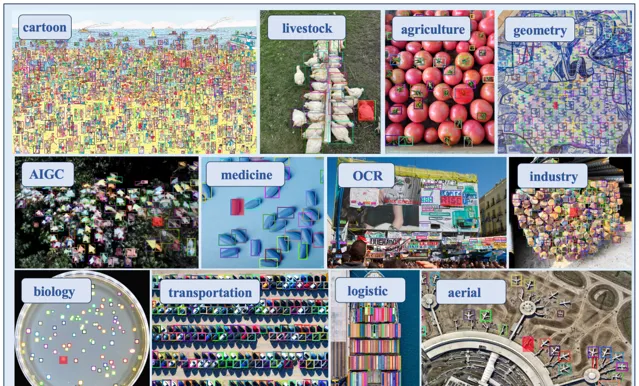

這個能力,讓目標檢測技術在生產生活中得以廣泛套用。如工業生產流水線器件檢測,交通航運領域的船舶、飛機檢測,農業領域的農作物、果蔬檢測,生物醫學領域的細胞、組織檢測,物流領域的貨物檢測,環境領域的野生動物監測等。

效能提升:文本+視覺提示,強跨圖辨識能力

T-Rex2 實作多重效能提升:

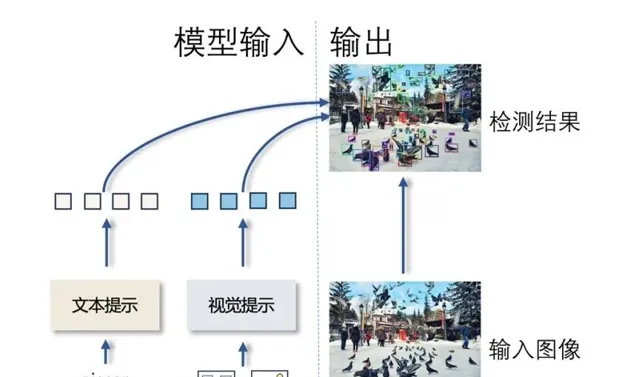

T-Rex2透過在一個模型中同時整合文本和視覺提示, 克服了文本與視覺這兩種提示模態各自的局限 ,包括文本提示長尾數據短缺、描述上的局限性,以及視訊提示在捕捉常見物件的概念時效果較差的局限。

文本和視覺提示的協同作用, 集合二者優勢 ,賦予了T-Rex2 強大跨圖檢測能力和零樣本能力。

(T-Rex2模型結構簡化圖)

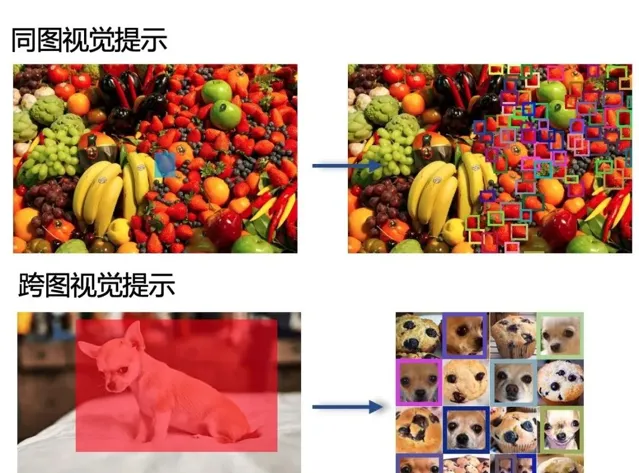

文本和視覺提示的協同作用賦予了T-Rex2 強大的 跨圖檢測能力和零樣本能力 。 跨圖檢測,即在實際工業套用中是 在 ⼀張或多張影像上進行視覺提示後,在其他影像上使用這個視覺提示進行檢測。

套用更加靈活,適應更多的檢測場景: 優於同圖辨識的跨圖辨識能力: 同圖辨識需要演算法能夠準確地在復雜的環境中辨識和分割多個物件,而 跨圖辨識則需要演算法具備更強的泛化能力和對細節的敏感度 ,以便在不同的影像條件下辨識和比較物件。

【同圖辨識(Intra-image recognition)是指在單個影像內部辨識和分類物件的任務。跨圖辨識(Inter-image recognition)是指在多個影像之間辨識相同或不同物件的任務。】

(T-Rex2跨圖檢測能力範例)

多種工作模式:文本、互動視覺、通用視覺

T-Rex2支持多種工作模式:

文本提示模式 :完全依靠文本提示進行物體檢測,與開放詞匯物體檢測的方法相同。這適合於常見物體的檢測。

互動式視覺提示模式 :使用者與模型直接互動,即是「human in the loop」的概念。比如可以自己畫點、畫框來標記檢測物體,然後根據模型輸出的反饋來修正檢測結果,如增加額外的提示。

通用視覺提示模式 :使用者可以透過向模型提供任意數量的範例圖片來自訂特定物件的視覺嵌入,然後使用這個嵌入來檢測任意影像中的物件,是不需要「human in the loop」。

T-Rex2還可用於視訊目標跟蹤。在T-Rex2 跨圖逐幀的檢測結果上,我們可以用現有的多目標跟蹤模型( 如ByteTrack ) 追蹤檢測物體。這讓T-Rex2可以輕松套用於各種視訊檢測任務。

(T-Rex2視訊檢測能力範例)

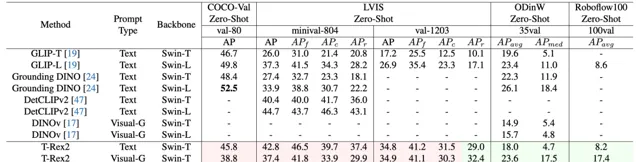

文本和視覺表現:4個零樣本SOTA

T-Rex2 在四個學術基準測試集 COCO, LVIS, ODinW和Roboflow100 上取得了Zero-Shot SOTA的效能表現。 文本提示在相對常見類別的場景中表現優異,而視覺提示在長尾分布的場景中表現更加穩健。這也說明將這兩種提示模態結合起來,能讓模型更好地適應不同的場景。

T-Rex2無需重新訓練或微調,即可檢測模型在訓練階段從未見過的物體。 該模型不僅可套用於包括計數在內的所有檢測類任務,還為智慧互動標註領域提供新的解決方案。 T-Rex2的釋出,使得大模型向通用物體檢測邁進了新的一步。

(T-Rex2 在各種應⽤場景下的檢測效果)

Playground連結 :https://deepdataspace.com/playground/ivp

T-Rex2 API :https://github.com/IDEA-Research/T-Rex

論文連結 :https://arxiv.org/abs/2403.14610

4 月 25 ~ 26 日,由 CSDN 和高端 IT 咨詢和教育平台 Boolan 聯合主辦的「 全球機器學習技術大會 」將在上海環球港凱悅酒店舉行,特邀近 50 位技術領袖和行業套用專家,與 1000+ 來自電商、金融、汽車、智慧制造、通訊、工業互聯網、醫療、教育等眾多行業的精英參會聽眾,共同探討人工智慧領域的前沿發展和行業最佳實踐。 歡迎所有開發者朋友存取官網 http://ml-summit.org、點選「閱讀原文」或掃碼進一步了解詳情。