5 月 26 日,第 103 期源创会在深圳成功举办。

本期邀请来自昇思 MindSpore、科大讯飞、Gitee AI、IDEA 的技术大咖们发表主题演讲。接下来一起看看活动的精彩瞬间吧!

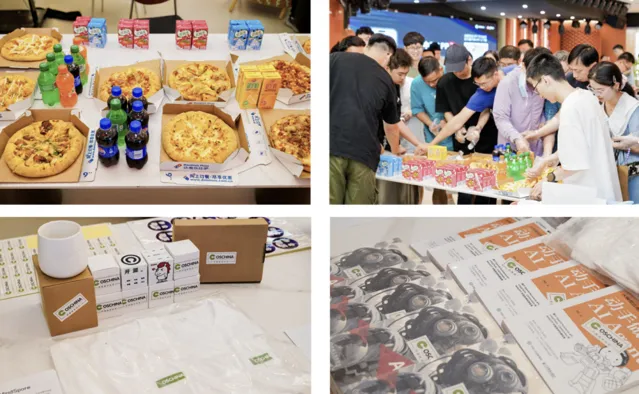

前方多图预警 >>>

满载而归了吗朋友们(ps:感谢机械工业出版社和异步图书赞助的图书

现场互动氛围超好 der~ (是的没错,你也可以直接冲到台上和讲师面对面聊

和🍠的合影 get

结束后的轰趴馆娱乐时间!

接下来进入主题演讲回顾 ⬇️ 可扫描下方二维码,查看视频回顾

昇思 MindSpore 训练创新与实践

昇思 MindSpore 大模型高级工程师姚逸璠带来了【昇思 MindSpore 训练创新与实践】主题分享。

姚逸璠介绍,昇思 MindSpore 开源已有 4 年,在大模型的行业落地方向探索最早,在多个行业场景实现了多个大模型的应用落地,如运用在电力行业的紫东太初全模态,煤矿行业的盘古矿山,等等。同时,昇思孵化的基础大模型涵盖了多个技术领域,对各个技术方向下的大模型孵化均有积累,如自然语言处理领域的盘古、计算机视觉领域的华为云盘古 CV、多模态领域的悟空等等。

为了方便开发者进行开发,昇思提供了全流程的基础模型套件,涵盖了大模型从开发、训练、微调到部署的全流程,开箱即用。在开发时,LLaMA 等预训练模型库已备好,15 + 基于昇思 MindSpore 的开源预训练大模型可直接获取使用。同时提供基于高阶 API 的灵活开发,10 行代码即可构建 LLaMA、BLOOM 等开源大模型全流程业务。

在训练时,昇思提供了丰富的训练模型库,多维混合并行,万亿参数模型,方便最大化利用有限的资源,提升集群的效率。

在微调时,昇思提供了丰富的低参微调,支持 LoRA/Prefix-Tuning/Adapter 等 6 种低参微调算法,支持千亿模型做人类反馈强化学习微调。目前,MindSpore RLHF 已开源。

姚逸璠介绍,昇思 MindSpore 的角色就是从用户的模型网络到底层硬件的中间件工具,是一个编译器架构,输入用户的训练网络,输出异构硬件上执行的任务。

在大模型大集群并行训练中,典型的大模型并行训练策略有:数据并行 + 优化器并行 + 模型并行 + 流水并行 + 重计算。无论是稠密的模型还是稀疏的模型,通信的开销都是非常大的。除了算力之外,整个大模型的开销还有算子级模型并行的通信开销、流水并行 Bubble 和数据并行拖尾时间。如果要扩展大万卡集群,那么在 Batch Size 受限的情况下,Pipeline Bubble 会加大;DP 拖尾增加,万卡集群线性度扩展;集群通信域更大,通信性能需要优化。

而算子级模型并行计算和通信无法并行,通信占比 20%-40%。那么,昇思是怎么做的呢?

昇思的思路是 —— 多副本并行:隐藏模型通信,优化算子级模型并行。数据和通信有数据依赖,无法并发,那就拆分为两个分支,一边计算一边通信。Case 1 在 Sequence 维度计算通信流水并发,Case 2 在 Batch 维度计算通信流水并发,隐藏 75% Tensor/Sequence/Expert 并行模型并行通信。这个技术在大模型已经应用上了,实测可以提升 10%-15% 的训练性能。

未来,昇思会加强万卡大集群训练性能优化、稠密大模型和稀疏 MoE 大模型性能优化,提升超长序列模型支持和千亿 / 万亿 RLHF 支持,做好多模态大模型和大模型高可用训练。

星火大模型 + 智能硬件的应用创新

科大讯飞开放平台高级产品经理郑重阳带来了【星火大模型 + 智能硬件的应用创新】主题分享。郑重阳介绍,科大讯飞在 2023 年 7 月开始担任国家大模型专家组联合组长,开发的 AI 能力和解决方案已有 600 多项。其中,星火认知大模型 V3.5 经过不断的迭代,文本生成、语言理解、知识问答、逻辑推理、数学能力、代码能力、多模态能力都有了全面提升,其语言能力和数学能力,已经全面超越了 GPT 4。

星火大模型目前支持多种接入方式,如公有云调用、专有云调用和私有云部署。同时,星火大模型支持多级优化方案组合,从提示词优化、知识库嵌入,到大模型微调和行业模型定制,满足行业不同场景需求。

此次分享,郑重阳还介绍了一些大模型在硬件产品的应用落地,主要分为 3 个产品线:一是穿戴产品,如手表;二是办公产品,如键鼠;三是个人硬件,如 PC 电脑。

在智能手表方面,大模型的加入可以带来如交互升级 ,定研的低功耗唤醒和合成技术,提升穿戴产品的交互次数;个性化助手,AI 人格为助手应用适应新生代的个性化诉求;轻应用,如虚拟教练、医养助手、日程助理等;AIGC 表盘 ,大模型的文生图能力,可提供千人千面的个性化表盘。

在智能键鼠方面,大模型的加入可以带来三个方面的提升,包括语音输入;智能助手,一句话、一个文本就能完成文稿撰写、PPT 生成、摘要总结生成、周报生成;智能截图通,过键鼠的点击,可以快速实现图文内容提取,包括表格识别、文本的快速翻译,大大提升工作效率。

在 PC 电脑方面,讯飞在底层采用了星火 1+N+X 模型的架构,在通用大模型、行业大模型、MaaS 微调模型和本地大模型之上,搭载了大模型原子能力、大模型配套能力、端云插件、端云知识管理和端云 AI 能力,从而可以很好地通过跨平台统一接口,实现应用的创新。如资料管家,根据已有的知识库,输出想要的问答。

基于星火大模型,讯飞也发布了星火语音大模型。在 13 个重要语种中,星火语音大模型的识别效果达到了 94%,其余 24 个主要语种达到了 90% 以上,效果超过了 OpenAI Whisper V3。

同时,基于大模型、Fine Tuning、Embedding、Rract、Prompt 工程和超自然合成等技术,深度模拟类人格反应的 AI 功能组件,还可以打造拟人化的助手,为 C 端用户提供个性化服务。目前,星火友伴这一产品已经上线。

另外,讯飞还推出了 iFlyCode 这一基于星火代码大模型的智能编程助手,提供了智能问答和沉浸式两种编程方式,致力于降低开发人员的专业门槛,解决软件开发的效能瓶颈。

郑重阳介绍,端云大模型应用在 PC 端,丰富组件灵活组合,可以轻松构建大模型应用。离在线交互智能协同,无网也可用。端云模型工具延时更低,效果更好。用户敏感数据纯本地执行,隐私更安全。

未来,讯飞会继续在教育硬件、可穿戴 AR/VR、音频、智能会议、直播行业、医疗康养设备等方向探索,挖掘大模型在其他硬件上应用的新方向。

端侧代码生成:以 MoonBit 为例

IDEA 基础软件中心高级工程师费浩祥带来了【端侧代码生成:以 MoonBit 为例】主题分享。费浩祥介绍,MoonBit 是一个编程语言,MoonBit AI 基于此而进行创新。不同于追求传统科研机构的单点创新,MoonBit 着眼于大规模系统工程能力,重点关注构建系统、编程语言和编译器,尽量让用户无痛上手使用语言。

目前,MoonBit 支持 WebAssembly、JVM、JavaScript、Native 等多后端,主要服务于三个方向:云、AI 和 教育。

在云 + 边缘方向,MoonBit 的目标是打造跨平台、体积小、编译快,可允许离线模式下的云 IDE。

在 AI 方向,MoonBit 创新融合了传统 IDE 与大模型智能,打造一个用户只需输入需求,大模型就能一键生成代码、部署调试无缝衔接的 AI first 平台。

在教育方面,MoonBit 的目标是打造全球化视野、业界领先的教学合作平台,无需插件,一键安装,让用户只需专注于写代码即可。

目前,MoonBit 已开放了标准库、构建系统和编译器,期望 2025 年可以发布 1.0 版本。MoonBit 核心标准库自 3 月 8 日开源核心标准库以来,社区反馈活跃,国内外 在校学生积极参与, 代码提交质量不亚于经验丰富工程师。

MoonBit AI,则是为 MoonBit 量身打造的一个 AI 编程工具,方便用户根据需求生成 MoonBit 代码,类似 Copilot。目前,MoonBit AI 采用的是重采样技术,利用编译器来辅助大模型的代码生成,从而达到响应速度快、实时性好、减少幻觉的同时,拥有更高质量的生成。

比较特殊的是,MoonBit AI 是可以部署在端侧的大模型,IDE 的强实时性要求给予了端侧大模型独特的性能优势,也开拓了不少可能性。无论是从开发人员的角度,还是从用户体验的角度,都变得更加简单了。大模型直接内置在编译器里面,大模型跟编译器的沟通会变得更高效。用户无论是得到传统编译器的反馈,还是大模型的代码补全,效率都更高了。

MoonBit AI 目前已经支持在 WASM 和浏览器中部署和训练模型。

大模型 Serverless 推理系统

Gitee AI 专家顾问、清华大学高性能计算所林家桢带来【大模型 Serverless 推理系统】主题演讲。林家桢指出,目前的大模型推理算力在面对复杂生态,难以优化整合算力资源,导致 AI 落地使用时各环节产品未能充分磨合优化,造成算力资源浪费。

Gitee AI 汇聚最新最热 AI 模型,提供模型体验、推理、训练、部署和应用的一站式服务,提供充沛算力,做中国最好的 AI 社区。Gitee AI 目前聚合了 2000 多个模型,但免费的算力资源有限,因此就需要更加高效地将这些免费算力按需分配给开发者使用,这在当下是一个非常有挑战性的问题。比如以往使用容器技术做外部开发时,单个容器的换入换出以及唤醒都非常迅速,但是这在大模型时代变难了,模型的唤醒和休眠导致容器的换入换出管理难以同以往的场景一样高效。

而 Serverless AI 具备 4 大优势,包括部署简单、开箱即用,降低算力使用成本,覆盖主流模型,支持多种算力硬件。目前的模型引擎或者说购买、使用算力的方式存在一个问题,即用户程序、模型、推理的芯片全都绑在一个容器上,占住硬件芯片,使用算力服务。而 Serverless 推理引擎整合优化算力资源,通过多个层级的解聚合,降低应用、模型、算力三者间的耦合性,按需分配算力,提高资源利用率。

Serverless 系统架构分为三层,最底层为编译器层,将在容器中加载模型改为 rpc 调用到远端服务的模式,接口没有改变,但是换成了后端的推理,以实现模型和芯片的解聚合。rpc 给到上一层的推理引擎,推理引擎是实际上发生计算的集群,这个层级则做了数据和算力解聚合。比如假设一个十张卡满足 3000 个模型的调度请求的任务场景,这时没办法在一张卡上固定加载某个大模型,便需要根据请求临时动态高效加载想要的模型,因此把计算的芯片和模型权重做解聚合,模型放在 TanserGraph 上,这是一个异构的内存系统,可支撑实现算力芯片和模型解聚合。在最上层,Serverless 层,则进行应用和推理解聚合。

Serverless 系统架构的核心能力是异构互联内存,解决模型权重问题。数据中心整机架构存在一些局限性,如资源利用率低、硬件扩展性受限等,解聚合技术可以将整机架构中各部件物理分离,使用一定互联链接各部件的控制界面(Control Plane)与数据界面(Data Plane),实现各类资源按需分配、扩容。此外,内存解聚合在云场景下也具备应用优势,包括提高云环境资源利用率和便于满足日益增长的内存资源需求。

但现有分层内存系统不适应解聚合架构下的高硬件弹性,系统扩展性也受限,并且由于系统内部结构限制,现有内存管理接口能力受限。异构互联内存则可以通过硬件访问统计、可编程策略、页迁移三个环节解决这些问题。以 CPU 为例,对于基于 PEBs 的访问统计上,支持硬件采集运行程序的访存情况,记录指令、TID、目的地址等,然后按需加载模型权重。

此外,Serverless 系统架构也具备了其他多种能力,如基于 MLIR 的多层次神经网络编译优化技术,基于用户态隔离技术的轻量化系统服务机制。Serverless 推理引擎基于两大核心知识产权技术构建,除此之外也整合了目前各类主流的推理系统优化技术。

104 期源创会·上海站 —— 云技术专场现已开启报名

>>> https://www.oschina.net/event/2332088

END

热门文章

-

-

-

-

-