一、Anthropic的成立背景

Anthropic是一家专注于人工智能安全和负责任开发的初创公司,成立于2021年,其创始团队都是GPT系列产品的早期开发者。在2020年6月,OpenAI推出了第三代大型语言模型GPT-3。然而,由于对OpenAI未来发展方向的担忧,特别是对微软投资可能导致的商业化倾向和对AI安全性研究的忽视,OpenAI的研究副总裁Dario Amodei和安全政策副总裁Daniela Amodei决定离开。

2021年,他们与另外 5 名 OpenAI 成员,包括GPT-3模型的主要开发者Tom Brown,一同创立了Anthropic,旨在构建可靠的(Reliable)、可解释的(Interpretable)和可操控的(Steerable)AI 系统。

Anthropic的目标本质上是开发使AI系统更安全的技术和识别AI系统安全或危险程度的方法。 公司名Anthropic意为」与人类有关的」。

Anthropic与OpenAI等头部大模型公司不同,主要采用to B商业化的模式。

目前,Claude的客户包括科技公司Gitlab(软件开发工具)、Notion(笔记应用程序)、Quora(海外问答平台)和Salesforce(Anthropic的投资者);金融巨头桥水公司(Bridgewater)和企业集团SAP,以及商业研究门户网站LexisNexis、电信公司SK Telecom和丹娜法伯癌症研究所(Dana-Farber Cancer Institute)。

据外媒The Information报道,Anthropic预测2023年度收入达到2亿美金,而2024年底其年化收入将超过8.5亿美元。

二、团队构成与专业背景

Anthropic 的创始团队成员,大多为 OpenAI 的重要员工或关联成员,这些人曾是 OpenAI 的中坚力量,参与了 OpenAI 的多项研究。在 GPT-3 论文 Language Models are Few-Shot Learners 中,前两位作者(Tom Brown 和 Ben Mann)和最后一位通讯作者、项目负责人(Dario Amodei)目前均在 Anthropic 工作。该论文的 31 名作者中,有 8 名目前在 Anthropic 工作。

(一)Dario Amodei-全职CEO兼联合创始人

Dario Amodei,意大利裔美国人,博士毕业于普林斯顿大学,后回到本科毕业的斯坦福大学担任博士后学者。Dario于2021年2月创办了 Anthropic 公司,任 CEO职位。他是 OpenAI 的前核心成员,也被认为是深度学习领域最为前沿的研究员之一。

Dario Amodei领导了GPT-2和GPT-3的开发工作,同时也是为OpenAI设定总体研究方向并撰写年度研究路线图的两个人之一。曾发表多篇 AI 可解释性、安全等方面的论文,离职前在 OpenAI 担任研究 VP。在此之前,Dario 还曾在百度和谷歌担任研究员。

(二)Daniela Amodei-联合创始人、总裁

Daniela Amodei是Dario Amodei的姐妹,曾担任OpenAI的安全政策副总裁。现担任Anthropic总裁,在公司中负责领导团队,并利用她在人员和管理方面的经验来推进公司构建可靠、可解释和可控的人工智能系统的目标。

Daniela曾经在国际发展、公共健康、政府政策以及政治领域工作过。Daniela 对于如何使 AI 系统更加安全和以人为中心有着深刻的见解,并且在推动 AI 安全性研究方面发挥了重要作用。

(三)Tom Brown-联合创始人

Tom Brown本科及硕士毕业于麻省理工学院。Tom Brown是Anthropic的联合创始人之一,曾是Open AI的核心技术人员,参与过GPT-3的开发建设,领导GPT-3的工程,并负责模型并行分布式训练基础设施,将参数从1.5B扩展到170B。

在此之前,Tom Brown也担任过谷歌大脑的技术人员。他是MoPub的创始工程师,也是 Grouper 的联合创始人和首席技术官。

(四)Sam McCandlish-联合创始人

Sam McCandlish本科及硕士毕业于布兰迪斯大学,博士毕业于斯坦福大学理论物理专业。Sam于2018年加入Open AI担任研究负责人,曾是核心成员之一。2021年离职后联合创办了Anthropic,研究方向是理学与哲学。

(五)Christopher Olah -联合创始人

Christopher Olah是Anthropic的联合创始人之一,也是 OpenAI 多模态神经元论文的作者之一。主要工作是将人工神经网络逆向工程成人类可以理解的算法。此前,他曾在OpenAI领导可解释性研究,在Google Brain工作,并与人共同创办了专注于优秀沟通的科学期刊【蒸馏】(Distill)。

(六)Ben Mann-联合创始人

Ben Mann是Anthropic的创始团队成员之一,也曾是Open AI的核心技术人员。在此之前,Ben Mann也先后在Open AI、机器智能研究所、谷歌担任软件工程师,离职谷歌后,自主创业,后再次以技术人员的身份入职Open AI。

(七)Jared Kaplan-联合创始人

Jared Kaplan是一位理论物理学家,同时也是一位机器学习专家,于2021年联合创办了Anthropic。2018年起担任霍普金斯大学副教授,主要研究领域是机器学习研究,包括神经模型的缩放规律以及GPT-3语言模型。曾为OpenAI合同研究顾问。

(八)Jack Clark -联合创始人兼政策主管

Jack Clark 是 Anthropic 公司的联合创始人兼政策主管。Jack Clark 还担任斯坦福大学人工智能研究所(Stanford HAI)的 AI 指数指导委员会的联合主席。

三、Anthropic的主要产品

大语言模型Claude

1、Claude模型发展历史

2023年3月,Anthropic推出了早期的Claude版本,最早是Claude和Claude Instant两个模型,能够处理内容的最长长度为9000个token,提供API和Slack平台上的机器人两个渠道。

2023年7月,Anthropic推出Claude 2,推出自有网站claude.ai上的面向公众版本,提供高达100K token(大约相当于 75,000 个单词)上下文窗口,显著优于GPT-3和GPT-4,这也是Claude 2的核心竞争力。

2023年11月,Anthropic紧贴着OpenAI的GPT-4 Turbo在同月推出Claude 2.1,Claude 2.1 为企业提供了关键功能,业界领先200K token上下文窗口(是 Claude 2.0 的 2 倍)、降低了幻觉率(减少50%)、提高了长文档的准确性(错误减少30%)、系统提示以及用于函数调用和工作流程编排的测试版工具使用功能。

2024年3月,Anthropic推出他们新一代的大模型Claude 3 模型系列,该系列包含三个模型,按能力由弱到强排列分别是 Claude 3 Haiku、Claude 3 Sonnet 和 Claude 3 Opus。

2、Claude 3大模型评估

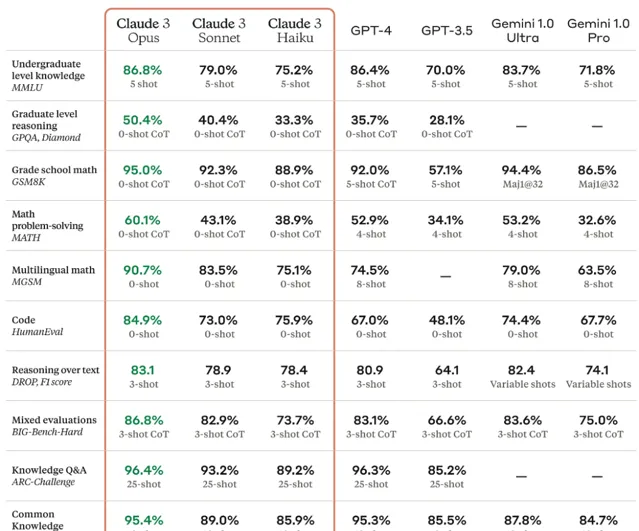

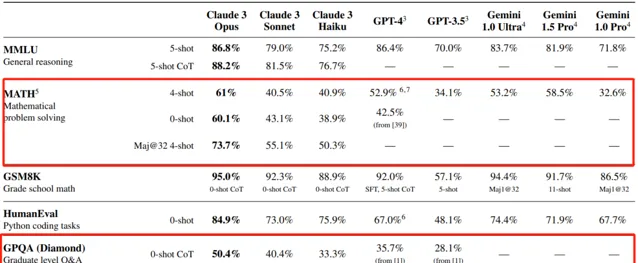

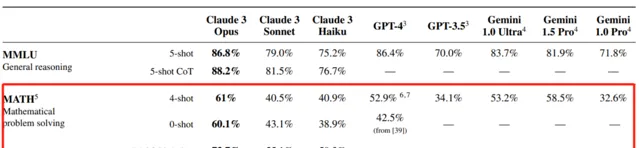

根据Anthropic公布的技术报告,能力最强的 Opus在大多数常见的 AI 系统评估基准上都优于同行,超过了 GPT-4 和 Gemini 1.0 Ultra,包括MMLU (大规模多任务语言理解)、GPQA(研究生水平专家推理)、GSM8K(基础数学)等。Sonnet的性能与GPT-4不相上下;Haiku则略逊于GPT-4。不过,这项测试中没有包含刚刚更新的GPT-4 Turbo和Gemini 1.5 Pro。

不过根据业界反馈MMLU(大规模多任务语言理解)/ GSM8K (基础数学)/ HumanEval(编程能力)等热门指标实质基本饱和,虽然Claude 3在HumanEval指标数据上显示效果表现优异,但业界基本认为头部大模型在这些指标上性能几乎一样。

Claude 3 Opus最大的亮点是在GPQA(研究生水平专家推理)和Math(数学问题解决)这两部分评估指标的突破。

GPQA(研究生水平专家推理)

GPQA(Graduate-Level Google-Proof Q&A),是一个由生物学、物理学和化学领域专家编写的具有挑战性的多项选择题数据集,Claude 3 Opus在GPQA上用0-shot CoT(仅加入「Let's think step by step.」 的思维链)准确率约为50%,用Maj@32 5-shot CoT(32次结果择多数,增加5次示范和思维链)准确率约为60%。

这是一个极大的突破,即使是拥有博士学位(与待解决问题属于不同领域)且可以访问互联网,准确率也只有34%。而在同一领域且拥有博士学位的人(同样可以访问互联网)的准确率在65%到75%之间。由于Claude 3.0的数据集截止到2023年8月,而GPQA Bechmark的发布时间在2023年11月,Claude 3.0完全没有机会去「刷题」,能力是天然的。

Math(数学问题解决)

Math(数学问题解决)是一个相较GSM8K(基础数学)更高要求的数学问题解决能力评估指标,包含12,500个具有挑战性的新数据集竞赛数学问题。Claude 3 Opus在Math上用0-shot(不进行示范问答)准确率约为60%,用Maj@32 4-shot(32次结果择多数,4次示范)准确率约为73.7%,数学问题解决能力上的突破更能凸显Claude 3 Opus在技术上的突破。

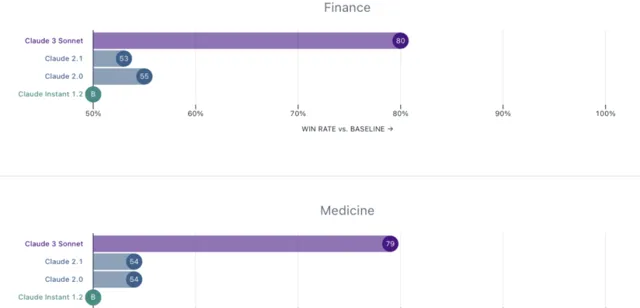

领域专家评估

Anthropic特别邀请了金融、医学、哲学和STEM(科学、技术、工程和数学)领域的专家对公司的历史模型进行了评估,从结果上看,公司的中间层产品Claude 3 Sonnet相较公司历史模型都有了极大的提高,偏好胜率在60-80%。

3、Claude 3上下文长度和召回率

Claude在GPT-4时代仍然可以获得大量用户的最核心竞争力,主要就依靠其较强的长上下文文本记忆能力。Claude 2拥有的100k token上下文能力,让它在面对论文、报告等长内容时,准确率和细致程度远超只支持32k上下文的原初GPT-4版本。

自GPT-4Turbo升级到提供128k上下文长度之后,Claude的这一优势就再难彰显。同月,Claude紧急推出2.1版本,支持200k上下文长度,但在实际体验上,大家很快就发现Claude 2.1虽然支持文本长,但召回率很低,很多内容都会被忽略或遗失,不具有实用性。

Claude 3.0 支持200k token的上下文输入,在Claude 3 Opus模型下的召回率能达到98.3%,基本上能做到无遗忘,长文本支持得到真正实现。

4、Claude 3模型定位及定价

从特性上看,Claude 3三款模型针对不同的场景:

①Opus:最强大、最智能,是Anthropic的主力大模型

②Sonnet:性价比最高,在对比中显著超过Claude 2.0、Claude 2.1。

③Haiku:成本最优,市场上速度最快、成本效益最高的模型。

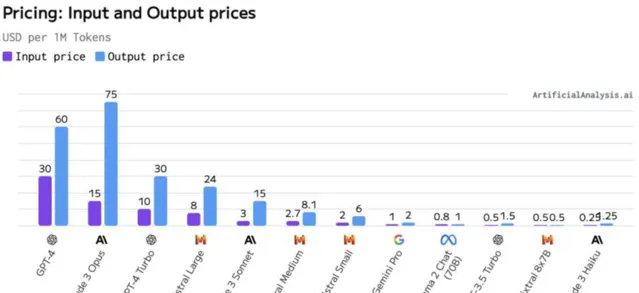

在定价上(ToB,每百万tokens)

① Opus:$15 (input) / $75(output)。对标模型为GPT-4,它的定价水平与GPT-4相当,高于GPT-4 Turbo。

② Sonnet:$3(input) / $15(output)。在中型模型中定价具有竞争力,比所有GPT-4版本便宜,在质量上接近Mistral Large,但在价格上更接近Mistral Medium。

③ Haiku:$0.25(input) / $1.25(output)。价格非常有竞争力,最接近小型模型,同时在能力上可以与中型模型竞争。

四、Anthropic的AI研究工作

(一)Anthropic团队对AI的看法

Anthropic 秉持两个重要的信念:无限进步和安全。前者是指只要不断增加计算资源,这些语言模型就会得到持续改进和发展。不过,仅靠增强计算资源并不能让基础模型自然生成价值观,因此还需要注意模型与人类价值的对齐和安全性,这一点非常重要。

因此,与「 ChatGPT 」和「 Bard 」相比,Anthropic 的聊天机器人 「 Claude 」的优势之一在于安全性和可控性。许多早期企业用户希望模型的行为是可预测的,而且不会随意编造事实,这些都是「 Claude 」设计时所考虑的。

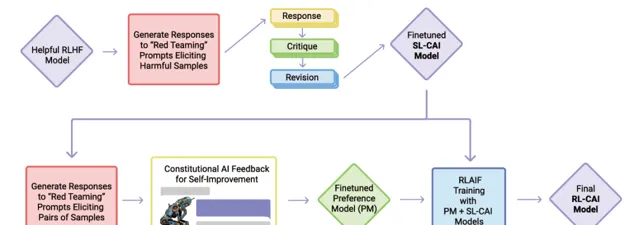

「 Claude 」的独特之处还在于「宪法式 AI 」(constitutional AI.)。与依赖「基于人类反馈的强化学习」的常见聊天机器人不同,「 宪法式 AI 」的核心思想是由一群人来评估和指导模型表现,明确指出哪些回答更好,来训练出一个监督管理AI,进而为「 Claude 」进行标签及反馈,这些评分被汇总起来以训练模型按照用户期望行动。「宪法式 AI 」允许用户更透明地了解模型正在做什么,也更容易被控制,确保其安全性。

(二)Anthropic的研究领域

1、AI能力方面

旨在使AI系统在任何类型的任务上变得更好的AI研究,包括写作、图像处理或生成、玩游戏等。使大型语言模型更高效或改进强化学习算法的研究都属于此类。这方面的工作会生成并改进Anthropic在对齐研究中调查和使用的模型。

2、对齐能力方面

对齐能力方面研究专注于开发新算法,使AI系统在有用性、诚实性和无害性以及更可靠、稳健和与人类价值观更一致方面变得更好。

Anthropic目前和过去进行的这类工作包括辩论、扩展自动化红队攻击、宪法AI、消除偏见以及RLHF(基于人类反馈的强化学习)。这些技术通常具有实用价值和和经济价值,但并非一定如此——例如,它们可能相对低效或仅在AI系统能力更强时才有用。

3、对齐科学方面

对齐科学方面主要关注评估与理解AI系统是否真正对齐,对齐能力技术的工作效果如何,以及我们能在多大程度上将这些技术的成功推广到更有能力的AI系统。

Anthropic在这方面的工作包括机械可解释性、用语言模型评估语言模型、红队攻击和使用影响函数(见下文)研究大型语言模型中的泛化的工作。我们在诚实性方面的一些工作处于对齐科学与对齐能力之间的边界。

对齐能力研究试图开发新算法,而对齐科学试图理解和揭示它们的局限。如果AI安全问题确实能容易解决,那么对齐能力工作可能是Anthropic最具影响力的研究。相反,如果对齐问题更困难,那么将越来越依赖对齐科学来找到对齐能力技术的漏洞。如果对齐问题实际上几乎不可能解决,那么就需要对齐科学来建立一个非常强有力的论据,以阻止发展先进的AI系统。

(三)Anthropic的安全研究项目

1、机制可解释性

长久以来,我们都无从理解AI是如何进行决策和输出的。模型开发人员只能决定算法、数据,最后得到模型的输出结果,而中间部分——模型是怎么根据这些算法和数据输出结果,就成为了不可见的「黑箱」。

针对这个问题,Anthropic一直试图将AI的神经网络逆向工程为人类可理解的算法,Anthropic希望这最终可以使我们做类似于「代码审查」的事情,审核我们的模型,以确定不安全的方面,或者提供强有力的安全保证。

目前阶段,Anthropic团队实现将小模型的神经元分解出可解释特征,在小模型上实现一定的可解释工作,Anthropic认为小模型上的成功意味着大模型同样也可以解释,对大模型黑箱的解释将只是个工程问题。(在Anthropic的最新研究报告,Towards Monosemanticity: Decomposing Language Models With Dictionary Learning(【走向单语义性:用字典学习分解语言模型】),Anthropic团队将包含512个神经元的层分解出了4000多个可解释的特征。)

2、可扩展的监督

AI实现对齐,需要大量高质量的反馈信息来引导。目前主要的问题是人类可能无法提供必要的反馈信息。这既包括人类无法提供可靠的反馈来充分训练模型,也包括人类可能会被AI系统愚弄,无法提供反映人类实际需求的反馈。这就是可扩展的监督问题,它可能是训练安全的、对齐的AI系统的核心问题。

Anthropic认为提供必要监督的唯一方法,是让AI系统部分自我监督,或协助人类进行自我监督。Anthropic将少量高质量的人类反馈信息,训练出高质量的负责监督AI。这个想法目前已经通过RLHF和CAI等技术显示出前景。

宪法AI(Constitutional AI,CAI)

CAI是Anthropic公司理念的产物,CAI通过使用AI反馈来评估模型输出内容,以应对语言模型的缺点。CAI使用一套基本原则来判断产出,因此被称为「宪法」。

Anthropic目前的宪法原则借鉴了一系列来源,包括【联合国人权宣言】、信任和安全最佳实践、其他人工智能研究实验室提出的原则、捕捉非西方观点的努力,以及他们通过早期研究发现的行之有效的原则。

Anthropic用自己的宪法原则来训练出CAI,再通过这个现成的语言模型来生成偏好标签,对大模型进行监督反馈,代替传统依赖人类反馈的方法。这种方法在文本摘要、有益对话生成和无害对话生成等任务上,已经显示出与人类反馈训练相当或更优的性能。

3、面向过程的学习

只要知道最终目的,反复试错是学习新任务的一种好方法,可以不断尝试新的策略直到成功。Anthropic称这种方法为「面向结果的学习」。在面向结果的学习中,智能体的策略完全由期望的结果决定,并且智能体将(在理想情况下)收敛于一些使其能够实现这一目标的低成本策略。

4、理解泛化

大型语言模型已经展示了各种令人惊讶的涌现行为,从创造力到自我保护再到欺骗。当一个模型表现出令人担忧的行为,例如扮演一个欺骗性对齐的AI角色,它只是对几乎相同的训练序列无害的机械重复?或者这种行为是否已经成为模型内核的一部分?Anthropic正在研究如何将模型的输出追溯到训练数据的技术,即模型是如何泛化的,以实现理解模型的行为表现。

5、检测危险的失败模式

高级AI可能会发展出有害的涌现行为,例如欺骗或战略规划能力,而这些行为在小模型中是不存在的。Anthropic致力于在此类问题成为直接威胁之前对其进行预测。目前,Anthropic主动将这些属性训练成小型模型,以便隔离和研究这种危险AI的行为模式。

Anthropic的目标是定量分析建立这些趋势如何随规模而变化,使我们可以提前预测突然涌现的危险失败模式。

6、社会影响和评估

Anthropic非常关注日益强大的AI系统的快速部署将如何在短期、中期和长期影响社会。目前正在开展各种项目,以评估和减轻AI系统中潜在的有害行为,预测它们被使用的方式,并研究它们的经济影响。这项研究也为Anthropic制定负责任的AI政策和治理的工作提供了信息。

通过对当今AI的影响进行严格的研究,Anthropic旨在为政策制定者和研究人员提供他们所需的见解和工具,以帮助减轻这些潜在的重大社会危害,并确保AI的益处在整个社会中被广泛而均匀地分配。

六、估值及融资情况

(一)估值及融资情况

Anthropic最新融资估值达184亿美元,历史融资合计超75亿美元。

A轮融资:2021年5月,Anthropic 宣布完成了 A 轮融资,金额为 1.24 亿美元。此轮融资由 Skype 联合创始人 Jaan Tallinn 领投,其他支持者包括 Facebook 和 Asana 联合创始人 Dustin Moskovitz、前谷歌首席执行官 Eric Schmidt。

B轮融资:2022年4月,Anthropic宣布完成了 B 轮融资,金额为 5.8 亿美元。此轮融资由 FTX 首席执行官 Sam Bankman-Fried 领投。

战略投资:2023年2月,谷歌向 Anthropic 投资了约 3 亿美元,以换取该公司 10% 的股份,并要求 Anthropic 将谷歌云作为其首选云服务提供商。

C轮融资:2023年5月,Anthropic 宣布完成了 C 轮融资,金额为 4.5 亿美元。领投方为 Spark Capital,参与方包括 Google、Salesforce 通过其子公司 Salesforce Ventures 以及 Zoom 通过 Zoom Ventures。此外,还有 Sound Ventures、Menlo Ventures 和其他未披露的投资方。

战略投资:2023年8月,韩国最大的移动运营商之一 SK Telecom(SKT)宣布投资了 1 亿美元。

战略投资:2023年9月,亚马逊宣布与 Anthropic 正式展开战略合作,并承诺投资 40 亿美元。Anthropic 将通过亚马逊的云计算服务为其客户提供生成式 AI 服务,并使用 AWS Trainium 和 Inferentia 芯片。

追加投资:2023年10月,谷歌同意对 Anthropic 追加最高 20 亿美元的投资,其中包括 5 亿美元的预付现金注入,剩余的 15 亿美元将随着时间的推移追加投资。Anthropic本轮估值达184亿美元。

(二)财务情况

收入情况

由于Anthropic未上市,其财务情况主要通过访谈或者媒体新闻了解。

根据Anthropic和投资人洽谈消息,2023年年化收入实现 2 亿美元(2023年10月预测数)。

据外媒The Information报道,Anthropic预测2024年底年化收入将超过8.5亿美元。

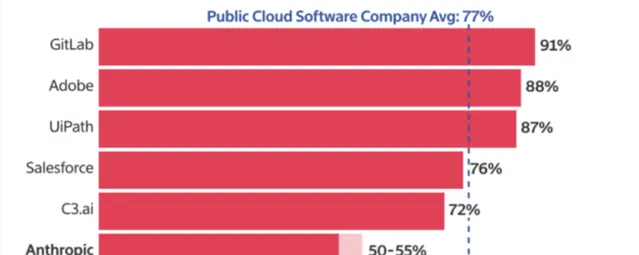

毛利率情况

根据 Information 报道,在支付客户支持和AI 服务器成本后,2023年12月Anthropic的毛利率在50%—55%,根据Meritech Capital的数据,这远低于云软件公司77%的平均毛利率。

还有一位重要股东预测,Anthropic长期毛利率将在60%左右,且该毛利率未反映训练 AI 模型的服务器成本,因为这些成本是被 Anthropic 纳入其研发费用中。

小结

Anthropic 作为一家专注于AI安全性和负责任开发的公司,凭借其由GPT系列产品早期开发者组成的创始团队,在AI领域展现出了强大的创新能力和深厚的技术积累。

公司推出的Claude系列模型在处理长文本和特定领域问题上取得了显著进展,其「宪法式AI」等创新方法体现了对AI安全性和可控性的高度重视。此外,Anthropic在AI的社会影响评估和负责任的AI政策制定上也表现出了前瞻性,走出自身差异化优势。

同时,我们也关注到,公司的大模型与同业之间差异化还不明显,公司毛利率及盈利能力相对估值来说还有较大压力。未来,Anthropic如何在保持技术领先优势的同时,进一步实现商业化和社会责任的平衡,将是其持续发展的关键。

• END•

↓↓↓

我们也开始卷老板了~

更多AI干货,关注老胡看AI