計畫簡介

StoryDiffusion是一個由南開大學HVision實驗室開發的計畫,致力於透過一致性自註意力機制,實作長序列影像和視訊的生成。該計畫不僅能生成一致性影像,還能預測視訊中的運動,從而創造出連貫的視訊故事。該技術適用於所有基於SD1.5和SDXL的影像擴散模型,並推薦使用者提供至少三個文本提示以最佳化布局排列。

掃碼加入交流群

獲得更多技術支持和交流

(請註明自己的職業)

視訊DEMO

關鍵特征

StoryDiffusion 能夠透過生成一致的影像和視訊來創造神奇的故事。主要特點有兩部份:

1.為了實作長序列中角色一致的影像生成,采用了一致性自我關註機制。這種機制是熱插拔的,相容所有 SD1.5 和 SDXL 基礎的影像擴散模型。在當前的實作中,使用者需要提供至少 3 個文本提示用於一致性自我關註模組。推薦至少提供 5 - 6 個文本提示以便更好的布局安排。

2.長範圍視訊生成的運動預測器,該預測器在壓縮的影像語意空間中預測條件影像之間的運動,實作更大範圍的運動預測。

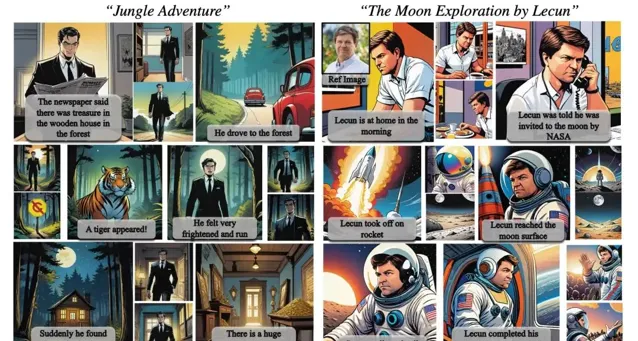

範例

·影像到視訊生成(結果為了速度進行了高度壓縮)

利用一致性自我關註機制生成的影像,可以透過在這些影像之間無縫過渡來擴充套件到視訊的生成。這可以被視為一種兩階段的長視訊生成方法。

註意:為了加速,結果進行了高度壓縮,你可以存取網站檢視高品質版本。

https://storydiffusion.github.io/

·長視訊生成(新更新)

結合這兩部份,可以生成非常長且高品質的 AIGC 視訊。

·使用條件影像的長視訊結果

影像到視訊模型可以透過提供一系列使用者輸入的條件影像來生成視訊。

·短視訊

依賴與安裝

· Python >= 3.8(推薦使用 Anaconda 或 Miniconda)

· PyTorch >= 2.0.0

conda create --name storydiffusion python=3.10conda activate storydiffusionpip install -U pip# Install requirementspip install -r requirements.txt

原文連結

https://github.com/HVision-NKU/StoryDiffusion

關註「 開源AI計畫落地 」公眾號

與AI時代更靠近一點