作者 | 王軼群,王啟隆

出品丨AI 科技大本營(ID:rgznai100)

視訊生成大模型賽道強者接連誕生。

繼 Vidu、快手可靈、Luma AI 輪番炸場後,又一位 Sora 挑戰者來了!

這次是由視訊生成領域的核心玩家 Runway 宣布即將推出的 Gen-3 Alpha。

據 Runway 官方介紹, Gen-3 Alpha 是其 推出的最新視訊生成基礎模型,「第三代 Alpa 是高保真、可控視訊生成的新前沿」。

Runway 表示, Gen-3 Alpha 能生成具有復雜場景變化、多種電影風格選擇以及詳細藝術指導的高品質視訊。

「Gen-3 Alpha 是 Runway 在全新大規模多模態訓練基礎設施上訓練的第一個模型,標誌著我們在構建通用世界模型(General World Models)目標上的重要進展。」該公司強調。

話不多說,先上官方視訊——來看看由 Gen-3 Alpha 制作的一個完整視訊短片長什麽樣?場面恢弘,大片既視感!

簡單提示詞,即可誕生影視級畫面

提示詞:一個超速行駛的 日本城市 列車, 窗戶上 對映出一個女人的微妙倒影。

可以看到,人物面部柔和自然,倒影的沿路光線在女人面部絲滑流轉,光影效果堪比影視片段。

提示詞:一位太空人在裏約熱內盧的小巷中奔跑。

太空人運動流暢,其運動速度與兩邊模組屋的倒退速度基本一致,整體畫面毫無違和感。

提示詞:第一人稱視角(FPV)穿過森林,到達一座廢棄的房子,然後進入海浪。

鏡頭一路縱深,從幽靜森林到古建築藏書閣,再到石柱長廊,直到海浪直接沖刷進來。這場景轉化,在傳統影視制作上,應該需要不少技術及經費,而在 Runway Gen-3 Alpha 的官方演示中,只需一句提示詞描述。

提示詞:一名老年男子在側光下彈鋼琴。

手指紋路、身體擺動、衣服褶皺,還有光源由遠及近的變化,就好像在攝影棚拍攝的一樣。

提示詞:在 1980 年代風格的廚房裏,鏡頭以電影般的緩緩推移,最終聚焦於一只站立的鴕鳥。

復古的陳列及光線下,一只鴕鳥活靈活現,同時運鏡也很穩。時光穿越和奇妙組合,在簡單提示詞下就這樣輕松實作了。

Runway 官方表示,以上視訊皆由 Gen-3 Alpha 生成,未經任何修改。

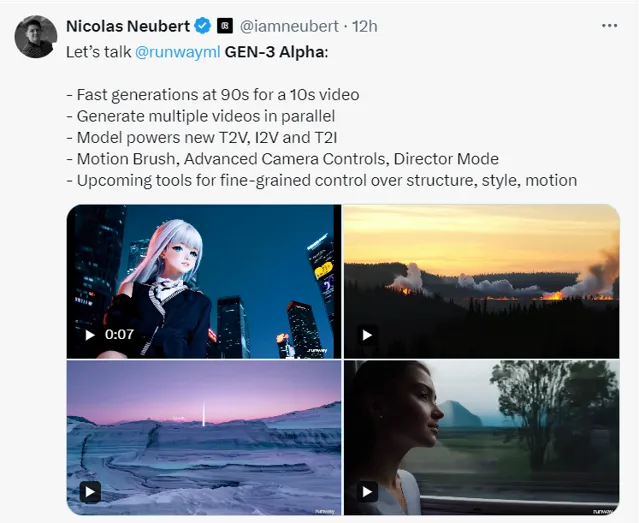

該公司介紹道, Gen-3 Alpha 在視訊和影像上聯合訓練,將支持 Runway 的文本轉視訊、影像轉視訊和文本轉影像工具,還包括現有的控制模式如運動刷、先進攝影機控制和導演模式,以及即將推出的更多精細控制結構、風格和運動的工具。

從其官網的幾個視訊 demo 的展示來看,效果確實不錯。

跨學科團隊支持,為創意而生

只有單人的微場景視訊嗎?

不, Gen-3 Alpha 可以整場演唱會!

其熱鬧非凡的效果,多人躁動的場面,舞台燈光的快速變化,以及航拍到近場的視角,讓網友直呼效果炸裂、迫不及待想嘗試:「看起來比其他 AI 生成的視訊好多了!令人印象深刻!以 這樣的發展速度,你很快就無法區分 AI 生成的視訊和真實視訊了。」 「難以置信。你知道生成這個要花多少錢嗎?」

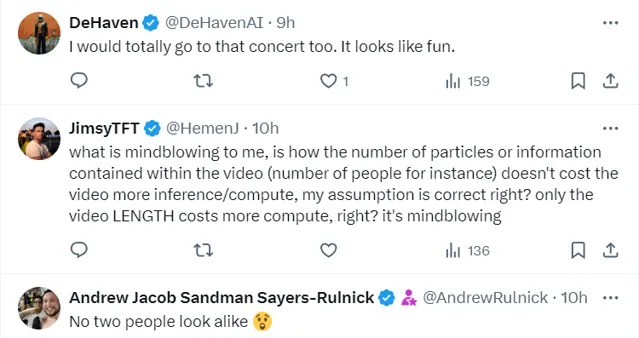

還有網友表示想去聽演唱會、震驚沒有長得一樣的兩人:「我肯定會去聽那場音樂會。看起來很有趣。」 「讓我吃驚的是,視訊中包含的粒子或資訊的數量(例如人數)不會讓視訊花費更多的推理/計算時間,我的假設是正確的,對吧?只有視訊長度會花費更多的計算時間,對吧?這真是令人吃驚!」 「沒有兩個人長得一模一樣!」

官方表示,Gen-3 Alpha 為創意和創作而生,是為創意套用從頭開始訓練的。

為什麽能生成如此效果炸裂而又流暢自然的視訊?

其背後的跨學科研究團隊的付出不容忽視。據 Runway 介紹,訓練 Gen-3 Alpha 是一支由研究科學家、工程師和藝術家組成的跨學科團隊的合作成果。這樣團隊支持,能讓 Gen-3 Alpha 詮釋各種風格和電影術語。

據 iamneubert 的 Nicolas Neubert 透露,Gen-3 Alpha 模型的生成速度非常之快。官方分享的演示視訊普遍徘徊在 10 秒水平線上,而這 10 秒視訊只需要 90 秒的時間就能快速生成。

Runway Gen-3 Alpha 具備以下功能特點:

高保真視訊生成:能夠生成接近真實世界品質的視訊內容,具有高度的細節和解析度。

精細動作控制:模型能夠精確控制視訊中物件的動作和過渡,實作復雜場景的流暢動畫。

逼真人物生成:特別擅長生成具有自然動作、表情和情感的逼真人類角色。

多模態輸入:支持文字轉視訊、影像轉視訊、文字轉影像等多種創作方式。

支持專業創作工具:支持運動畫筆、相機控制和導演模式等專業創作工具。

高品質訓練:使用高描述性的、時間密集的字幕進行訓練,使模型能夠理解和生成具有豐富時間動態的視訊。

「這一技術的飛躍代表了我們在支持藝術家創新方面的重要裏程碑,為下一代創意和藝術創新鋪平了道路。」 Runway 表示。

同時,Gen-3 Alpha 還將配備一套新的安全措施,包括改進的內部視覺稽核系統和 C2PA 溯源標準,以確保內容的安全可靠。

為創作而生的 Gen-3 Alpha 還開啟了行業客製模式。 Runway 還表示:「作為 Gen-3 模型家族的一部份,我們與領先的娛樂和媒體組織合作,推出了 Gen-3 Alpha 的客製版本。」

Gen-3 模型的客製化使角色能夠實作更多風格化控制和一致性,滿足特定的藝術和敘事需求。

跟 Gen-2 相比, Gen-3 在細節、一致性和運動表現方面有了顯著改進。要知道,包括【黑寡婦】【瞬息全宇宙】等知名電影都運用了 Runway 的技術支持。Gen-3 將為影視創作帶來怎樣的效果和便利,我們拭目以待。

即將開放和更多的競爭

等不及了,什麽時候可以試用?

官方表示,Gen-3 Alpha 將在未來幾天內向所有人開放。對此,使用者和 AI 業界大佬都好評不斷、一片歡騰。

Hugging Face 聯合創始人兼 CEO Clément Delangue 表示:「太酷了!誰將成為因 開源視訊收獲百倍影響力 的幸運兒? 」

PyTorch 之父 Soumith Chintala 表示:「部份視訊演示已達到 Sora 級別。不過我還想看到它生成人群擁擠的街道一類的短視訊來看看效果如何。」

而上文提到的演唱會人群視訊,也從側面證明了其效果。

然而,也有人對其安全性表示了質疑。

Fairly Trained 公司執行長 Ed Newton-Rex 表示:「這看起來是一個令人印象深刻的模型。它是否接受過受版權保護的作品的訓練?如果是,該作品是否已獲得授權?」

他曾任Stability AI 音訊副總裁,也是一位作曲家。

還有網友表示:「我們需要藝術安全專家來防止Gen-3 Alpha自我泄露。」

Runway是AI視訊生成領域的先行者,2023年2月Runway釋出第一代視訊生成模型Gen1,支持視訊風格轉繪;隨後在2023年3月釋出Gen2,拉開了文生視訊和圖生視訊的序幕。

這一次的 Gen-3 Alpha 釋出能否讓王者重回視訊生成帝王寶座?

不可忽視的是,目前視訊生成賽道競爭者眾多。就在 Gen-3 Alpha 官宣的當天,Luma AI 宣布 Dream Machine 即將帶來更強大的編輯功能和更直觀的操作體驗。

谷歌也不甘示弱,其人工智慧研究實驗室 DeepMind 表示正在開發用於為視訊生成配樂的人工智慧技術。谷歌在社交平台 X 上宣布推出新的模型技術 Video-to- audio,該技術 支持根據視訊和文本提示詞生成和視訊匹配的音訊,甚至可以與主體角色唇形同步。

官方 demo 中,該技術為彈吉他視訊生成的配樂,與人物動作極其一致,且配樂動聽。

多重工具的爭相改進和釋出,將為創組者和使用者帶來多重選擇,同時也會反向激勵更多新模型新技術的誕生。 視訊生成大模型百花齊放,爭奇鬥艷,Runway的此次 Gen-3 Alpha 也會一定程度上續寫其 核心玩家的新華章。

參考連結:

https://runwayml.com/blog/introducing-gen-3-alpha/

https://mp.weixin.qq.com/s/ud_ZbZFMGu1SYSYYExPWDA

由 CSDN 和 Boolan 聯合主辦的「2024 全球軟體研發技術大會(SDCon)」將於 7 月 4 - 5 日在北京威斯汀酒店舉行。

由世界著名軟體架構大師、雲原生和微服務領域技術先驅 Chris Richardson 和 MIT 電腦與 AI 實驗室(CSAIL)副主任,ACM Fellow Daniel Jackson 領銜,BAT、微軟、字節跳動、小米等技術專家將齊聚一堂,共同探討軟體開發的最前沿趨勢與技術實踐。

大會官網: http://sdcon.com.cn/ (可點選 閱讀原文 直達)