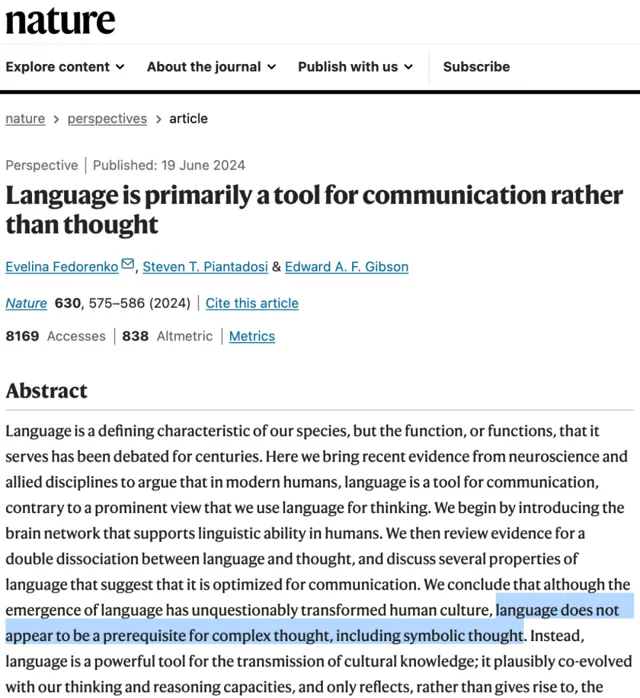

【導讀】 在【自然】雜誌發表的論文「Language is primarily a tool for communication rather than thought」中,科學家們提出了一個顛覆性的觀點:語言並非思維的必需品,而是一種溝通工具。這一發現對大語言模型(LLM)的邏輯推理能力提出了挑戰,引發了對通用人工智慧(AGI)實作途徑的重新思考。本文作者深入探討了在 LLM 推理能力受限的情況下,如何利用其優勢,同時避免其缺陷,提出了一系列策略,並展望了 AI 技術的未來發展方向。文章還討論了多模態訓練、任務目標訓練等可能的解決方案,並預測了 AI 產業的發展前景,為讀者提供了一個關於 AI 發展現狀和未來可能性的全面視角。

作者 | 盧威

責編 | 唐小引

出品丨AI 科技大本營(ID:rgznai100)

近日,【自然】雜誌刊發了麻省理工學院(MIT)等機構撰寫的論文「Language is primarily a tool for communication rather than thought」(【語言主要是溝通而非思維工具】)。揭示了人腦研究中的發現,包括:

語言對於任何可經測試的思維形式都不是必需的——不必要;

完整的語言系統似乎並不意味著完整的推理能力——不充分。

以預測下一個詞元(Token)為主要模式的大語言模型(LLM)的邏輯推理等能力有缺陷,是否能據此實作通用人工智慧(AGI)本就備受質疑,這下它頭頂上又飄來一朵濃重的烏雲。

預測下一個詞元的自回歸模型本來就是在理論證明暫缺的情況下經驗嘗試先行的產物。要證明或者證偽,目前辦法也只有繼續訓練更大規模的模型看效果。OpenAI 已經公布一年半後才會有 GPT-5,本文旨在討論這期間 LLM 技術的套用問題和對未來的預判。

在 LLM 暫時並且可能長期不能解決推理問題的情況下,我們提出以下策略。因為深度神經網路與傳統軟體一大不同是其功能和形成功能的構件難以進行獨立和清晰地劃分,所以以下各點策略有某種程度的重疊和關聯,關鍵是把握要旨。

一、盡量利用 LLM 知識和常識提取的能力,達到啟發性的目的。

這裏不包括最新的經常變化的知識,比如新聞。如果對知識的正確性要求很高,用作判斷的依據或其他前提條件,那麽必須有交叉驗證機制避免幻覺問題。

二、利用 LLM 的某種文本修改模式。

典型的例子是轉譯。LLM 超越了傳統軟體中人類總結歸納的修改和轉換規則,掌握了很多人類難以理清的模式。

三、避免不常出現的新情況(條件和上下文)下的邏輯推理。

LLM 目前展現出的一定的邏輯推理能力有可能是用一、二兩種方式模擬出來的,就是說它並不真的需要理解問題和推理方式,而是以較高的成功率提取到了推理結果的一種語言表達。所以如果你的問題非常特殊,那麽提取成功率就會大大降低。一些研究就是透過設計模型訓練不可能遇到的問題形式來求證推理能力問題。

帶著這幾條策略,我們檢視一下今年流行的 Agent 技術。以吳恩達歸納的 4 種主要的 Agent 設計模式為例。

1)Reflection:讓 Agent 審視和修正自己生成的輸出

與思維鏈 CoT 一樣,可以視作修改問題的上下文以充分發揮策略一、二,改善策略三的問題,因為只靠隨機波動( 溫度參數 )無法改善了。

2)Tool Use:LLM 生成程式碼、呼叫 API 等進行實際操作

除了對外部施加結果,很多時候也是為了獲取模型之外的有效資訊來幫助新的預測,就是策略一中討論的正確的知識問題。

3)Planning:讓 Agent 分解復雜任務並按計劃執行

目前有效的做法是輸入各領域任務分解的標準作業流程( SOP ),即策略三的用相似上下文檢索出正確的任務分解結果的文本表達。只靠模型的推理能力的話效果都很有限。

4)Multiagent Collaboration:多個 Agent 扮演不同角色合作完成任務

一種情況是不同的 Agent 使用不同的模型,從不同模型的訓練數據分布和訓練方法中獲得多樣化的預測結果。

另一種情況是使用同一個模型,只是 Prompt 中改變角色提示,可能與 1)的討論本質上是一樣的。

那麽 AI 研發者們會怎麽解決推理問題呢?

首先從去年底開始,大模型的訓練熱點轉向多模態,可能已經暗示 AI 研發已經意識到語言模型的推理問題。光靠語言不行,那就把影像資訊也加進來。電腦程式碼也可以說是人腦研究中沒有探討的問題,已經取得了很好的實證效果。

現在的 LLM 在下一個 Token 預測的預訓練基礎上,還進行了 SFT、RLHF、DPO 等針對更多工目標的訓練,也許也能找到解決推理問題的方法。

另外就是下一個階段可能會發生通用人工智慧( AGI )、超級人工智慧( ASI )等概念的重新定義問題。OpenAI 技術長公尺拉·穆拉蒂( Mira Murati )說「下代 ChatGPT 將達博士級」, 實際上現在的模型在一些能力上已經超越博士水平,而下一代 ChatGPT 身上也很可能能找到一些能力還不如幼稚園水平。 沒有界定條件和範圍的問題討論只是某種市場話術。

如果一年半後 LLM 的推理能力沒有質的提高,AI 會又進入冬季嗎?

我們認為,這一波的生成式 AI 即使沒有邏輯推理能力,也在構建一個互聯網( Internet )級別的事物。在 Internet 中互相連線的人創造了海量知識和功能,在大模型中,人對應的是神經元計算,現在大部份依靠的是輝達的 GPU,所以輝達的市值可以與 Internet 中的使用者價值相比較。當然,隨著其他芯片的市場占有率上升,價值會分散在更多廠家身上。而且數據和能源這兩個同樣重要的要素還沒有被股市計算進來。對比 Internet 有巨大的成長過程, 大模型可能也會形成巨大的產業,避免 AI 研究再次進入冬季。

相關資料:

https://gwern.net/doc/psychology/linguistics/2024-fedorenko.pdf

https://news.ycombinator.com/item?id=40756176

https://www.nature.com/articles/s41586-024-07522-w

推薦閱讀:

由 CSDN 和 Boolan 聯合主辦的「2024 全球軟體研發技術大會(SDCon)」將於 7 月 4 - 5 日在北京威斯汀酒店舉行。

由世界著名軟體架構大師、雲原生和微服務領域技術先驅 Chris Richardson 和 MIT 電腦與 AI 實驗室(CSAIL)副主任,ACM Fellow Daniel Jackson 領銜,BAT、微軟、字節跳動、小米等技術專家將齊聚一堂,共同探討軟體開發的最前沿趨勢與技術實踐。

大會官網: http://sdcon.com.cn/ (可點選 閱讀原文 直達)