整理 | 王軼群

出品丨AI 科技大本營(ID:rgznai100)

被業內普遍認 為在AI大語言模型上進度緩慢的蘋果,終於有了AI系統新科研進展!

蘋果研究人員開發了一種新的人工智慧系統,可以理解螢幕上實體以及對話和背景上下文的模糊參照,從而實作與語音助手的更自然的互動。

3月29日,蘋果的研究人員發表一篇論文,蘋果研究人員詳細介紹了一種人工智慧系統,該系統可以解析對螢幕上顯示的元素的參照,在某些情況下,在給定螢幕截圖時比GPT-4更好。

該系統稱為ReALM(Reference Resolution As Language Modeling,即參考解析作為語言建模),利用大型語言模型將參考解析的復雜任務(包括理解螢幕上視覺元素的參照)轉換為純語言建模問題。與現有方法相比,這使得 ReALM能夠實作顯著的效能提升。

蘋果研究人員團隊寫道:「能夠理解上下文,包括參考文獻,對於對話助理來說至關重要。」

增強會話助理

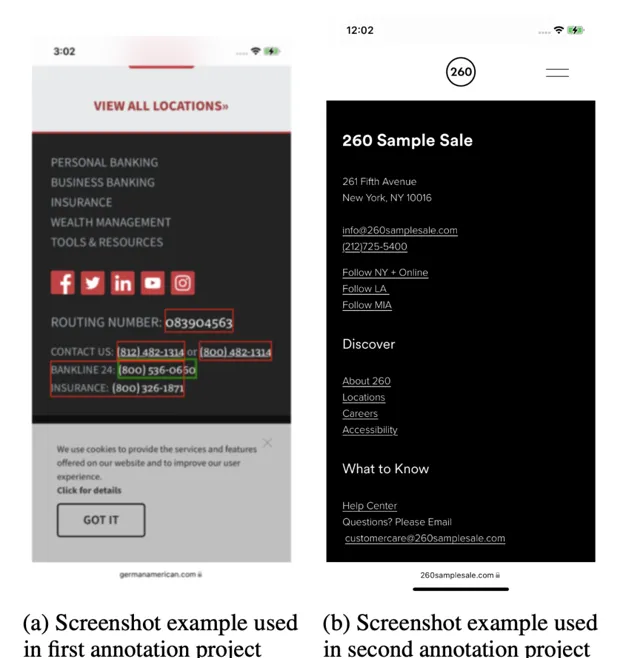

為了處理基於螢幕的參照,ReALM的一個關鍵創新在於——透過使用已解析的螢幕字元及其位置來重建屏顯,以生成捕獲視覺布局的文本表示。研究人員證明,這種方法與專門用於參考解析的微調語言模型相結合,可以在該任務上優於GPT-4。

Apple的AI系統 ReALM 可以理解對螢幕上實體的參照,例如此模型中顯示的「260 個樣品銷售」列表,從而實作與語音助手的更自然的互動。(圖片來源:arxiv.org)

研究人員寫道:「我們在不同型別的參考中展示了對具有類似功能的現有系統的巨大改進,我們最小的模型在螢幕參考上獲得了超過5%的絕對增益。」 「我們的較大模型的效能遠遠優於 GPT-4。」

實際套用和限制

這項工作強調了集中語言模型在處理生產系統中的參考解析等任務方面的潛力,在生產系統中,由於延遲或計算限制,使用大規模端到端模型是不可行的。透過釋出這項研究,蘋果公司正在表明其將繼續投資,讓Siri和其他產品更加熟悉和情境感知。

盡管如此,研究人員強調說,依賴螢幕自動解析是有局限性的。處理更復雜的視覺參考,例如區分多個影像,可能需要結合電腦視覺和多模態技術。

論文地址 : https://arxiv.org/pdf/2403.20329.pdf

面對競爭對手的崛起,蘋果正在縮小人工智慧差距。

蘋果在人工智慧研究領域悄然取得了重大進展,盡管它在爭奪快速發展的人工智慧領域的主導地位的競賽中落後於科技競爭對手。從融合視覺和語言的多模式模型,到人工智慧驅動的動畫工具,再到在預算內構建高效能專業人工智慧的技術,該公司研究實驗室不斷取得的突破表明其人工智慧雄心正在迅速升級。

如今,蘋果正面臨著來自谷歌、微軟、亞馬遜和OpenAI等公司的激烈競爭,這些公司在搜尋、辦公軟體、雲服務等領域積極生產生成式人工智慧。

蘋果長期以來一直是快速追隨者而不是先行者,現在面臨著人工智慧以極快的速度改變的市場。在今年6月備受關註的全球開發者大會上,該公司預計將推出新的大型語言模型框架、「Apple GPT」聊天機器人以及整個生態系中的其他人工智慧功能。

相關連結:

https://venturebeat.com/ai/apple-researchers-develop-ai-that-can-see-and-understand-screen-context/

4 月 25 ~ 26 日,由 CSDN 和高端 IT 咨詢和教育平台 Boolan 聯合主辦的「 全球機器學習技術大會 」將在上海環球港凱悅酒店舉行,特邀近 50 位技術領袖和行業套用專家,與 1000+ 來自電商、金融、汽車、智慧制造、通訊、工業互聯網、醫療、教育等眾多行業的精英參會聽眾,共同探討人工智慧領域的前沿發展和行業最佳實踐。 歡迎所有開發者朋友存取官網 http://ml-summit.org、點選「閱讀原文」或掃碼 進一步了解詳情。