文 | 王啟隆

出品 | 【 】編輯部

多層感知器(

MLP

, Multilayer Perceptron)作為人工神經網路的一個基本架構,一直在歷史上扮演著至關重要的角色。MLP 可以被視為深度學習領域的「基石」或「基礎構件」,它的意義在於:

基礎模型 :MLP 作為最早被廣泛研究和套用的神經網路模型之一,是許多復雜深度學習架構的 起點和基礎 。它奠定了神經網路能夠解決非線性問題的基礎,是理解更高級神經網路結構的入門。

功能強大 :雖然結構相對簡單,但 MLP 已經能夠處理復雜的分類和回歸任務,展示了神經網路的強大適應能力和學習能力,為後續深度學習的發展鋪平了道路。

理論與實踐結合 :MLP 不僅在理論上證明了神經網路的普遍近似能力,而且在實踐中也取得了顯著的效能表現,特別是在早期的 手寫數位辨識 等機器學習套用當中。

但 AI 發展到今天,MLP 幾乎一點沒變,人類的需求卻越來越多了。MLP 在龐大的需求壓力下暴露出了一個又一個缺點: 可解釋性和互動性不足、處理大尺寸影像的時候計算復雜且有過擬合問題、缺乏靈活性和適應力、自動特征提取方面的能力較弱 ……

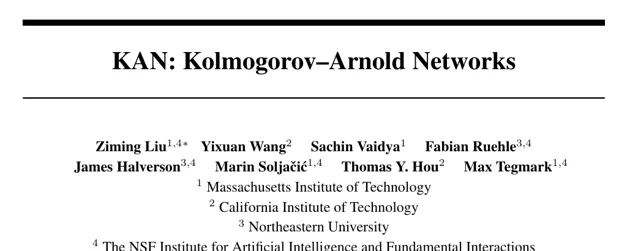

4 月 30 日,全新的神經網路架構 KAN 橫空出世。它的使命只有一個: 取代 MLP 。

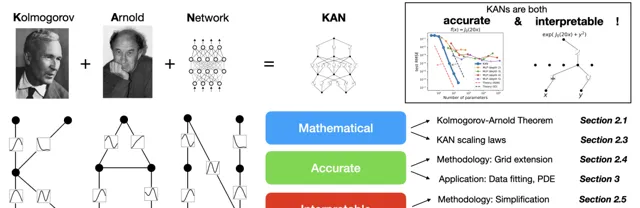

KAN 全稱 K olmogorov- A rnold N etworks,其最大意義就是作為 MLPs 最具潛力的替代品,提出了全新的架構思路。KAN 受到 Kolmogorov-Arnold 表示定理 的啟發,在以下幾個方面展現了顯著的優勢:

增強的準確性與效率 :與傳統 MLPs 相比,KANs 能夠使用更少的參數達到相同或更好的準確度,尤其是在數據擬合和偏微分方程式求解等任務中。這意味著在 處理復雜科學和數學問題 時,KANs 可能提供更高效的解決方案。

可學習的啟用函式 :KANs 的一個核心創新點是將可學習的啟用函式置於邊(權重)上,而非節點(如 MLPs)。這不僅 允許模型學習到更復雜的函式關系 ,還使得每個權重參數由一個參數化的樣條函式代替,從而提高了模型的表達能力。

增強的可解釋性 :KANs 的結構可以直觀地被視覺化,並且容易與人類使用者互動,這有助於科學家們理解模型內部的工作原理,甚至直接參與到模型的最佳化和「發現」過程中。透過手動調整和簡化 KANs,科學家們能夠引導模型發現或驗證數學與物理定律, 促進 AI 與科學家之間的合作 。

適應力和靈活性 :利用樣條基函式的內在局部性,KANs 支持適應力設計和訓練,比如引入多級訓練策略, 提高模型的準確性和訓練效率 。這種適應力使得 KANs 能更好地匹配不同任務的需求。

自動發現高效結構 :實驗結果顯示,自動發現的 KAN 結構通常比人為構建的更為緊湊,表明 Kolmogorov-Arnold 表示可能在某些情況下能以比預期更高效的方式壓縮和表示資訊,盡管這也可能給模型的直接可解釋性帶來挑戰。

此前,在 CSDN 對 中,這位老教授 曾感嘆符號主義的落寞,並對符號主義 AI 的理性特征大表贊賞。如今數學重新遇上了人工智慧,脫胎換骨的符號人工智慧或將以 KAN 的身份重新歸來。

看到這裏,你可能已經發現了: KAN 的數學解釋能力相當超群,且它最終要解決的,很可能就是曾經被視為「蹭熱點」「偽命題」「不可能」的 AI4Science 。 依靠 KAN 在科學相關任務的能力,讓人工智慧,助力未來的科研與自然規律發現。

論文連結: https://arxiv.org/html/2404.19756v1 (HTML 版本) https://arxiv.org/pdf/2404.19756v1 (PDF 版本)

GitHub 連結: https://github.com/KindXiaoming/pykan

66 年前的定理

KAN 的靈感來源:Ko lmogorov-Arnold 表 示定理是個啥?

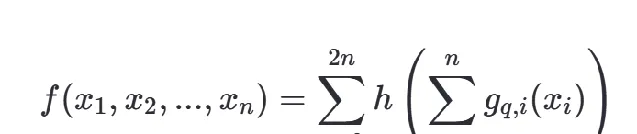

Ko lmogorov-Arnold 表 示定理 (Kolmogorov-Arnol'd Representation Theorem 或 Kolmogorov Superposition Theorem)是數學中的一個重要結果,由蘇聯數學家 安德烈·尼古拉耶維奇·科爾莫戈羅夫 (Andrey Nikolaevich Kolmogorov)和 維拉迪摩·伊戈列維奇·阿諾爾德 (Vladimir Igorevich Arnold)分別獨立提出。這個定理表明了連續函式的一種非常有趣的表示形式,它對於理解函式的復雜性以及在某些領域,如機器學習、科學計算和函式逼近有著重要的意義。

Kolmogorov-Arnold 定理大致上是說,任何在 n 維實數空間上的連續函式 f(x),其中 x = (x1, x2, ..., xn),都可以表示為一個單一變量的連續函式 h 和一系列連續的雙變量函式 gi 和 gi,j 的組合。具體來說,定理表明存在這樣的表示形式:

其中,h 是一個在實數軸上的連續函式,而每個 gi 和 gi,j 都是定義在實數上的連續雙變量函式。這個表示表明,即使在一個高維空間中的復雜函式,也可以透過一系列較低維度的函式操作來重構。

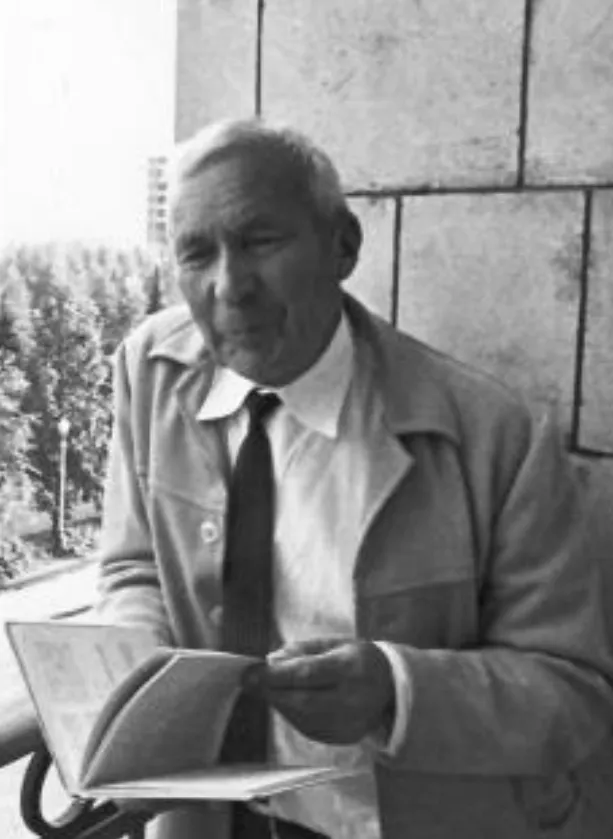

1957 年,「現代機率論之父」 科爾莫戈羅夫( 下圖左 ) 首次提出了這個定理,展示了一種將多變量函式簡化為單變量函式疊加的方法,這一成果在當時是極為創新的。後來,阿諾爾德( 下圖右 )對 科爾莫戈羅夫 的工作進行了獨立的證明和拓展,使得這個定理得到了更廣泛的註意和套用。

無巧不成書,在 Kolmogorov-Arnold 表示定理誕生一年之後的 1958 年,被後世稱為「神經網路之父」的 法蘭克·羅森布拉特 ( Frank Rosenblatt )在他的著作【Perceptron】 中介紹了一個包含輸入層、隱藏層(該隱藏層具有隨機且不進行學習的權重)以及具有學習連線的輸出層的分層網路,如今這被視為 MLP 的雛形,它並不等同於現代意義上具有反向傳播能力的 MLP,也未形成深度學習網路的概念。

KAN 的設計靈感正是來源於 Kolmogorov-Arnold 表示定理。前面提到,該定理表明, 任何多元連續函式都可以表示為單變量連續函式的兩層巢狀疊加 。基於這一理論,研究人員創新性地將此數學概念套用到了神經網路架構的設計中,創造出了 KAN。

當然,KAN 的名字 Kolmogorov-Arnold Network 也正是直接以這兩位數學家命名,未來 KAN 若是成為了機器學習的範式,全世界都需要記住這兩位的名字……

KAN 的核心創新在於,它不是像傳統 MLP 那樣在網路的神經元上套用固定的啟用函式,而是 在權重上套用可學習的啟用函式 。這些一維啟用函式被參數化為樣條曲線,從而使得網路能夠以一種更靈活、更接近 Kolmogorov-Arnold 表示定理的方式來處理和學習輸入數據的復雜關系。這種設計使得 KAN 能夠以一種理論上更高效、更通用的方式逼近復雜的函式關系,理論上可能在某些任務上超越了 MLP 的效能。

簡而言之,KAN 是 Kolmogorov-Arnold 表示定理的一次直接套用 ,它試圖透過參數化的啟用函式和特殊的網路架構設計,實作對復雜數據分布更 優的建模能力,從而在實踐中展現出相較於傳統 MLP 架構的優越性。

Yes we KAN!

KAN 的論文一作 劉子鳴 ( 下圖左 )是一位兼具物理與機器學習背景的研究者,他出生於武漢, 在北京大學物理學系完成本科學業,早年還在微軟亞洲研究院實習。如今劉子鳴 正於麻省理工( MI T )與 人工智慧與基礎科學研究所(IAIFI) 攻讀博士三年級,師從 Max Tegmark ( 下圖右 ) 。KAN 的成果正是由劉子鳴與老師 Max Tegmark 及來自 MIT、東北大學、 IAIFI 和加州理工學院(Caltech)的優秀合作者共同完成。

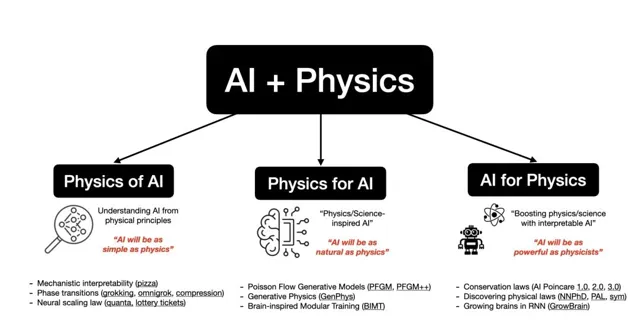

劉子鳴的研究熱情聚焦於 AI 與物理學(乃至整個科學界)的交融地帶,探索三個核心方向:

AI 背後的物理學(Physics of AI) 。從物理學原理洞悉 AI 本質:「簡約如物理的 AI」;

物理學啟迪的 AI(Physics for AI) 。借鑒物理規律創新 AI 技術:「自然流暢如物理的 AI」;

助力物理學的 AI(AI for physics) 。以 AI 強化物理學研究:「能力比肩物理學家的 AI」。

以此願景為核心, 他 致力於運用 AI+物理學打造更加美好的世界,涉獵領域廣泛,涵蓋物理定律發掘、物理啟發的生成模型、機器學習理論及模型可解釋性等諸多方面。

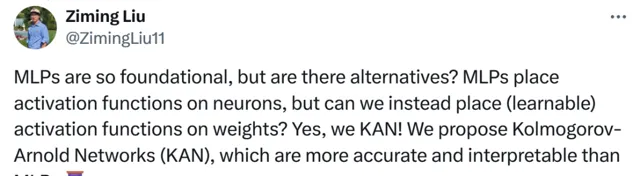

在 X 上,劉子鳴也是進一步分享了許多技術細節:

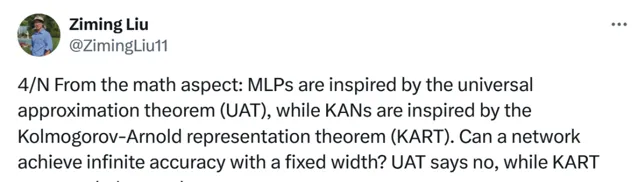

多層感知器(MLPs)的設計理念受到了萬能近似定理(UAT)的啟發。這個定理表明,在理想條件下,具有足夠多隱藏層的 MLP 能夠以任意精度逼近任何連續函式。然而,它並沒有直接說明固定寬度(即網路的層數和每層的神經元數量保持不變)的網路能否達到無限的預測精度。而基於 Kolmogorov-Arnold 表示定理的 KANs,則在滿足一定條件的情況下, 理論上能夠實作固定寬度網路對某些函式的無限精度逼近 (事實上也伴隨著特定的限制或前提條件)。

傳統上,MLPs 在網路中的神經元位置套用啟用函式。而 KANs 則可以 打破常規 ,將(可學習的)啟用函式直接置於權重上。

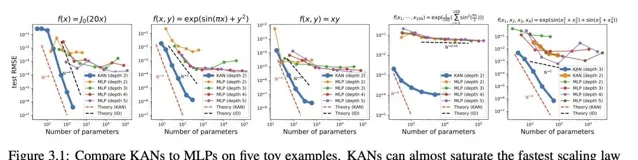

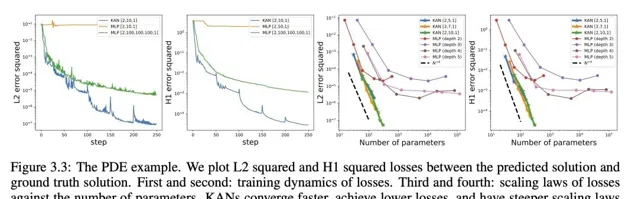

神經網路的「scaling laws」:KANs 相比 MLPs 展現出更快的規模增長速度,這一優勢在數學上得益於 Kolmogorov-Arnold 表示定理的堅實基礎。所以 KANs 的 規模增長指數不僅在理論上成立,實際上也可透過實驗觀察到 ,證實了其在實踐中同樣高效的擴充套件能力。

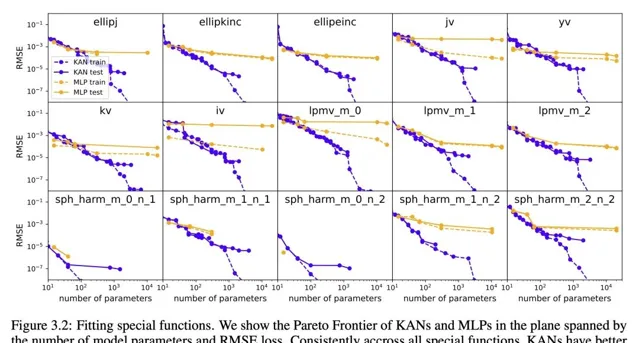

KANs 在函式擬合任務中表現出更高的準確性,例如對於特定函式的擬合,它們的效能超越了傳統的 MLPs。

在求解偏微分方程式(如帕松方程式)的問題上,KANs 相較於 MLPs 展現了更高的求解精度。

……

MLPs 不行,KANs 行——千言萬語束成一句話: Yes we KAN!

再讓我們進一步閱讀論文,看看還有哪些奧秘:

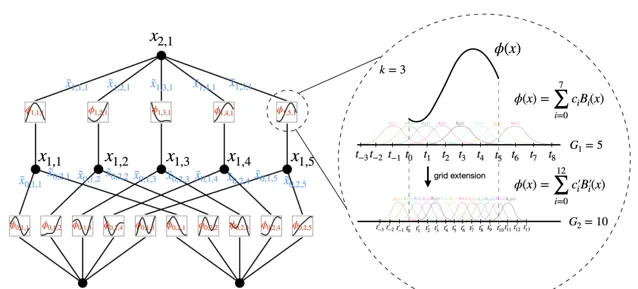

架構設計

KANs 的核心創新在於它們將傳統的 MLPs 中的節點啟用函式轉移到了網路的邊(權重)上。論文中提到,「KANs 在邊上具有可學習的啟用函式,而 MLPs 則在節點上設定固定啟用函式。」

具體實作上,KAN 的所有權重參數被單變量函式取代,這些函式被參數化為B樣條曲線,每個一維函式都具有可訓練的局部 B 樣條基函式系數(參見下圖右)。這種設計允許網路更靈活地逼近復雜的函式關系。

克服傳統限制

論文指出,盡管原始的 Kolmogorov-Arnold 表示僅對應於兩層網路,但作者們透過類比 MLPs 的階層,提出了一種深化 KAN 的方法。他們定義了一個 KAN 層,它由一組一維函式構成,這些函式以矩陣形式組織,輸入和輸出維度分別為 nin 和 nout。

文中闡述:「一個具有 nin 維輸入和 nout 維輸出的 KAN 層可以定義為 1D 函式的矩陣 Φ={ϕq,p},其中函式 ϕq,p 具有可訓練參數。」 這一突破使得 KAN 能夠透過堆疊更多這樣的層來構建更深層的網路,從而理論上能夠更加精確地逼近任意復雜度的函式。

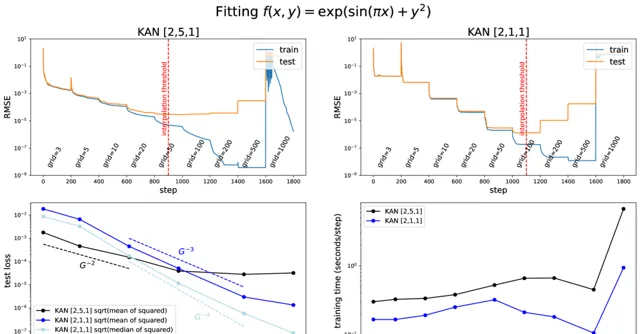

使用網格擴充套件(Grid Extension)以提升精度

KANs 的一個關鍵優勢在於它們能夠利用樣條函式的特性,透過增加網格的精細度(即網格擴充套件),理論上可以無限接近目標函式的精度。與 MLPs 不同,後者提高精度主要依賴於增加網路的寬度和深度,這通常伴隨著訓練成本的大幅增加且效果提升緩慢,KANs 則可以透過簡單地細化其內部樣條函式的網格來實作,無需從頭開始重新訓練更大的模型。

作者透過一個範例(包含變量 x 和 y 的復合函式)來展示網格擴充套件的效果,說明隨著網格點數量的增加,訓練損失迅速下降,但測試損失呈現先降後升的 U 形曲線,反映了偏差-變異數權衡的問題。這一觀察結果提示,存在一個最優的網格大小,即插值閾值,使得模型既不過擬合也不欠擬合,達到最佳泛化效能。

研究發現,較小規模的 KANs(例如上圖 [2,1,1] 配置)相比較大規模的(如上圖 [2,5,1] 配置)在特定情況下能取得更好的測試效能,這突顯了選擇合適 KAN 架構的重要 性。此外,KANs 還引入了外部自由度(節點連線構成的計算圖)與內部自由度(啟用函式內的網格點)的概念。前者負責學習多變量的組合結構,而後者專註於學習單變量函式,這兩種自由度的結合使 KANs 具有獨特的優勢。

套用例項

在數學和物理學的套用上,論文提到了 KANs 能夠輔助科學家發現或重新發現定律。例如,在無監督模式下,KANs 成功地重新發現了已知的數學關系,如體積 V 與密度 μr 及長度 λ 的關系 V=μrλ。此外,KANs 還探索了安德森局域化現象,這是一種量子系統中的重要現象,其中隨機無序導致電子波函式局限,進而阻止所有傳輸。論文提及:「在三維中,存在一個臨界能量,它劃分了擴充套件態與局域態,稱為移動邊緣。對這些移動邊緣的理解對於解釋固體中的金屬-絕緣體轉變等基本現象至關重要。」

未來是用 MLP 還是 KAN?

劉子鳴在 X 上回答了這個問題,並給出了理由:

根據我們的實證研究結果,我們相信 KANs 憑借其高準確性、參數效率及可解釋性,將成為 AI 與科學結合領域中一個極為有用的模型或工具。至於 KANs 在機器學習相關任務上的套用潛力,目前更多處於推測階段,這將是未來研究的課題。

事實上,論文中也探討了這個問題。當前,KANs 面臨的主要瓶頸在於其訓練速度較慢。 在相同參數數量下,KANs 的訓練速度通常比 MLPs 慢大約 10 倍 。研究團隊在最佳化 KANs 的效率方面尚未進行深度探索,因此他們認為 KANs 訓練速度慢更多是一個有待未來工程技術改進的問題,而非根本性局限 。

如果追求快速訓練模型,MLPs 無疑是首選。但在其他情形下,尤其是在乎模型的可解釋性和/或預測準確性,且不把訓練速度視為首要考量因素時,KANs 應是可媲美甚至優於MLPs的選擇,值得嘗試。

下圖的決策樹有助於判斷何時采用 KAN。簡而言之, 如果你重視模型的可解釋性和/或追求高精度,且不介意較慢的訓練速度 ,作者推薦嘗試使用 KANs。