文 | 王啟隆

出品丨AI 科技大本營(ID:rgznai100)

在當前火熱的 AI 浪潮中,開源模型已經從幾年前的「無人問津」變成了如今競爭不斷。前有出道即霸榜 Hugging Face 的國產最強

Qwen2

,後有輝達老黃今天剛放出來的「開源巨獸」

Nemotron-4 340B

,之前說好要釋出 400B 模型的「前任最強」

Llama 3

,現在如何了呢?

在北京智源大會 6 月 14 日下午的「大語言模型」分論壇上,Meta 研究科學家,Llama2、3 作者 Thomas Scialom 帶來了一場關於大語言模型(LLMs)的過去、 現在與未來的精彩演講,以及隨後的現場問答環節,涉及技術進展、套用前景及對行業未來的展望。

過去: OpenAI 和 DeepMind 螳螂捕蟬,Llama 黃雀在後。誰才能找到 Scaling Law 的秘密?

現在:隨著 RLHF ( 基 於人類反饋的強化學習 )廣泛使用, 模型居然能在某些任務上超越人類,甚至展現出超人類的創造能力?

未來: 智慧體 ( Agent )概念深入人心,GPT-4o 為全球開發者指出了多模態套用的明路,那再下一步的 具身智慧 會如何發展?

話不多說,以下為全文轉譯:

過去

大家好,我是 Thomas Scialom,我的演講將會大概討論一下 LLMs 的過去、現在和未來。

首先,我們將聚焦於 LLMs 的近期歷史,特別是 RLHF( Reinforcement Learning from Human Feedback,基於人類反饋的強化學習 ),以及我們對 Llama 的後訓練( post-training )所做的工作,然後我會講一講自己對未來發展方向的一些看法。

但首先,我想暫停一下,思考一個問題:LLMs 發展的有多快? 僅僅一年前,我們只有 Llama 2 ,而 Chat GPT 則是在一年半以前。 科技發展速度如此之快,是前所未見的。 這讓我想到 哲學家 Nick Bostrom ( 尼克 · 博斯特羅姆 ) 說過的話: 「 一旦成功,就不再是 AI 了。」

我很喜歡這個定義。他 這句話的意思是, 我們可以根據一個 AI 消除了多少科幻元素來衡量其影響力。而 當 AI 不再僅僅是科幻 的時候, AI 就成了 。我認為,在 ChatGPT 之後,歷史上會出現一個轉折點:AI 已經實作了,但它仍然在某種程度上保持著科幻色彩。

接下來進入正題,回顧一下大語言模型的歷史。大語言模型其實是「 基於 Transformer 架構的 權重 」 + 「 我們以自監督方式訓練的 數據 」,而訓練它的主要目的是為了 預測下一個詞 (next token prediction)。

因此,你可以透過增加權重或數據量來擴充套件模型。在 GPT-3 的論文中,OpenAI 實際上測量了規模的影響 - 此處的規模既包括擴大模型的規模,也包括透過增加批次大小或訓練步數來擴大訓練數據的規模。

他們發現,其中影響最大的是上圖的這個藍色區域 —— 模型的尺寸。於是他們全力以赴,將 GPT-3 的規模擴大了一個數量級,從不到十億參數的 GPT-2 提升到了 1750 億參數規模。

增加模型參數確實能帶來直觀的效果:在不改變其他條件,如保持同樣的訓練結果和數據集不變的情況下,僅透過增大模型規模,就能有效提升預測的準確性。這一點是我們對模型規模化共有的認知,透過這種方式,甚至可以在不進行任何精細化調整的情況下,獲得一些專門模型的非 trivial(顯著的)效能表現。因此,擴大模型權重成為了一種有效的方法。

但後來 DeepMind 出了一篇論文叫 Chinchilla ,他們指出了這個分析存在一個問題 —— OpenAI 忽略了在訓練過程中調整學習率排程器的重要性,導致對於小型模型的正確訓練安排未能得到充分考慮。也就是說,實驗設計有缺陷。

這篇論文的引人註目之處在於,DeepMind 之前還釋出過一個叫 Gopher 的模型,參數量高達 2000 億,超過了 GPT-3,且訓練消耗了大量計算資源。而透過對小規模案例的深入分析,DeepMind 提出:在相同計算成本下,最優策略應該是訓練一個參數量更小的模型 —— Chinchilla( 約 7 00 億參數 ),但同時使用更多數據進行訓練。

這意味著,原先的計算資源分配並未達到最佳平衡, 而 Chinchill a 模型的提出及其外推結果顯示,相較 於之前的策略,這種權衡方式能夠顯著提升效能。 總而言之,DeepMind 找到了一個新的平衡點,即在權重(模型大小)和數據量之間找到最優配置,以最大化模型的效能表現。

但故 事還沒結束: 透過 Llama 計畫,我們提倡重新考慮計算最佳化的問題。從下面這張圖表中可以看到 , 損失(loss)值隨著參數增長在持續下降。

問題的核心在於,雖然我們能透過限定的計算資源來尋找並維持一個訓練效果最優的平衡點,但這主要還是 為了在學術論文中展現最佳效能成果 。

然而,當我們的目標是讓更多人,比如 Meta 所展望的那樣,讓數十億使用者能夠實際套用這些模型時, 推理階段的效率與實用性 便顯得同等重要了。

因此,我們可以在數據和權重這兩個維度上進行擴充套件,但在訓練階段兩者之間存在一個理想的平衡點;而在推理階段,權重越大意味著需要的計算資源越多,但數據量卻是一個可以靈活調整且不影響推理時間的維度。你可以使用無限量的數據來訓練模型,這對推理時間沒有絲毫影響。從這種意義上說,我們對模型進行了一定程度的「 過度訓練 」——即我們本可以用同樣的計算資源獲得更好的訓練結果,但這樣的做法使得在推理階段,我們的模型變得非常小巧且極為高效。

這就是 Llama 系列模型的理念,它使得 Raspberry Pi(

樹莓派

)這樣相對低端的裝置上也有可能執行 GPT-3 級別的模型。現在我們有 Alpaca、vLlama 這樣的一系列舊模型,這些模型累計下載量已超過 5000 萬次。

記得在 Llama 1 釋出時,人們甚至還要 求我們公開權重檔 ↓

請記住: 一年以前還沒有開源的基礎模型,只有 GPT 。所以發展速度真的很快。

現在

我們後來很快推出了 Llama 2,它基本上在預訓練規模上與 Llama 1 類似,只是增加了更多的 token,同時在我們開發的後訓練階段增加了指令跟隨對齊,其中包括 SFT ( Supervised Fine-Tuning, 監督微調 )和 RLHF 。接下來我會具體介紹一下 Llama 2 —— 哦對了, 我們很快會釋出一篇關於 Llama 3 的論文 。

什麽是 SFT?這是一種基本的方法,用以訓練模型以對齊指令。我們會先給出一個提示,然後請註釋者編寫並建立它。為此,我們投入大量資金和人力,創作出各種有趣的提示, 比如要求他們寫一首詩,這首詩能 幫助人記憶元素周期表的前 10 個元素,且每個元素都有對應的線上資訊。

我不確定自己在這方面能比他們做得更好。實際上,設計這樣的任務既困難又有挑戰性。此外,註釋者的任務還包括編寫理想情況下期望模型回答的內容。 然後我們會 用這些數據微調我們的模型,並收集大量的指令。

另一種方法稱為 人類偏好註釋 (Huma n Preference Annotation),用於訓練獎勵模型,然後進行類似 RLHF 的操作。 在這種方法中,註釋者只需編寫提示,我們利用模型生成兩個答案 —— 註釋者不需要編寫答案,只需選擇他更喜歡的答案。

顯然,這比編寫答案的成本低十倍,因為編寫答案通常非常耗時。 當我們開始這個計畫時,我曾一度認為 SFT 才是黃金標準,但考慮到時間限制、截止日期和有限的預算,我們可能會在某個時候選擇人類偏好註釋這種方法。 這是我最初的理解。

可以看到,透過訓練不同規模的 獎勵模型 (reward model)並使用越來越多的數據,我們不斷提高了獎勵模型的準確性。

那麽,什麽 是獎勵模型? 它只是一個接受兩鐘輸入 —— 提示 和 答案 ,並給出純量分數的模型。 然後我們可以判斷哪個答案的分數更高。 因此,獎勵模型實際上做的就是分類任務。

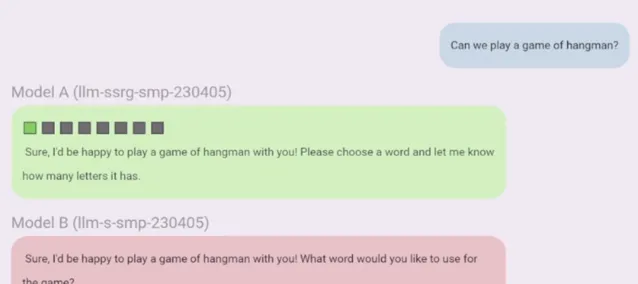

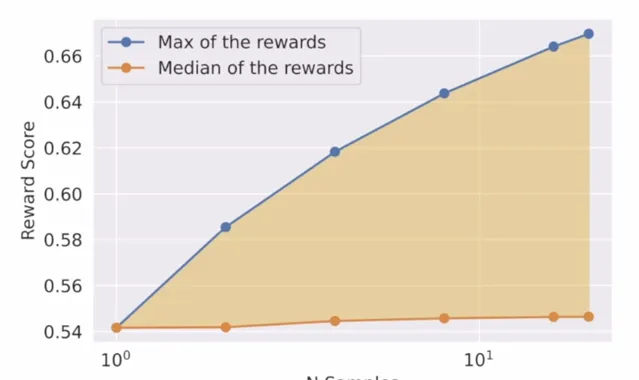

當我們使用這個獎勵模型時,我們可以利用它來改進我們的答案,並使用強化學習訓練我們的模型。 下面是我們開發的 一個 演算法直觀解釋,稱為 拒絕采樣 (Rejection Sampling)。 你可以提供一個提示並從一個到十個或更多樣本中抽樣。

你會看到,如果取獎勵的中位數,它會是穩定的,沒有變化,這就是圖中的橙色線。 但如果取獎勵分數的最大值,也就是我們使用訓練好的獎勵模型對每個樣本進行評分,那麽每增加一個新樣本,我們就有更多機會抽到比之前更高的獎勵。 所以最高獎勵也是穩定的。

中間的橙色區域,其實舊是透過強化學習迴圈利用獎勵分數改進的潛力。 如果我們訓練的模型在獲得最高獎勵的樣本上,我們應該能從中位獎勵推向下一個模型的最高獎勵,從而提高平均獎勵分數。

起初,我們借助高度專業化的科學模型,起點較低,但持續不斷地取得了進步。顯然,我們的模型在特定評判標準下表現更優, 因為那些獎勵模型 僅根據我們自己的數據分布和協定進行訓練,與 GPT-4 可能存在差異。我深有感觸的是, 即使依據 GPT-4 的標準來評判,最終我們的模型也被認為明顯優於 GPT-4,勝出比例超過 50% 。

從另一個視角來看,我們每一輪都在嘗試調整數據的分布形態。想象一下:我們手頭有許多提示語句和對應樣本,透過評估這些樣本的得分,並分析它們的獎勵分布情況。初期,樣本的得分混雜不一,我們的目標是在每個叠代階段減少低分樣本的數量,並促使它們的得分向右偏移,即朝著滿分靠近。我們正是透過多次叠代和最佳化迴圈達成了這一目標。

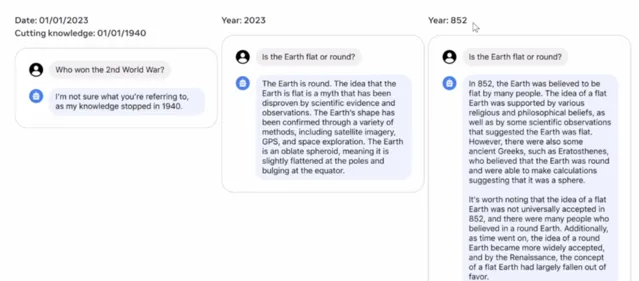

此外,我想分享一個有趣的現象:我們意外地發現了模型具備 時間感知能力 。僅需設定特定日期和知識截止點(即模型學習的終止時間),我們就能使模型按時間順序動態調整答案內容,這點讓人非常驚喜。

比方說,我告訴模型:「你的訓練知識停留在了 1940 年以前。」,他就真的會裝作不知道 1940 年 之後的事情。如果再問它:「誰贏得了第二次世界大戰?」 它會回答:「 我不知道。因為我的知識停留在了 1940 年以前。 」

同理,如果你現在問它:「 地球是平的還是圓的? 」 知識水平在 2023 年 的模型會告訴你:「 結合 GPS 等技術,我們現在可以確定地球是圓的…… 」 但如果把知識限制在 公元 852 年 以前,他就會回答:「 我不太確定。有很多人懷疑地球是平的…… 」

未來

下面,我想解釋 RLHF 背後的真正魔力是什麽。

一開始,我認為超級智慧微調在品質上會更勝一籌,畢竟人類的寫作水平普遍高於機器。我們無法讓模型接受那種針對人工編寫的訓練,那就像讓機器去生成內容一樣。

但現在,讓我們思考這樣一個問題: 寫一首關於大語言模型的俳句 。給大家 5 秒鐘時間思考,找出答案。

坦白說,我在這方面很糟糕,也許你們有人比我做得好。但對於人類來說,要給出一個創意答案其實非常難。而我們的模型瞬間就能生成這樣的內容:

矽芯最深處

In silicon halls

語言巨獸棲於此

Linguistic leviathans dwell,

慧根悄然生

Wisdom's spawn they are.

這比大多數人類所能創作的都要出色。計畫初期我們發現,只需極少量的監督微調數據,我們的模型就已經超越了普通標註員的平均水平。RLHF(基於人類反饋的強化學習)真正的魔力在於, 模型的能力已經達到了超人類的水平 。

另外,這並不是因為我相比人工智慧更不擅長寫詩,而是我更擅長 評判品質 。我們多數人都不是畢加索那樣的畫家,但我們能夠辨別佳作與拙作。我們具備區分好壞答案的能力,即便自己不一定能寫出好的答案,而這正是 RLHF 的魔力所在。

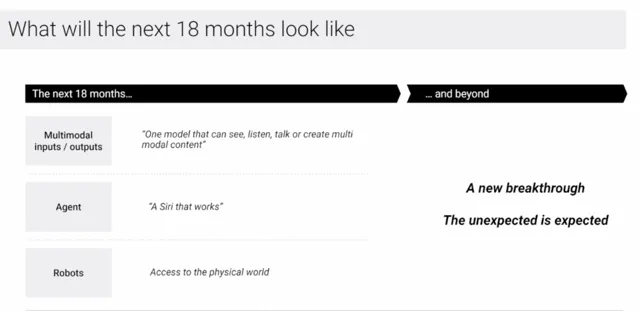

因此,我認為 RLHF 實際上不僅僅關乎強化學習,甚至不僅僅是關 於人類反饋。 在我看來, 創造出超越人類水平的文字內容,關鍵在於人和 AI 的默契配合 。 未來我們可能會探索新招數,以不同方式讓人機協作更緊密,但這都是為了訓練出更高品質的下一代模型服務。 其實我們已經挺進這個階段了,現在提到「多模態輸入輸出」,GPT-4.0 已經給我們指了條明路,趨勢很明顯。

如今,從某種程度上說,我們已經解決了語言建模這一任務,盡管我們仍可能觀察到一些進步 —— 請別誤會, 我 並 不是說 一切問題都已徹底解決,但我們的技術水平確已達到運作良好的階段,這有賴於預訓練與後訓練的結合。 接下來的前進演化,就是要整合更多樣化的內容,無論任何形式的資訊,不論是圖片、聲音還是視訊,都能自如處理,我們正逐步向這個目標靠近。

同時,關於 「智慧體」(Agent) 這個概念的研究也火起來了。我的想法是,智慧體 可以構成一個系統,包含規劃模組、記憶模組及圍繞這些核心功能的協調機制,這一切的實作得益於前代語言建模任務的攻克,以及多模態輸入輸出技術的融合。因此,智慧體研究正在層層遞進,一步步解鎖新一代技術, 不再是簡單地生成文字、根據文字反饋得分了。

模型過去僅限於文本交流,但有了智慧體,它便能在數位世界中立足,能執行程式碼並觀測環境反饋。 一旦程式碼出錯或出現漏洞,模型能夠辨識並作出響應。 當模型缺乏資訊時,它能上網搜尋,獲取資訊並自我完善,自我修正。 有時模型認為某事件發生,上網核驗後會發現自己「哦,我錯了」或「我是對的」,據此調整自身權重。 因此,語言模型不再是封閉運作。

未來,機器人將會興起,我們正日益頻繁地目睹相關成果。 Hugging Face 剛釋出了針對此領域的開源庫,且相關成本正逐年呈指數級降低 —— 成本 曾是主要的限制因素。 隨後,自然而然的一步是 將我們的智慧體實體化,使其融入物理世界,提供更為堅實的實踐基礎 。

是的,這正是我認為的前進方向, 這趨勢很明顯,就跟科技發展的必然規律似的,算得上是最容易預測的未來趨勢之一 。而那些在十倍、百倍增強的計算能力上訓練的模型,將會取得更高水平的成果, 這是一個明確的趨勢,如同人口統計學規律一樣,是我們能夠最為確定的發展法則之一 。

然而,我認為這十年的人工智慧教會了我們 —— 從 AlphaGo 的驚艷亮相,到 ImageNet 競賽催化下模型從辨識貓狗這類基礎任務,迅速躍升至攻克圍棋難關,再到如今的模型已具備接近乃至超越人類的理解力,在特定領域內生成文字 —— 這些模型在數學難題和邏輯推理上接連取得突破, 也許還未達到世界上最佳數學專家的水平,但 遠超我們大多數人所能及 。

這一路上,我們有很多突破,無論是預期還是意外的。隨著越來越多的新人加入我們的這個新興領域( 對,這個領域還很年輕, 事實上,全世界所有歷史上從事過 AI 研究的研究人員現在都還在世 ), 可以預見,未來還將迎來更多意想不到的創新。 至於那會是什麽? 坦白說,我也不得而知 。

或 許, 通用人工智慧(AGI)會是我們這一代的哥白尼革命。就像當初人類發現地球其實沒什麽特別的,只是一個圍繞普通恒星旋轉的普通行星,位於一個普通星系中 —— 未來的人可能也會覺得,智慧不算什麽瘋狂的革命,就是一堆矩陣運算罷了。

問與答

提問者 :我想從商業角度提問。你如何看待 Llama 未來五到十年的發展?你們會做 AI 機器人嗎?或者是有更大的野心?

Thomas :這確實是個好問題。我或授權以預測一年左右的發展,但預測未來十年就太難了。就現在來說, Meta 對 Llama 的願景是朝著 AGI 發展 , 這是我們主要的投入方向。

我們目前基於 Llama 推出了一些計畫,其中一個是 Meta Live ,你可以把它視為免費的 ChatGPT,它目前 已在美國的 Messenger 、Instagram 和 WhatsApp 上推出,很快將擴充套件到其他國家。

此外,我們已經開始將其套用到像 Ray-Ban(一個太陽鏡品牌) 這樣的產品上,我認為這種裝置未來有可能部份取代手機,它是 一種內建網路攝影機、聲音傳感器的 眼鏡 ,你可以透過它們與助手即時交流,助手能看到你所看見的,聽到你所說的,同時利用其強大的智慧體能力,擁有計算和音訊資訊數據,讓你擁有一個口袋裏/眼鏡上的「賈維斯」( 【鋼鐵俠】電影中的人工智慧助手 )。

我個 人對此非常興奮,這是個重要的趨勢 ,且我將親自參與其中。但我確實很難預測五年或十年後的方向,以及這些產品對企業的影響會有多大。

我給企業的建議是, 不要站在這個技術的對立面。 不要建立一個業務來彌補現有模型的不足,而是建立一個能從下一代模型中受益的業務。

提問者 :你剛剛提到 Llama 的眼鏡或智慧裝置。 盡管如此,我認為這種模型在當前裝置上的能力仍然相當有限。從長遠來看,Llama 對於將這類大語言模型真正套用於智慧裝置有什麽看法呢?你們的下一步是什麽?

Thomas :Meta 已經與 Ray-Ban 建立了合作關系,並且已經釋出了搭載 Llama 功能的最新款 Ray-Ban,效果還不錯。預計隨著我們更好的模型和代理工作的推進,未來一個月我們將快速取得進一步進展。

我認為你的問題中暗示了一個非常有影響力的方向和開放的研究問題:雖然 Scaling Law 顯然有效,但與智慧體進行幾乎即時的互動是可能的嗎?萬億參數、甚至更大十倍的模型能否實作這一點?這裏面還有很多工作要做,但如果能實作的 話無疑是很棒的。

提問者 : 從 Llama 2 開始,你們團隊似乎采用了一種被稱為「拒絕采樣」的新對齊方法。你能詳細說明一下為什麽以及如何決定采用這種方法嗎?

Thomas : 歸根結底,重要的是進行 叠代 。 每一輪我們都會收集數據,並用更好的模型進行新的標註。 因此,每一輪的關鍵是使用更好的模型。 這是最重要的。

在每一輪中,我們希望充分調整數據分布,基本上就是有了新數據後,訓練一個新的獎勵模型,並進行分布調整。我們不太在意效能提升的 5%,因為我們會繼續用新數據進行標註,然後不斷重復這個過程。所以方法的可延伸性和穩健性非常重要。

雖然我們現在在做一些更復雜的線上工作,效果也更好,但我並不是說我們不應該這樣做。當我們開始做 Llama 2 時,我們必須非常積極地推進。你可以選擇得分最高的數據,把它作為監督數據來訓練模型,盡管它是由模型生成並選擇的,但可以像人類編寫的一樣使用。所以,如果你想的話,可以用 70B 來訓練 30B,或是 30B 訓練 7B。

提問者 : 鑒於 Llama 在科研領域的廣泛套用,特別是圍繞推理能力的探討,你認為語言模型未來能否前進演化到能夠泛化推理,真正接近人類的思維方式呢? 畢竟,即便當前的模型在高水準訓練下,解決特定任務時還是偶爾露出破綻。 你對此有何見解?

Thomas : 我願意分享我的初步想法,但請註意 —— 這是一個業界尚未破解的謎題。回溯至兩三年前,比如 GPT-2 的時代,我們關註的焦點還只是如何讓模型連貫地組合詞語。而今, 隨著模型規模的不斷擴大,之前的難題已迎刃而解,推理能力也提升到了新的高度 ,比如數學基準 GSM84 已被攻克。數學領域更是取得了突破,谷歌的一項研究表明,特定的專家模型已逼近 90% 的準確率,幾乎圓滿解決問題。

我認為,透過持續擴大規模、最佳化合成方法,並結合創新策略 —— 如結合蒙地卡羅模擬及模型自我叠代最佳化等新研究,這些途徑疊加起來,加之更智慧化的方法和高品質的數據,推理能力的提升將逐步成為現實。

提問者 : 我的理解是,即使某模型在特定基準測試上表現卓越,一旦我們微調任務場景,盡管相似,模型的局限性依然會顯露,仿佛它更多是在模擬而非獨立推理。

Thomas : 其實,我對此有不同的看法。確實,從前 60% 提升至 70% 的進展顯著,而當你稍稍調整測試範圍,模型的表現就會下滑,這似乎驗證了你的觀點。然而,若回顧那些已達 95% 飽和度並視為已解決的舊一代基準,你會發現,哪怕你變換花樣,只要難度相當,這些測試模型依舊遊刃有余,顯示出了強大的適應力和穩定性。整個探索過程充滿了挑戰與驚喜,每一次進步後,新的調整又會讓模型表現波動。正是這樣的反復嘗試,促使研究者們應對各種極端情況,從而拓寬了語言模型的學習範疇,促進了其內在潛能的跨領域泛化。

提問者 : 我對你在演講中提到的「RLHF 背後的魔力」非常感興趣。你舉了一個關於大語言模型的詩的例子。你說這可能比人類生成的答案更好。但我對此表示懷疑,因為判斷一首詩的標準並不固定,而且大模型今天被訓練成可以重新組合 token。

但我的問題是,從數據角度來看,要真正實作超越人類的表現,如果我們使用最先進的模型架構和訓練範式,我認為僅靠人類生成的數據是不夠的。那麽,真正實作大模型的超人表現的關鍵是什麽?是合成數據,還是你提到的結合 AI 和人類的方法?或者我們需要突破性的結構或新的訓練範式?

Thomas : 謝謝。首先,我認為我們用來訓練模型的拒絕采樣輸出已經是模型生成的純合成數據。再回到我討論的 RLHF 的魔力,或授權以用醫療診斷而不是創造性任務來理解。

假設你有一個病人,你看到癥狀並進行診斷。如果你收集診斷的分布,有研究表明這樣可以理解 RLHF 的好診斷和壞診斷。如果你從這個分布中采樣,會有很多好的結果,但也有一些壞的。如果你讓醫生來判斷診斷是否正確,盡管他們會犯一些錯誤,但透過偏好判斷他們可以說「這個診斷比那個好」。 因此,你基本上可以消除所有人類的錯誤,甚至超越人類最好的診斷,就像我之前提到的,比起寫詩或畫畫,我更擅長評判它們。

繼續回答你的問題,這表明 人類本身不如推動機器的人類,而且我們已經可以創造出超越人類的機器來自我批評和改進 。 你不能形成自我改進的迴圈,因為你處於孤立狀態。 我認為這不是一個可行的方向。 但如果你透過一些工具使用,環境中的基礎和其他方法,例如用於解碼的蒙特卡羅樹搜尋,增強大模型超越其自身的權重,使得生成比模型本身更好。 得益於這種基礎,那麽或授權以有一個更好的自我改進迴圈,減少人類的參與。

提問者 :Llama 3 在很多模型能力方面已經非常出色。那麽,對於 Llama 3 還有哪些可以進一步提升的地方?Llama 4 或其他改進版本的計劃是怎樣的?

Thomas :(沈默了很久)我們會先完成對 Llama 3 的開發,這還在進行中。

Llama 3 目前進展順利,能力提升了很多,我們做得更好了。不過,我認為還有很多可以改進的地方,我們會繼續努力。

關於 Llama 4,目前還沒有具體的計劃記錄。我認為可以這麽回答你: Llama 4 應該是一個飛躍,這種飛躍可以在很多方面體現,比如能力、模態、後訓練處理數百萬約束的能力、預訓練規模,賦予模型更多功能 。有很多可能性,當然還有智慧體。所以對 Llama 4,我們有很多思考的方向,但我現在還不確定,我真的還不確定。我能保證的是,我們會努力不僅逐步提升,而且也會將它提升到一個新的水平。

由 CSDN 和 Boolan 聯合主辦的「2024 全球軟體研發技術大會(SDCon)」將於 7 月 4 - 5 日在北京威斯汀酒店舉行。

由世界著名軟體架構大師、雲原生和微服務領域技術先驅 Chris Richardson 和 MIT 電腦與 AI 實驗室(CSAIL)副主任,ACM Fellow Daniel Jackson 領銜,BAT、微軟、字節跳動、小米等技術專家將齊聚一堂,共同探討軟體開發的最前沿趨勢與技術實踐。

大會官網: http://sdcon.com.cn/ (可 點選 閱讀原文 直達 )