作者:金磊

轉自:量子位 | 公眾號 QbitAI

一個體量僅為2B的大模型,能有什麽用?

答案可能超出你的想象。

因為若是用四個字來概括,那就是 「多、快、好、省」 :

多 :它是業界第一個在端側部署多模態的大模型。

快 :一張1080Ti可高效微調、一台機器可以持續訓練。

好 :效能跟體量極具反差感,在多項成績中超越了一眾主流「大體量」大模型。

省 :1元=1700000 tokens,成本為Mistral-Medium百分之一

那麽,這個能夠 「以小博大」 ,頗有四兩撥千斤意味的大模型,到底什麽來頭?

不賣關子,它正是由清華系初創公司 面壁智慧 最新釋出的旗艦終端大模型—— MiniCPM 。

並且團隊還給它起了個別具一格的昵稱—— 小鋼炮 。

而在眾多亮點之間,最令人意外的還是小鋼炮用2B的「姿勢」所表現出來的效能。

例如與同樣是采用「以小博大」路數的大模型標桿之作Mistral-7B做比較,小鋼炮多項標準測試成績均勝出:

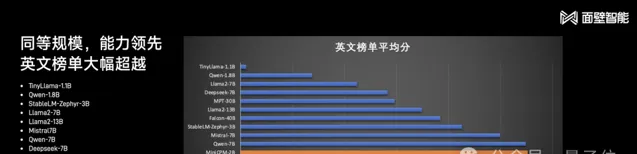

再把與小鋼炮同「體量」的選手拉出來,大部份能力依舊是處於領先,並且英文能力還是較為出眾的那種:

即使把Mistral-7B更大的模型拉進來同台比擂,例如Llama2-13B、MPT-13B、Falcon 40B,多項成績較為出眾的仍是小鋼炮:

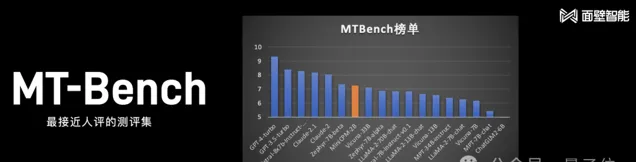

若不論大模型的尺寸,把主流的全部囊括進來,在最接近人評的測試集MT-Bench中比較,小鋼炮也取得了較為不錯的成績:

不僅如此,根據面壁智慧CEO 李大海 的介紹:

int4量化版小鋼炮,可以在快閃記憶體套用壓縮75%的情況下,效能可以做到基本無失真耗。

有一說一,成績和榜單是大模型能力的一方面,但更重要的還是要看大模型在實際套用中的效果。

2B「小鋼炮」效果一覽

老規矩,我們還是從不同維度來看下小鋼炮的實際套用效果。

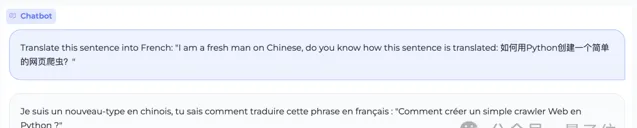

中英夾雜提問,精準轉譯成法語

讓大模型在兩種語言之間做轉譯已然是件常見的事情。

團隊在現場給小鋼炮的轉譯任務加了一把難度,中英混合提問,並要求把整句轉譯成法語:

Translate this sentence into French: 「I am a fresh man on Chinese, do you know how this sentence is translated: 如何用Python建立一個簡單的網頁爬蟲?」

從轉譯結果來看,小鋼炮準確地理解了中英混合的表述,並按照要求給出了精準的法語轉譯。

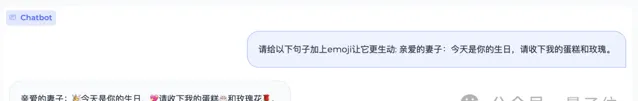

如果讓人類給一句話添加emoji,那麽過程大致是要先理解這句話,然後再在恰當的位置塞進emoji表情。

那麽這個任務小鋼炮是否能hold住呢?

請看結果:

生日是要 的, 和 也精準塞進了恰當位置,最重要是小鋼炮理解到了這句話是表達愛意 。

再如「山東省最高的山是那座山,它比黃山高還是矮?差距多少?」這樣的問題,小鋼炮也是輕松應對:

小鋼炮給自己寫程式碼

大模型對給定的任務寫程式碼現在也是司空見慣了。

如果讓大模型給自己寫段程式碼呢?請聽題:

編寫一個Python程式來實作一個MiniCPM模型(Transformer結構,40層,每層維度為2304,詞表大小為122753)。

小鋼炮在接收到任務之後,隨即開始「自己給自己寫程式碼」,並且每一步的步驟內容也是非常清晰:匯入所需庫→定義模型結構→定義訓練和評估函式→訓練模型→評估模型效能。

多模態首次上手機

正如我們剛才提到的,小鋼炮的亮點之一就是它是業界第一個在端側部署多模態的大模型。

在現場,李大海也對此做了相應的展示。

例如先「餵」給手機裏的小鋼炮一張圖,並提問「這個蘑菇的名字是什麽?有毒麽」,小鋼炮就會先看圖再作答:

這根蘑菇的名稱是「蠅鵝膏」。它有毒,可以引起惡心、嘔吐和腹瀉等癥狀。

當然,連續追問、上下文對話也是不在話下:

據了解,上面展示的這些能力都是在量化版小鋼炮+OPPO手機+驍龍855芯片這個配置之下完成的。

之所以如此,是因為團隊想要展示小鋼炮是一個 「省錢的大模型」 。

怎麽理解?

剛才手機裏GPU的成本大約600元,每秒7.5tokens,假設執行5年報廢,共計170萬tokens,則其推理成本僅為1元。

如此,便可以得到一個成本公式:

1元=1700000tokens。

相比GPT-4的推理成本,1元=4700tokens,可以說是指數級的把價格打下去。

即便是與Mistral-medium相比,成本也是其1/100。

這次也同步開源了一個更大也更好展示多模態能力的 OmniLMM-12B ,玩法就變得更多了。

例如舉著手機,在網路攝影機下方比劃石頭、剪刀、布,並向小鋼炮提問:

我現在玩的可能是什麽遊戲?

小鋼炮看完之後,在理解基礎上便會開始作答:

你可能在玩的遊戲是石頭剪刀布。

然後繼續給小鋼炮看一眼「拳頭」,並行問:

手勢在遊戲中是什麽意思?

繼續給小鋼炮看一眼「拳頭」,並行問:

如何在遊戲中贏我?

小鋼炮思考片刻後,給出了正確答案:

要在遊戲中獲勝,另一玩家需要出布。

值得一提的是,從上面的演示中,我們可以看到小鋼炮在處理過程中是有一段時間的延遲。

現場也有人調侃說「我看這個視訊演示沒有加美顏」(指加速處理)。

對此,面壁智慧聯合創始人、清華大學副教授劉知遠回答說:

沒錯,我們不加「美顏」,比較樸實。

而且小鋼炮在多模態這塊還是提高的空間的。

怎麽做到的?

整體來看,面壁智慧在技術路線上一直高舉「高效」大旗,主要是從AI的三大要素作為突破口,即算力、演算法和數據。

在 算力層面 上,面壁智慧認為「Infra是大模型創業護城河」,Infra可以決定一家創業公司的技術上限。

若是沒有一個足夠「能打」的Infra,即使短期內能夠打造較好的模型,但越往後、越深入時會發現很快就會遇到技術瓶頸。

因此,在早年前,團隊便在業內較早地提出了BMTrain,一個分布式的高效訓練框架。

有了它,很深入地最佳化工作就可以快速地結合Infra落地實作。

除此之外,團隊陸續還推出了高效推理框架BMInf、高效壓縮框架BMCook,以及高效微調框架BMTune等等。

有這些具體的工具,便形成了面壁智慧在算力層面的殺手鐧——面壁ModelForce,全流程最佳化加速套件平台。

在 演算法層面 上,面壁智慧在技術發展過程中所積累出來的利器則是面壁模型沙盒(Model Sandbox)。

這實則也是一種方法論,可以將大模型從過去的煉丹形式變成了一種實驗科學。

而在歷經上千次的模型沙盒實驗之後,團隊在演算法中的各種細節上也得到了一系列業界最優配置。

例如最優批次大小(batch size),可以大幅節省大模型訓練時的token量;再如所有尺寸的模型可以透過最優的超參數的配制,保證訓練任意大小的模型取得最好的效果等等。

最後在 數據層面 上,優秀的數據也決定了大模型最後效能的成敗。

而這次小鋼炮的誕生,面壁智慧僅僅是用了所積累的優質數據中,透過方法論所精選出來的1T。

值得一提的是,為了行業更好的交流和發展,面壁智慧開源了訓練、退火兩個階段來的數據配方來供參考。

除此之外,與小鋼炮相關的更多技術細節以及如何在手機上部署的教程等,均已經在GitHub中開源。

感興趣的小夥伴,可以在文末連結處了解更多詳情~

不過最後,還有一個問題值得討論來一波:

大模型,為什麽往「小」了搞?

其實在2023年,在大模型以小博大方面,便已經開始有了苗頭。

最為典型的,就是小鋼炮此次對標的Mistral-7B。

在它剛剛出道之際,便以更小的「姿勢」擊敗了更大體量的Llama2-13B、Llama 1(34B)等一眾大模型。

這就為「比大更大」內卷下的模型圈帶來了一定啟發。

不過在此背後,大模型往「小」了做,所體現的是一種更大的趨勢。

一方面,從大模型從2022年底爆火至今,一個非常明顯的變化就是從專註訓練,逐漸轉向推理。

這是一個技術發展必然的結果,要從比效能和結果,到比誰的大模型更好用;而這個「用」,最好、最直接的體現就應當是在端側誰可以更「多快好省」地執行。

對此,李大海表示:

站在大模型時代之下,我們都在提的一個概念便是「AI原生套用」;這個時代需要的全新作業系統,就是AI原生套用+AI原生硬體。

而其中的AI原生硬體,其實很簡單,就是只要能在端側執行大模型的硬體就是原生硬體。

因此,端側的大模型就顯得格外重要。

另一方面,市場的表現也是印證大模型往「小」發展的一點。

自從去年7月開始,非常明顯的一點是,眾內送流量備援容錯機制流手機廠商、PC、汽車品牌,陸續在宣布接入大模型。

手機廠商例如華為、小米、榮耀、OPPO、Vivo、三星等;車企包括小鵬、蔚來、理想、吉利等等。

需求之大,可見一斑。

值得一提的是,從小鋼炮在GitHub開源的內容來看,目前它已經在眾多品牌的老機型上做了部署實驗。

因此,老手機上跑大模型也成為了一種可能。

不過細心的朋友也註意到了,面壁智慧其實從成立至今,也僅有短短一年的時間。

這就不禁讓人發問:一年時間是如何在技術上做到的這般突破?

其實在此背後,更多的是清華系成員們在公司成立之前,長久以來在技術上的積累與跟進。

早在2018年,面壁智慧的核心技術團隊在BERT釋出之後,便聚焦在清華NLP實驗的相關工作,釋出過全球第一個知識指導的預訓練模型ERNIE。

隨後在2020年,他們也作為「悟道」大模型先發主力陣容釋出了全球第一個20億級中文開源大模型CPM 1,也持續參與了之後的CPM 2和CPM 3。

除此之外,在2022年,在開源相關工作中,面壁智慧核心成員也參與到了OpenBMB開源社群的成立與運作。

由此可見,面壁智慧的核心技術成員是屬於中國最早進行大模型研究的那一批。

正是基於這樣的技術積累,也就不難理解面壁智慧為何能夠在短短一年時間內交出如此之多的「作業」了:

據了解,截至目前,面壁智慧擁有100多人的科研團隊。

雖然平均年齡僅為28歲,但清北含量高達80%,也有來自阿裏、字節、百度等國內外知名大廠的工程團隊。

加上團隊還主打一個「雙CP」組合,即大將裏的「小哥哥」+「小鮮肉」裏的大將,這種經驗與創新的碰撞,或許也是推動發展行程的原動力之一。

誠然,開年小鋼炮的釋出給大模型帶來了不少驚艷,但也正如團隊所說,相關工作還有許多需要改進之處。

因此面壁智慧在接下來的新進展,是值得關註的。

One More Thing

在小鋼炮釋出現場,一張 五道口大模型Valley 圖格外吸睛。

用李大海的話來說:

這是全中國大模型最密集的地區。

嗯,五道口,不愧是「宇宙中心」。

開源地址(內含技術報告):

MiniCPM GitHub:

https://github.com/OpenBMB/MiniCPM

OmniLMM GitHub:

https://github.com/OpenBMB/OmniLMM

— 完 —