整理 | 王軼群

責編 | 唐小引

出品丨AI 科技大本營(ID:rgznai100)

「如果說 2023 年是科技行業人工智慧聊天機器人年,那麽 2024 年將是人工智慧基礎設施年。」數百億美元正在迅速投入到支持人工智慧繁榮的幕後技術上,且這種狂潮可能會持續很長一段時間。

微軟、Meta 和谷歌母公司 Alphabet ,僅在今年的前三個月,在數據中心和其他資本支出上的支出合計就超過了 320 億美元。這些公司均表示,並沒有計劃放慢人工智慧支出。Meta 更表示,需要在人工智慧芯片和數據中心上投入比之前透露的更多數十億美元的資金。

AI Infra和大模型基礎設施正在成為全球熱議的話題。在剛剛結束的2024全球機器學習技術大會上,有關AI/LLM Infra的與會嘉賓,也分享了自己的相關觀點與實踐經驗。

MiniMax用雲實作規模效應,讓效果和收益最大化

4月中旬,MiniMax 釋出萬億參數MoE大模型,這背後就需要強大的基礎設施技術支持。在 2024 ML-Summit 上,MiniMax 技術總監星龍帶來了【大模型 AI Infra 挑戰與實踐】的技術分享。

MiniMax 技術總監 星龍

星龍表示,基於靈活性跟成本的考量上,MiniMax 根據以下原則決定哪些業務需要留在雲上,哪些要跟雲廠商去合作:

資源角度,MiniMax 把所有的線上的業務,包括CPU伺服器、中介軟體及整體架構全部放在雲上。星龍認為,對於業務來說,其實快速發展和它的高效和穩定是第一要義,其實 CPU 資源作為一個並不稀缺資源,對於雲的儲備的邏輯和規模效應,具備一些成本上和靈活性上優勢,在雲上非常容易開出百萬盒這樣量級的彈性資源。

在 GPU 上,MiniMax 把部份場景遷移到IDC裏。在雲上 GPU 也作為一種稀缺資源的存在,各種原因讓GPU上雲喪失了靈活性和成本優勢。因此,MiniMax 考慮將特定能力遷移到 IDC 。

從基礎元件的角度來說,用雲可以達到規模化效應,使得效果和成本收益最大化。

從成本解決和規模化部署上來看,雲更有動力和更有能力去最佳化。雲有眾多客戶以及一個巨量的規模,在此規模下,人力的投入成本完全可以被攤薄,成本也是雲的核心的考慮因素。

雲的定價和透過技術最佳化能夠帶來的成本的下降,可以直接影響到其運轉邏輯。所以從驅動力的角度來說,星龍認為雲是更有驅動力和能力去做好 Infra ,所以MiniMax並沒有選擇基礎設施的大額投入而直接選擇了 用雲。

最後,從業務架構的角度來說,MiniMax 與多家雲有非常不錯的合作和協作。雲在這裏邊作為一種載體,是一個封閉的、但內部開源的社群,供人們交流方案及設計思路,本身在架構設計上也能給大家提供更多的視角和更充分的討論空間。

在整個訓練的全鏈路去講,所有的裏程其實先取決於數據。

在數據分布中,存在大量多模態和無結構化數據,以及工具鏈與技術棧之間的差異,處理這些混合資源需要用GPU開加速,並提升處理效率。MiniMax 的解決方案是半結構化的場景保留 Spark、非結構化場景使用 Job 作為靈活性的補充,並逐步改造為 Ray,以解決計算效率和叠代效率的問題。

在數據處理中,資源供給是制因數據處理速度的關鍵問題。從集群維度來看,需要在多個集群之間建立統一入口,以便更好地調配資源;從時間維度上,要充分利用好不同集群的空閑時間。在單機資源維度,也要利用好空閑的 CPU 和 GPU,以此來提升數據處理的效率。

儲存解決方案上,Posix 檔協定為主,提供 HDFS/S3 協定;遠端緩存以及本地高速臨時讀寫。

大規模訓練集群構建環節,排程層架構中,透過佇列控制和分發統一平台入口層;集群層上基於 Volcano 二次開發的批排程器來作為資源分配的元件;物理資源層只用裝置外掛程式(非虛擬化),Kubernetes 來管理裸金屬資源。網路架構采用 FatTree 結構, IB/RoCE;NCCL 統一封裝, 針對網路特點/故障做最佳化。

關於未來業務展望,星龍表示,MiniMax 在以下三個效率層面會逐步最佳化提升:

機器效率 : 最佳化訓練效率, 做 Profiling 提升訓練框架的訓練效率;提升模型 MFU;調整機器排布和最佳化通訊演算法來降低通訊耗時。

工作效率 : 故障頻繁導致人的運維比例高;技術棧不匹配導致存在學習上手成本;技術選型/資源限制導致無法選擇更加靈活的方式。

組織的效率 : 固化好習慣、具備傳遞的能力;技術選型/資源限制導致無法選擇更加靈活的方式。

如何迎接推理算力爆發時代的到來?

「推理就像2000年的互聯網,目前還沒有普遍使用,5年之後將迎來爆發。」 PPIO 聯合創始人 & CTO 王聞宇在大會演講上表示,他帶來了【如何做到算力基建和推理最佳化的「軟硬兼施」與創新突破】的主題技術分享。

PPIO 聯合創始人 & CTO 王聞宇

「那麽,我們如何迎接推理算力爆發時代的到來?」

王聞宇表示,當下,推理面臨成本貴、大模型參數越來越大、多模態模型讓推理成本再提高2個數量級、推理效率低、業務場景豐富但落地鏈路長等一系列現實問題。如何能把推理成本降下來?他分享了分布式雲與 AI 推理加速兩個方法。

分布式雲方面,充分動員市場的社會、經濟、技術三大驅動力,以獲得更便宜的生產資料,包括 GPU 卡與電力能源等。

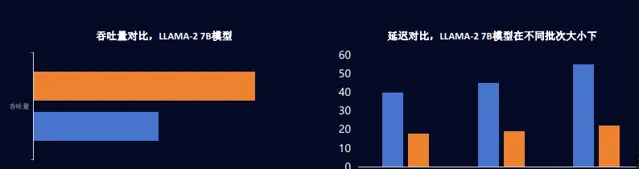

AI推理加速方面也存在巨大空間。推理體系最佳化目標包括,降低首詞時延與延逐時延,增加吞吐量,以降低成本提升推理效率。

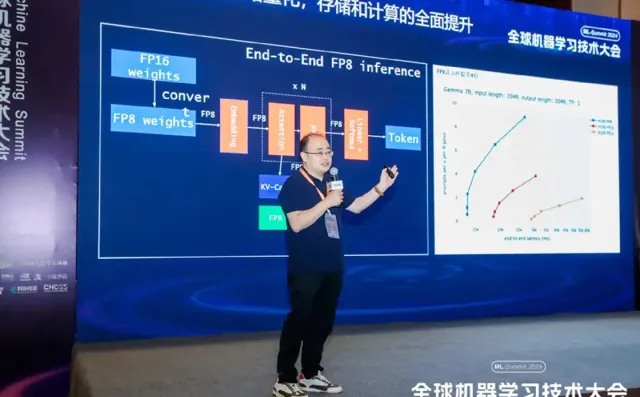

視訊記憶體、算力、頻寬,是制約效能的三要素。對此,派歐雲PPIO做了推理最佳化,即演算法、系統、硬體的協同創新,包括演算法最佳化、統一推理框架以及硬體適配。

算子融合基礎上,重點關註註意力及 KV-Cache,提高每次數據搬運的計算效率,以虛擬記憶體的方式管理視訊記憶體來減少視訊記憶體碎片,采用 Continous Batching 減少無效視訊記憶體占用以提高視訊記憶體利用率,共享 Context 來減少計算量和視訊記憶體開銷,混合量化來壓縮模型以提高視訊記憶體利用率。

此外,采用稀疏化和硬體化的措施:稀疏化加速 HyperAttention 提速效果顯著;稀疏化計算,權重稀疏,減少計算量,KV Cache 稀疏已減少儲存,可支持長上下文視窗。

在這方面的實踐上,派歐雲推出了派歐算力雲 AI 算力產品,產品包括 GPU 算力集群、GPU 裸金屬、 GPU 容器和 GPU Serverless。透過提供豐富的 GPU 型號、極致的效能最佳化和廣泛的算力供給,為新一代生成式 AI、雲渲染、機器學習和加速計算等場景,提供高價效比的算力服務。「對標大廠,單位算力推理成本下降10倍。」

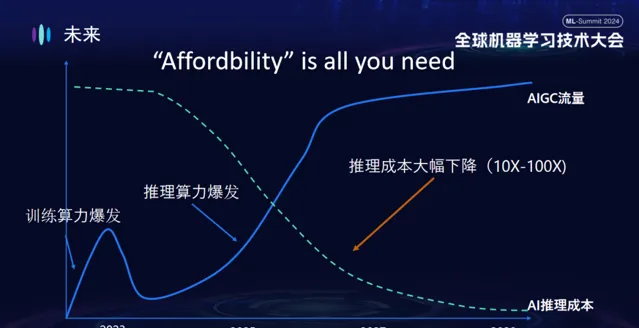

最後,王聞宇憑借自身連續創業經驗,回顧了過去30年線上音視訊的發展,他指出,網路傳輸成本的逐年降低和音視訊編解碼壓縮率的不斷提升,成為推動行業發展的兩大關鍵力量。

同樣在AI領域,王聞宇表示,未來推理成本將大幅下降,「‘Affordbility’ is all you need」。

分布式訓練對 Infra 的挑戰在哪?

「分布式訓練對 Infra 的挑戰有三點:節點規模越大、作業的故障率越高,如何快速擴容的挑戰;

節點規模越大、通訊開銷越大,如何提升訓練速度的挑戰;模型越大、視訊記憶體需求越大,如何提升視訊記憶體利用率的挑戰。」螞蟻集團 Al Infra 技術專家王勤龍在技術分享主題演講時指出。

螞蟻集團 Al Infra 技術專家 王勤龍

王勤龍目前負責螞蟻集團的 PyTorch 大模型分布式訓練引擎,為螞蟻 AI Infra 開源計畫 DLRover 的架構師,專註於打造穩定的、可延伸的和高效的大規模分布式訓練系統。他在本次大會上帶來了【 DLRover 訓練故障自愈:大幅提升大規模AI訓練的算力效率】技術分享。

大模型訓練中,包括訓練樣本數據集、Transformer 架構、預訓練、模型微調、AI 套用幾個環節。這其中面臨著模型尺寸越來越大從而帶來的分布式訓練對 Infra 的挑戰。那麽如何應對上述的挑戰,王勤龍分享了螞蟻 AI 工程技術棧實踐。

訓練故障自愈:將千卡分布式訓練有效時間占比 > 97%,降低大規模訓練故障導致的算力浪費。

訓練最佳化 ATorch:自動根據模型和硬體選擇最優的分布式訓練策略,千卡(A100)集群硬體算力利用率 > 60% 。

訓練最佳化器:相比 AdamW 提升 1.5x 的收斂加速。相關成果分別發表在 ECML PKDD’21 ,KDD’23,NeurIPS’23。

視訊記憶體與傳輸最佳化 GLake:視訊記憶體+傳輸一體化最佳化和全域視訊記憶體最佳化,將訓練視訊記憶體需求降低 2-10 倍,成果釋出在 ASPLOS’24。

「故障是導致算力浪費的一大重要原因。」王勤龍表示,這是由於故障頻繁且排查費時長、Checkpoint 保存與回滾開銷大、千卡訓練65B 模型耗分時布等因素導致。

他透過 Meta 訓練 OPT-175 B 真實案例來說明這一點 ,其使用 992 80GB A100 GPU,共124台8卡機器;按照 AWS 的 GPU 價格,每天需要耗費約70萬; 訓練 2個月內,故障導致掛了至少35次;無故障下預估需要33天,實際卻執行了2個月。

對此,DLRover 訓練故障自愈功能可支持 GPT、LLAMA、VIT、GLM AI模型;采用分布式訓練框架,包括 Atorch、DDP、FSDP、DeepSpeed、Megatron-LM,透過Flash Checkpoint 快速匯出;分布式作業包括 ElasticJob 彈性排程,以及 ElasticJob 和 Kubeflow/PyTorchJob 節點檢測,分布式集群采用 Kubernetes Cluster,AI 芯片支持輝達及 Ascend 910、含光 PPU 等國產芯片。

DLRover 彈性容錯訓練,為 Master-worker 架構,Master 部份包括節點排程、節點狀態監控、動態組網編排,Worker 部份管理訓練子行程、分析 cuda event、獲取錯誤棧。DLRover 故障檢測氪完成異常診斷、自動節點檢測、自動擴縮容。錯誤日誌診斷與報警上,DLRover 可自動收集訓練行程的錯誤,聚合所有rank的錯誤棧診斷並報警。故障碼診斷上,DLRover 可根據 Pod 的結束碼辨識故障原因並自動恢復,支持使用者根據結束碼自訂處理機制。

DLRover 在啟動訓練之前會在每個節點上執行,GEMM 和allgather 檢測節點是否正常,不正常則隔離;支持各種 AI 處理器的檢測,如 GPU,Ascend-NPU;支持自訂檢測指令碼來支持 AI 處理器。

王勤龍還闡釋了擴縮容的必要性。節點隔離後可能導致可用節點減少,機器修復後可用節點增多,需要手動修改訓練節點配置,擴容可帶來可用節點減少後訓練自動縮容、新節點加入後訓練自動擴容、整個過程無需人工幹預的好處。

大模型 Checkpoint 的特點包括,保存 Checkpoint 時需要停止訓練,模型很大會導致保存時間長,比如176B Checkpoint 約 2TB。因此,大模型常規 Checkpoint 的挑戰包括保存間隔短,保存會占用大量時間,而保存期間訓練停止;保存間隔長,故障恢復後回滾 Checkpoint 浪費大量叠代。

對此,DLRover Flash Checkpoint 可透過記憶體匯出、異步持久化、斷點存續、記憶體備份等環節,快速save/load。

與 Megatron-LM 相比,DLRover 並列匯出 Checkpoint 具備節點都參與保存和載入、無額外通訊和記憶體需求,以及單節點保存參數量小、持久化時間短的優勢。

DLRover 支持開源與開發者共建上。已釋出的開源版本有:

V0.1.0(2023/07): k8s/ray 上 TensorFlow PS 的彈性容錯和自動擴縮容。

V0.2.0(2023/09) : k8s 上 PyTorch 同步訓練的節點檢測和彈性容錯。

V0.3.5(2024/03): Flash Checkpoint 與國產卡故障檢測。

DLRover V0.4.0 預計今年6月釋出,效能將在執行 hang 檢測與效能監控、拓撲感知排程與 rank 重排上有所提升。

王勤龍表示,DLRover後續規劃上包括以下四個層面:

節點排程與管理:通訊拓撲感知排程,降低 AllReduce 通訊時頂層交換機的流量;硬體 Metric 收集與故障預測。

編譯最佳化 lynx:計算圖排程最佳化,達到最優的通訊與計算重疊,隱藏通訊時延;SPMD自動分布式訓練。

訓練最佳化框架 ATorch:RLHF 訓練最佳化;分布式訓練的初始化加速;自動訓練加速配置 auto_accelerate。

國產卡訓練:將故障自愈、訓練加速等功能擴充套件到國產卡上;提供國產卡訓練的最佳實踐。

開源地址:

DLRover: https://github.com/intelligent-machine-learning/dlrover

GLake: https://github.com/intelligent-machine-learning/glake

曙光儲存自研 AI 大模型,加速行業套用落地

「在算力、演算法、數據這 Al 三要素中,數據的影響力激增,數據品質高低決定大模型智慧化程度。曙光儲存自研 XDS 技術,提升AI大模型訓練效率,加速行業AI套用落地。」中科曙光儲存產品事業部副總經理、曙光儲存公司副總裁楊誌雷,帶來了曙光 AI 大模型儲存實踐分享。

中科曙光儲存產品事業部副總經理、曙光儲存公司副總裁 楊誌雷

從文本生成到文生視訊,AI 大模型技術叠代開啟加速模式。楊誌雷認為,在此趨勢下,四個層面表現出技術收斂:

模型基礎架構收斂:由 CNN/LSTM/GAN 等多種架構,收斂到基於 Transformer decoder 架構。

主流模型數量收斂:由數萬小模型,收斂到主流基礎大模型10~20個、外部開源可獲取約5個的模型數量。

客戶自研算子收斂:由客戶自訂算子數量巨大、適配最佳化難度高,收斂到客戶自訂算子數量可控。

主流開發框架收斂:由 PyTorch、TensorFlow,Caffe、飛槳等多框架,收斂到 Pytorch 框架為主,占據90%以上。

楊誌雷表示,AI大模型行業落地加速且愈加「實用化」,離散小模型匯聚到基礎大模型,一年內行業通用場景數據可支撐通用場景大模型,2年內生產場景核心數據將支持形成行業生產場景大模型。

場景需求上,楊誌雷判斷,數據的品質愈發重要,作為高品質數據集載體的儲存系統成為大模型核心基礎設施。他強調,縮短數據讀寫時間是提升訓練效率的根本需求,其中 Checkpoint 期間訓練是中斷的,需要提高吞吐,使 Checkpoint 耗時盡量小,以提高計算資源利用率。

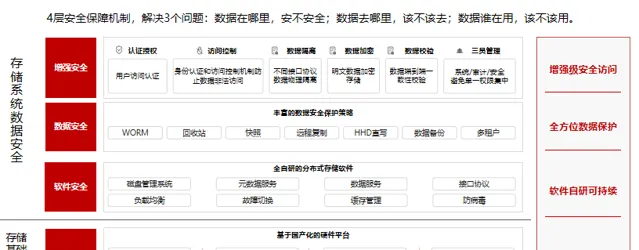

大模型給數據基礎設施帶來的全新挑戰,包括超大規模數據預處理耗時長、模型訓練算力空載高、行業數據套用存在風險,由此帶來的儲存訴求有數據生命周期中智慧分級與融合協定、存取低時延、高速數據讀寫、儲存原生安全等問題。

曙光儲存從行業標準流程範式需求,提煉出企業級AI儲存解決方案訴求,推出了豐富的產品系列,包括分布式儲存 (OStor 系列、UStor 系列)、儲存方案產品與服務、集中式儲存、全國產化儲存,覆蓋先進計算、營運商、金融、科研教育、能源勘探、生命科學、雲端運算、自動駕駛多個行業需求。

曙光AI大模型儲存解決方案在異構融合上,單集群支持多模態數據完整開發生命周期,千億級檔儲存與智慧管理;效能上支持計算節點本地快取套用,XDS 數據加速:基於 DMA 縮短 I/O 路徑,面向 GPU DirectStorage 最佳化;原生安全上,儲存節點內提供芯片級安全能力,提供安全可靠集群儲存服務。

曙光儲存 AI 大模型儲存解決方案,面向 AIGC 多種業務場景,根據 Dataset 大小、效能需求,ParaStor 提供基於客戶端 MEM、NVMe SSD 等高速介質的多級緩存加速方案。縮短數據操作耗時,加速 Checkpoint 數據寫。

其 XDS 核心技術,在縮短 I/O 路徑上表現優異,在使用者態提供 xdsfile SDK(開發工具包),與 libcufile 互動,確認檔案系統註冊資訊,啟動 GDS 數據傳輸方式,效能提升3倍以上,支持 GPU 多通道。

AI 伺服器通常會有多路 GPU 和 IB 卡,曙光儲存增加儲存系統客戶端多路徑支持,能夠讓多個 GPU 都透過最佳路徑讀寫數據;GPU 與多網路介面間通訊速度不同(與在PCIe中的連線拓撲有關),IO 請求,要與「最短路徑」 的網路介面進行數據傳輸;在「優先路徑」不可用的時候,也可以從「次優路徑」發出。

其邏輯節點的數量根據集群規劃確定,一個物理節點可以加入多個邏輯節點組,各個物理節點上的邏輯節點可以互為主備;透過間接索引,可以讓一個目錄包括大量後設資料檔,實作大容量目錄;目錄進一步分片,將目錄後設資料散部到多個邏輯節點,進一步擴大容量,將負載分擔到多個邏輯節點組。硬體加解密引擎適用於大封包(4K)場景,儲存加密、安全閘道器等,支持國密指令集。

在客戶的客製需求實踐上,曙光儲存幫助使用者提升自動化程式碼開發與多模態互動能力,可用於文本生成、語言理解、程式碼生成、邏輯推理、程式碼生成、補齊、糾錯、解釋和單元測試生成;ParaStor 加速大模型訓練平台相比傳統 SSD 混閃檔儲存,分鐘級寫入 3TB CKPT 數據,整體訓練效率可提升 50% 以上。

儲存與互連頻寬成為大模型技術棧的關鍵效能瓶頸

「長文本/視訊等大序列大模型,模型層間的數據傳輸總量明顯超過模型權重,對於儲存與互連頻寬的要求有數量級提高。在大序列大模型的需求帶動下,向量資料庫成為計算的外腦,長文本/視訊數據的載入速度限制了算力的有效利用率,儲存與互連頻寬成為大模型技術棧的關鍵效能瓶頸。」千芯科技董事長陳巍博士在【視訊大模型架構解析及其芯片級訓練部署挑戰】的技術分享中表示。

千芯科技/中存算董事長 陳巍

首先,陳巍闡釋了弱 AI、通用 AI、超級 AI 的概念區分,目前我們正處於走向通用AI的階段。

視訊大模型發展歷程

當前,視訊大模型(VLM)成為大模型新熱點,大模型即大語言模型(Large Language Model)目前主要基於 Transformer 架構;目前大模型的研究趨於成熟,考試能力可以超過本科生的平均水平。

陳巍總結道:之前的多模態 GPT-4 是讓大模型睜開眼看靜態世界,那 Sora 就是讓大模型體驗這個世界的變化和規律;隨著技術的進步,大模型可能逐步具備更強的認識世界的能力。

陳巍博士從 Sora 等視訊大模型的架構分析,說明大模型發展趨勢下儲存和互連頻寬的重要性。

目前分析 Sora 的主幹架構是擴散 Transformer,前後端使用了 VAE 或 VQ-VAE-2 進行壓縮。擴散 Transformer 由 ViT(Vision Transformer)與DDPM或RADM組成。也就是說,

Sora≈DiT+VQ-VAE-2 = ViT+DDPM/RADM+ VQ-VAE-2。

預估 Sora 模型整體架構包括:

時空壓縮器先將原始視訊對映到潛空間;

然後,ViT 處理標記化的潛空間表征並輸出去噪的潛在潛空間表征;

以類似 CLIP的對映機制接收 LLM 增強的使用者指令和潛空間視覺表征,以指導擴散模型生成風格或主題視訊。經過多次去噪,獲得生成視訊的潛空間表征,然後使用相應的解碼器對映回像素空間。

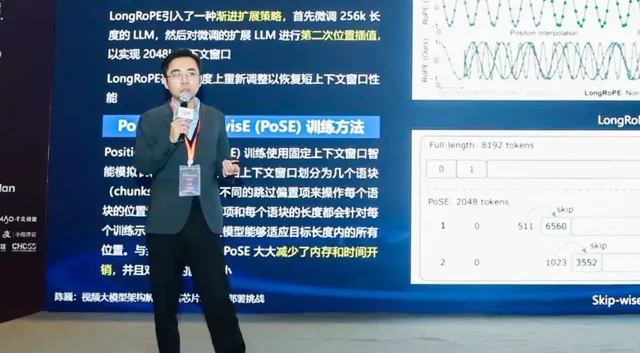

視訊大模型的關鍵技術,包括多尺寸視訊輸入處理 NaViT(Native Resolution ViT)、VQ-VAE 的向量空間壓縮與 VQ-VAE-2 架構、時長擴充套件技術(EGV)、旋轉位置嵌入(RoPE)、LongRoPE 與 Position Skip-wisE (PoSE) 訓練方法。這些技術的引入對計算系統提出了比以往更高的要求。

特別是2024年,使用者需求逐漸由短文本短視訊轉向長文本長視訊。Sora等視訊大模型和長文本大模型都屬於大序列大模型。其特點是模型層間的數據傳輸總量大,明顯超過大模型權重。大序列大模型對於儲存與互連頻寬的要求與以往有很大的區別。

視訊大模型訓練與部署面臨的主要挑戰包括:

資料庫與儲存頻寬重要性升級:由於視訊大模型關聯的數據量巨大,對於資料庫與儲存頻寬的要求明顯超過了以往。

儲存與互連成為新瓶頸:在大序列大模型的需求帶動下,資料庫成為計算的外腦,長文本/視訊數據的載入速度限制了算力的有效利用率,儲存與互連成為技術棧的主要效能瓶頸。

從訓練角度看,Sora 的訓練包括文生圖預訓練(也包括圖生圖)、視訊生成預訓練、視訊生成的微調三個階段。Sora 使用視訊壓縮網路(Video Compression Network)來「壓縮」視訊,將圖塊轉換成統一且資訊更小的形式,即低維或者壓縮潛空間,並重構為時空潛圖塊。陳巍表示,這一壓縮非常重要,因為壓縮後的圖塊可以大幅降低訓練與推斷的計算負荷,使 Sora 能夠在訓練過程中更加高效的學習海量數據。

從訓練過程看,Sora 等 DiT 類文生視訊模型的訓練對序列並列性有更高的要求,其訓練具有以下特點:

與語言類大模型對比,DiT 模型參數量可能較少,但序列可能很長,節點之間的通訊和儲存極容易成為瓶頸;

由於目前 DiT 模型規模相對較小,因此需要重點提升節點內的序列並列性。

例如最近推出的大序列大模型的訓練方法 FastSeq,適用於大序列和小規模並列的新型序列並列訓練方法。與傳統的模型並列或參數並列不同,該方法側重於為每個 Transformer 層僅使用兩個通訊運算子來最小化序列通訊資源占用。並使用 AllGather 來提高通訊效率,采用異步環(Async Ring)將 AllGather 通訊與 QKV 計算時間重疊,減少等待,進一步最佳化效能。

「算力與數據頻寬共同決定 AGI 前進演化的速度。」陳巍總結出以下三點:

視訊大模型的頻寬瓶頸凸顯:相對而言,視訊類模型需要更大的訓練數據集,數據集大量數據的儲存和傳輸會成為計算架構的主要瓶頸。

互連瓶頸嚴重制約模型訓練速度:目前傳統 GPGPU 集群是基於光交換機/路由的點對點傳輸方式,這類傳輸方式導致大量數據在光交換機/路由處集中,形成傳輸瓶頸。另外傳統 GPGPU 本身的集中化儲存模式也不利於大量數據的交換與通訊。

新架構能否轉向最佳化頻寬:因此 Sora 等視訊大模型技術的大量套用,必然對現有的計算芯片,包括 GPGPU 和各類 AI 芯片提出更高的數據頻寬要求。新架構或許能更好解決頻寬問題。

從芯片到集群的5級存算一體技術棧

鑒於傳統 GPGPU 編程模型的互連效率偏低、互連成為集群訓練的主要瓶頸,陳巍闡釋了從演算法到芯片的大序列模型訓練與部署方案。

針對大模型計算的 Soft Sparse Ring 計算方案,即整合軟稀疏化計算(CPU與AI芯片協作)與 Ring Attention。透過軟稀疏化計算方案,計算的稀疏部份解除安裝到CPU上,AI 芯片(含 GPGPU )僅進行稠密計算。透過 Ring Attention 減少存取外存的消耗。該計算方案可明顯減少大模型的 Inference 和 Training 時間,降低計算平台的綜合成本。

從芯片級存算一體到集群級存算一體的技術整合。千芯科技與合作方共同推進5級存算一體的技術架構解決方案,從芯片級、封裝級、介面級、互連、集群級應對視訊大模型和長文本對於頻寬的多種挑戰,陸續推出三代存算一體計算卡,其中第三代支持大模型+片上 RAG/Embedding。

與合作方共同推出的企業級大模型伺服器

國產硬體芯片如何做好推理最佳化?

「未來推理最佳化有以下幾個方向:更小的終端模型、更極致的壓縮、兩階段分離的推理範式和異構計算環境中做更好的排程。」清昴智慧科技 CEO 關超宇在【MLGuider:面向國產 AI 芯片推理的最佳化與實踐】技術分享中這樣判斷。

清昴智慧科技 CEO 關超宇

關超宇概括了目前推理市場的現狀:大模型已成為新時代的「水電煤」,底層技術革新帶來基礎設施結構性調整;隨著各家基礎模型以及開源模型的逐漸發展與成熟,模型推理需求量將逐步增長;一般來講,一個成熟穩定的AI業務,其推理和訓練的的比例大約在7:3。

他總結道,國產芯片部署大模型的現狀與挑戰存在於三個方面:

參數量大,推理延遲、成本居高不下:大模型往往擁有數十億乃至成百上千億參數,推理延遲往往無法滿足日常需求(大於15-20 tokens/s),靠堆疊更高算力來降低延遲將帶來巨大的伺服器成本和電力成本。

高並行、高吞吐問題:簡單的部署方案並不能滿足多人同時線上使用的要求。

高端硬體受限,平民化、國產化難:高端卡進一步受到美國制裁,而低端卡算力受限、國產顯卡工具鏈匱乏,部署大模型存在諸多障礙。

為此,關超宇的清昴智慧科技推出 MLGuider,這一面向多芯片的統一推理框架。該框架由模型層、最佳化層、排程層、執行層、算子層、硬體層構成。

在算子層級的效能最佳化上,MLGuider 進行了跨硬體多端算子重構:構建大模型IR,實作模型和硬體的前後端分離;透過樣版展開和自動機器學習,實作算子的「硬體化」最佳化。此外,MLGuider 透過融合多個算子,減少計算核啟動的時間,以及減少中間過程中不必要的數據搬運。

在框架層級的效能最佳化上,MLGuider 實作了視訊記憶體管理與復用、多行程異步分離,以及 pattern 復用。

在排程層級的效能最佳化上,進行並列解碼、模型混合量化、註意力機制最佳化的升級,提供多模型服務。

在某國產 NPU 平台上,同等精度下,MLGuider 框架可以提升20+倍吞吐量,以及降低將近10倍延遲。該方案已上架國產 NPU 雲,支持線上使用。

在某國產GPU平台上,MLGuider 框架在同等精度下相比於廠家 vllm 可以提升50%吞吐量,以及降低近40%延遲。該方案已交付至某 AI 套用客戶以及某雲廠商。

作為 CEO,關超宇介紹,自己的清華系創業公司清昴智慧科技,將持續致力於硬體到軟體全棧產品矩陣,加速企業大模型投產落地。

團結起來建立開放生態,打破巨頭壟斷

在圓桌論壇上,Athena labs CTO 王興明與陳巍、關超宇、王勤龍、王聞宇幾位嘉賓坐下來聊了聊關於「AI Infra 大模型基礎設施」這一議題,當前面臨的問題和各自領域的觀點預判。

AI Infra 大模型基礎設施 圓桌論壇

王興明概括道,陳巍、關超宇、王勤龍、王聞宇四位嘉賓,有人做芯片的,有人做算子最佳化,還有做分布式訓練、做推理最佳化,形成了一個有關 AI Infra 的產業鏈,領域擴充套件到全行業交易範疇。

面對更加復雜的芯片環境,面對更加復雜的計算單元和計算的組成,王興明讓每位嘉賓闡述了各自領域當前最重要的問題所在。四位嘉賓都認為,國內面臨的最大問題是生態,其中包括生態的建立和生態的壟斷。

陳巍表示:「計算成本過高,抑制了人工智慧的發展速度。他以輝達舉例,該公司在半導體領域有70%以上的毛利,領先了92%的企業,市值也是破了萬億,AI 產業中大部份的利潤都被輝達獲得。」

對此,王聞宇表示:「把廉價的生產資料,結合推理加速方案,幫大家把單位場景時推理的成本就是差大概10個億以上是我們在做的事。」

王勤龍表示:「把先進算力轉化成高效訓練的效率,中間有很多 Gap。芯片算力如何轉化成訓練效率,國內國外大家都在貢獻輝達訓練的生態。國產訓練效率的提升,也要在各個行業做客製化的生態。國產芯片如何去發展生態,是芯片領域一個最重要的問題。國產芯片的效果,還需要更多模型訓練生態的貢獻。」

關超宇表示:「國內面臨的最大的是生態問題,跟華為一樣。輝達的壁壘、優勢主要來自於其軟體生態長時間的積累。在國內來講,追趕有很大難度。對國內開發者來講,還有一個不友好的是,每層的技術棧都不一樣,每家的底層技術框架都有很大差別,需要適配和遷移,還要做更深層的最佳化。中短期發展來講,如何統一多樣的產品讓大家方便使用,也是對國內形成統一生態是有挑戰的。」

「當我們做到中間層之後,能解決一些適應力,但是效能無法在多供應商、多標準的情況下做到統一,這是我們在國內當下 Infra 的一些困境。」王興明總結道。

陳巍補充道:「大家都在關註生態問題,但是光生態本身並不成為最大的問題,最大的問題我認為應該是生態的壟斷,不管是軟體和演算法套用生態壟斷,還是半導體裝置和光刻機/原料的壟斷,其實這兩個壟斷對中國影響還是非常大的。」

為此,陳巍呼籲:「大家團結去推動生態建設,使得AI計算生態更加開放、更加開源,使更多的使用者受益,也就很好解決了算力貴、不好用及碎片化的關鍵的問題。」

在對外來的展望上,大家都對國產競爭力的提升抱有積極的態度。

「中國能夠跑出來最先進的模型及算力芯片企業,會逐漸影響 Infra 生態,面對中美技術生態過渡,中國本土的企業,很可能產生更大突破,對世界產生更新的貢獻。」陳巍談到。

「多模態模型會越來越成熟,國內的多模態套用也會越來越多,推理 Infra 會向多模態做更多的最佳化和遷移;數據中心場景上,往邊端上的遷移需求會增加,在端側會有更多AI形式及套用出現;國內商業基建和數據中心基建上,國內 MaaS 和 PaaS 層面逐漸增多,大家獲取 AI 的成本也將降低。」關超宇表達了以上三點趨勢。

「大模型已經跑出百卡、千卡、萬卡的領域,國產卡跑一個千億或者萬億的模型肯定會出來,國產開源大模型也會出來,打磨後肯定能相容市面上的主流模型。」王勤龍表示。

「一年以內的時間,推理的成本會結構化地下降。在國產算力以及國際範圍內的公司的挑戰下,輝達在推理上的領導地位也將很快被打破。」王聞宇預判道。

團結起來,構建 Infra 開放生態,協力打破巨頭壟斷,國內 AI Infra 與大模型基礎設施的崛起世界之時並不遙遠。